Cela fait plusieurs années qu’Apple n’est plus le premier de notre Top 10 des smartphones en photo. Mais l’Américain a tout de même une force : il se place toujours dans le Top 5. Si le classement des terminaux concurrents fluctuent, celui des iPhone est plus constant. Ils sont en photo à l’image des autres domaines : solides et efficaces. Contrairement aux acteurs du monde Android, la progression technologique chez Apple est toujours mesurée, pesée, prudente – et, soyons honnêtes, aussi très frustrante. Le géant de Cupertino n’est jamais en position de novateur, mais dans la stratégie du peaufineur. Or, avec un trésor de guerre de plusieurs dizaines de milliards de dollars, Apple pourrait aller plus loin que tout le monde. Mais préfère agir comme l’acteur le plus conservateur de l’industrie.

Fidèle à cette prudence, il a fallu plusieurs années pour que la société californienne abandonne son sacro-saint capteur 12 Mpix pour un nouveau modèle de 48 Mpix. Un capteur qui produit toujours des images en 12 Mpix (à moins de shooter en RAW). Mais qui profite d’un suréchantillonnage améliorant la qualité d’image, grâce à un supplément de micro-détails et une réduction perceptible du bruit numérique.

Toujours composé de trois modules caméra, les iPhone 14 Pro n’offrent pas de changements physiques immédiatement perceptibles par rapport à la génération précédente (qui ressemblait déjà pas mal à la précédente !). Si voulez un rappel complet de la fiche technique et de la promesse d’Apple, nous avons consacré un long article lors de l’annonce des terminaux – article centré uniquement sur les iPhone 14 Pro/Pro Max.

Module principal : un supplément de détails (mais pas le game changer qu’on attendait)

Rompant avec des années de résolution native, Apple est enfin passé du côté « oversampling » de la Force. Le capteur 48 Mpix que l’entreprise utilise pour son module caméra principal est non seulement le plus grand, mais aussi le plus défini qu’elle n’a jamais utilisé pour un de ces terminaux. Il ne s’agit cependant pas d’un capteur hors normes. Et ses performances, quoique bonnes, ne nous ont pas subjugué (lire plus loin).

Regardons d’abord le verre à moitié plein : oui, ce capteur apporte un supplément de qualité d’image. À vrai dire, surtout pour nous autres « pixel peepers », les testeurs d’appareils photos et autres décortiqueurs de pixels. Car sur l’écran du téléphone, il est assez peu probable que vous puissiez mesurer l’étendue des progrès. Ce qui n’est pas si grave : les iPhone font déjà de bonnes photos pour le grand public, il s’agissait ici pour Apple de satisfaire son public de photographes.

Vu la place de l’iPhone sur le marché et sa spécificité, un test du terminal en photo est la norme chez 01net.com. Et l’arrivée du nouveau capteur 48 Mpix nous a obligé à le comparer à la génération précédente ainsi qu’à un terminal concurrent avec une partition photo solide, le Vivo X80 Pro.

En restant dans le référentiel Apple, vous pouvez voir que la marque a fait du bon travail. Elle a su conserver son rendu des couleurs entre terminaux de différentes générations… dans la plupart des scènes. Car Apple a aussi fait un travail de fond sur la balance des blancs (WB) notamment en basses lumières. Les tons, jadis artificiellement refroidis par le module d’évaluation de la température moyenne, sont enfin plus chauds et plus proches de la réalité – le rendu des lampes au sodium sont enfin justes. Apple reste ainsi l’une des références de l’interprétation des couleurs – et de la constance intermodules.

Cela étant, si les clichés sont propres, le niveau de détails en hausse (même en basses lumières, regardez le zoom à 100% ci-dessus),ils manquent de peps, de caractère. Dans le monde de la photo, on parle de « piqué » pour l’effet de rendu 3D de certaines « vraies » optiques, de velouté pour les transitions des zones nettes vers floues. Et aussi efficace l’optique de l’iPhone 14 Pro soit elle, elle manque de ces deux caractéristiques.

Module principal : mise au point efficace, mais manque d’intelligence

Côté autofocus, si les résultats sont bons dans de nombreuses situations, Apple est désormais en retrait en matière de reconnaissance des sujets. Alors que nombre d’appareils photos et les smartphones de Sony sont de plus en plus à même de distinguer les sujets vivants (non seulement les humains, mais aussi animaux de compagnie, oiseaux, etc.), l’iPhone 14 est en retrait dans ce domaine avec nos amis les bêtes.

Disposant d’un puissant processeur neuronal et d’un ISP maison, le terminal d’Apple n’a pas vraiment d’excuses pour ne pas développer une telle reconnaissance. Cela reste une chance pour la compétition, notamment celle des « vrais » appareils photo. Ici, notre amie Mirage (une très gentille chatte, en dépit de sa tête peu avenante) n’est pas nette pour un sou.

Apple garde l’approche – le dogme ! – né de l’iPhone 4 : priorité absolue au déclenchement pour avoir la scène. Mais quand on voit le suivi du sujet et la rafale d’un Xperia 1 Mark IV, on se dit qu’Apple a encore une sacrée marge de progrès pour proposer un autofocus de « vrai » appareil photo.

Module principal : un vrai/faux 50 mm qui fait plaisir

L’autre usage qui est fait de cette définition de 48 Mpix par Apple est d’utiliser les 12 millions de photodiodes en son centre pour faire un recadrage qui donne un équivalent 48 mm (presque un 50 mm, une focale phare des « vrais » boîtiers photo). Dans cette configuration (le zoom x2), on ne bénéficie pas de l’effet du suréchantillonnage. Mais on profite d’un niveau de zoom intermédiaire proposant une définition confortable de 12 Mpix.

Cette focale virtuelle permet d’ajouter un gradient de zoom « natif » supplémentaire : x0,5 (ultra grand-angle 12 Mpix), x1 (module caméra grand-angle principal 48 Mpix > 12 Mpix), x2 (recadrage du capteur principal) et x3 (téléobjectif équipé d’un 12 Mpix). Cette plus grande granularité de focales donne plus d’outils aux photographes pour construire leurs images sans avoir à passer par les moulinettes logicielles des zooms numériques – aux rendus parfois médiocres.

Si cette focale nous plaît (et elle nous plaît !), pourquoi parler de vrai/faux 50 mm alors ? Simplement parce que recadrer un semblant de 50 mm dans une image capturée avec une focale équivalente à un 24 mm ne restitue pas l’effet natif des perspectives. Pour comprendre cela, il faut rappeler que plus un angle de vision est large, plus les lignes de perspectives semblent éloignées. Et qu’a contrario, plus un angle de vision est resserré, plus les lignes de perspectives paraissent proches. Les images de gratte-ciels ou de montagnes « empilées » les un(e)s sur les autres sont ainsi réalisées avec des téléobjectifs. Et les images avec des lignes d’horizon lointaines, elles, avec des grands-angles.

Il faut cependant relativiser cette « perte » dans le cas des smartphones. Les petits capteurs limitent les effets de perspectives « puissantes ». Cette perte est plus marquée à mesure que les capteurs grossissent – le recadrage 50 mm de l’optique 28 mm du Leica Q2 n’a certainement pas le punch d’un vrai 50 mm ! Nous sommes ici ravis qu’Apple récupère cette bonne idée des terminaux Android.

24 mm : seulement 2 mm en plus, mais un vrai bénéfice !

Après être resté des années « bloquée » à 26 mm, Apple s’aligne enfin sur la concurrence en matière de couverture angulaire de son module caméra principal et propose un 24 mm (en équivalent 24×36). Comme à son habitude, Apple ne cherche pas à être mieux disant, mais tient à maîtriser l’outil. Et la maîtrise est là : les déformations sont parfaitement corrigées, le rendu de l’image est très homogène et très précis. Contrairement à certaines marques assez inconstantes en matière de qualité optique.

Quel est le bénéfice de « seulement » deux millimètres ? Plus que les chiffres ne le laissent penser. Car il faut savoir que dans les valeurs grand-angle et très grand-angle, chaque millimètre a énormément plus d’impact sur la couverture angulaire que dans le domaine du téléobjectif. En clair, dès qu’on est en dessous de 28 mm, c’est très perceptible. Passé 50 mm l’impact de l’effet de chaque « millimètre » est bien moindre. Il est ainsi bien plus facile de faire la différence entre un 24 et un 26 mm qu’entre un 85 et un 90 mm par exemple !

Ici, le petit supplément (bien maîtrisé une fois encore) d’angle de vue peut s’avérer précieux pour les paysages et les photos dans des intérieurs très exigües. Apple aurait pu être plus novateur évidemment, mais on sent toujours le conservatisme (la frilosité ?) du mastodonte à sortir du… cadre dans ce domaine, où le monde d’Android est bien plus dynamique. Mais ne boudons pas le plaisir des amateurs d’iPhone.

Nous avons cependant quelque chose à redire de cette optique : outre un manque de piqué (nous y reviendrons), Apple n’est pas à la hauteur en matière de traitements de surface. Et son module caméra principal s’avère ainsi sensible aux « flares ».

Module principal : optique mal protégée contre les lumières parasites

Une optique est un dispositif constitué de plusieurs lentilles qui collectent, sur une couverture angulaire donnée, la lumière. Ou plutôt les lumières : si le soleil est la seule source que vous trouverez dans le bush australien, les zones urbaines ont souvent plusieurs sources différentes : éclairage public, fenêtres des maisons, phares de voitures, etc. Avec des températures de couleurs, des intensités mais aussi des trajectoires de rayons différentes.

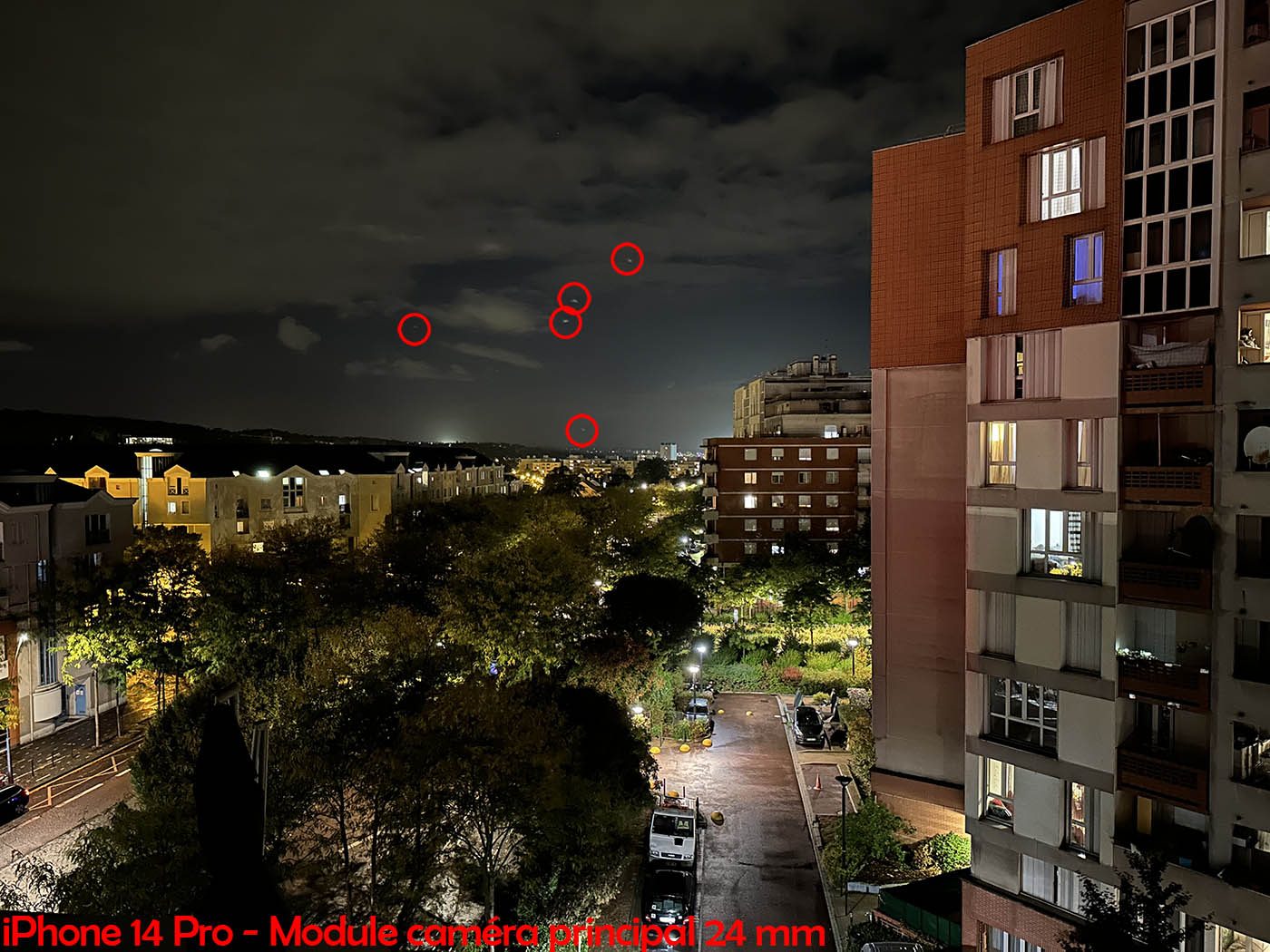

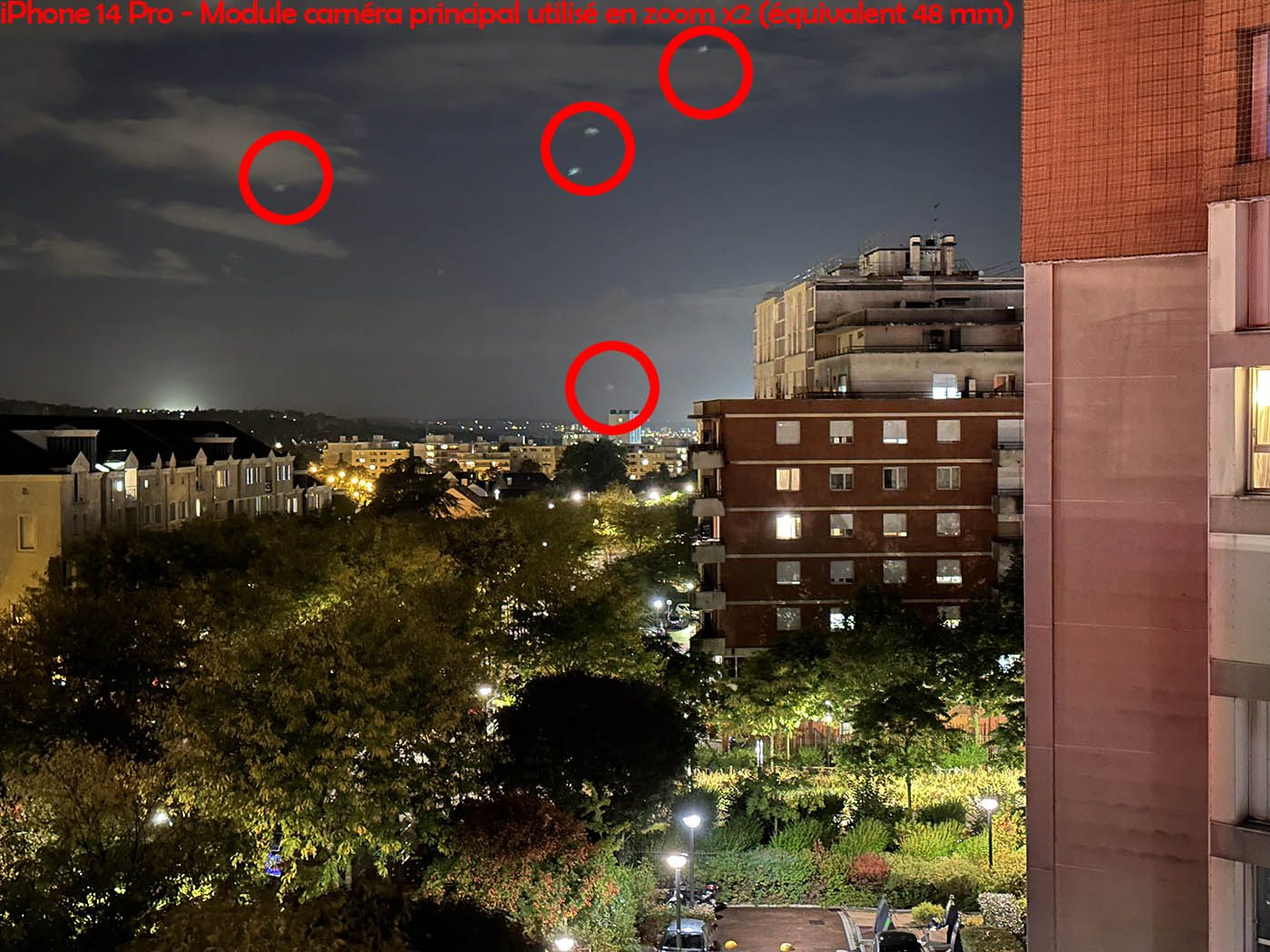

Or, ces sources peuvent créer des artéfacts lumineux comme les halos que vous voyez ci-dessous entourés en rouge. Ces halos que l’on appelle « flares » (proncer “flère”) proviennent des lampadaires qui éclairent cette avenue.

Si vous comparez côte côté à côte les clichés de l’iPhone 14 Pro et de son aïeul, l’iPhone Pro, vous constatez qu’Apple est (comme toujours) constant : les deux blocs optiques des modules caméra principaux de ces terminaux montrent la même sensibilité à cet effet.

A titre de comparaison, le module caméra principal du X80 Pro de Vivo ne montre aucune faiblesse du genre. Si la formule optique – c’est-à-dire le nombre, la forme, la qualité, etc. des lentilles – a une influence sur la réduction de cet effet, une autre arme a un effet significatif : le traitement de surface de l’optique. En signant avec l’Allemand Zeiss, Vivo profite du savoir-faire du traitement T* (prononcer « Ti Star » en anglais, ou « Té Stern » en allemand).

A lire aussi : Zeiss, Leica, Hasselblad… Pourquoi l’expertise photo européenne fait rêver les fabricants chinois de smartphones (juin 2022)

Loin d’être une simple formule chimique, le traitement T* est une suite de qualifications chimiques, matérielles et logicielles propres à chaque optique pour réduire, voire totalement annuler les effets de flare. Et si cette mention n’est pas la marque d’une optique parfaite, c’est cependant la garantie que ces effets parasites sont sous contrôle. Et on voit que ce n’est pas le cas chez Apple.

Ultra grand-angle qui s’améliore bien (mais intérêt de la macro limité)

Apple a enfin utilisé un capteur plus grand pour son module caméra ultra grand-angle : au trop petit 1/3,5’’ succède un 1/2,55’’. Une taille qui fait écho à un précédent modèle : il s’agit du même genre de capteur qui équipait le module caméra principal de l’iPhone XS (sept. 2018) ! La qualité d’image est fort logiquement en hausse, avec effectivement moins de bruit numérique, une excellente correction des déformations optiques et un bon niveau de détail. On n’est pas au niveau de ce qu’ont pu produire des terminaux de Huawei avec leur capteurs ultra grand-angle « géants » (ahhhh, la merveille du Mate 40 Pro), mais c’est un bon progrès.

Du point de vue des micro-détails, Apple offre ici encore plus de cohérence que par le passé : les couleurs étaient déjà raccord, désormais la granulosité des pixels que l’on observe à 100% est marquée des mêmes qualités… et des mêmes défauts (lissage toujours trop fort).

Bien corrigée, l’optique est propre, mais manque (comme d’habitude) de punch. Sans avoir les détails des formules optiques non plus que des fournisseurs, nous sommes prêts à parier qu’Apple privilégie la régularité et l’homogénéité au caractère et au piqué de l’image. Heureusement que le traitement logiciel a posteriori permet de récupérer de la netteté.

Côté macro, nous campons sur nos positions : l’intérêt de l’avoir sur l’ultra grand-angle est très (très) limité. Outre le rendu des perspectives assez peu intéressant côté composition, on a souvent du mal à jouer avec la lumière en étant si proche du sujet. C’est d’ailleurs un point de vue partagé par l’industrie de la photo : aucune optique de « vrai » appareil photo n’est estampillée « macro » en dessous de 35 mm (et dans le cas des 35 mm, il convient, comme pour l’iPhone, de parler de proxi-photographie). Oui, le potentiel de mise au point de proximité est sympa à avoir, mais on préfèrerait pouvoir faire le point avec le téléobjectif, qui est plus resserré, et isole bien mieux les sujets.

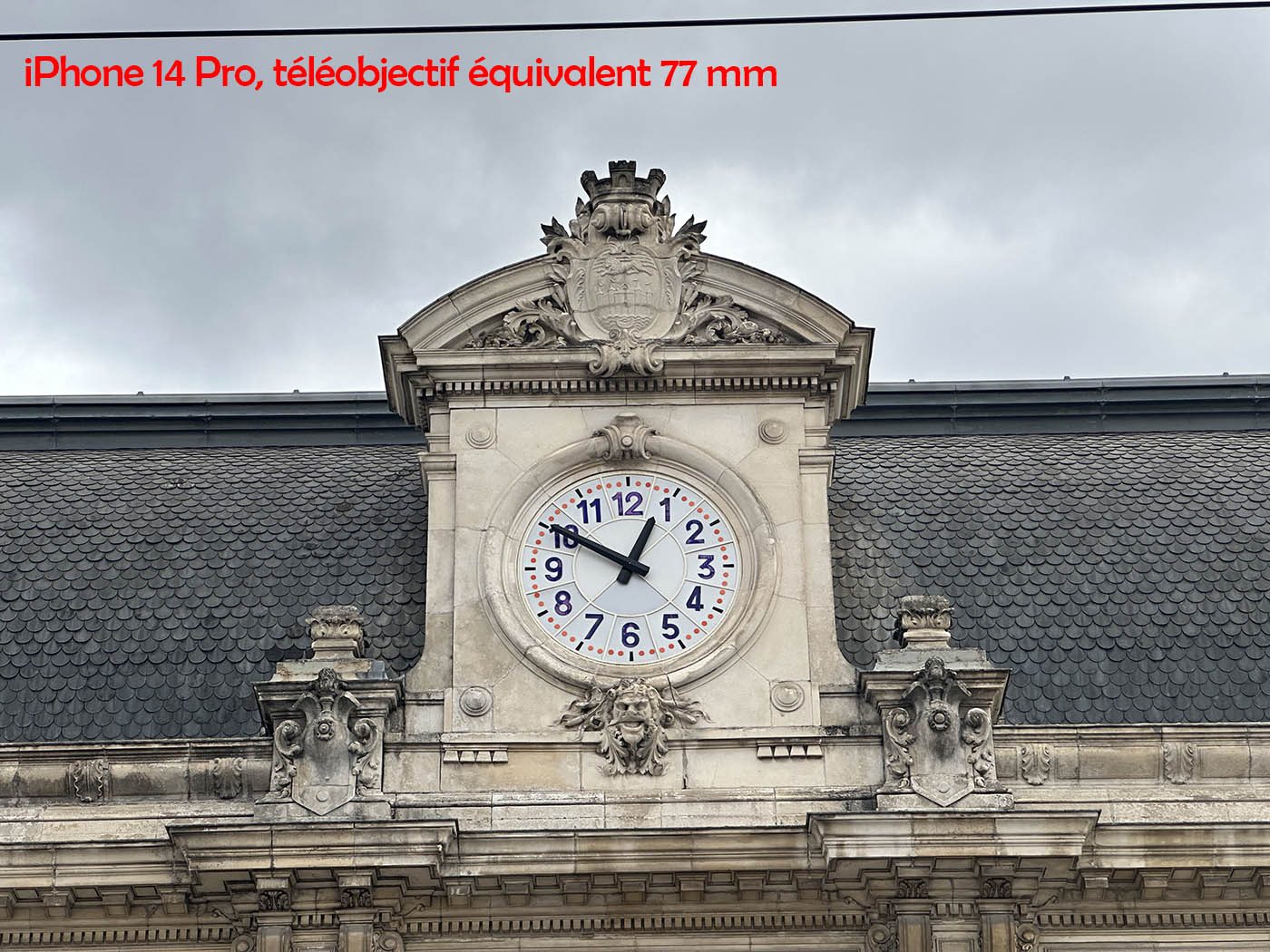

Téléobjectif : pas d’amélioration de la qualité et manque de puissance

Point de changement pour l’équivalent 77 mm f/2.8 équipé d’un capteur 12 Mpix de petite taille (1/3.5’’) : c’est le même que celui des iPhone 13 Pro. En étant très (trop !) modeste sur la puissance de zoom, Apple ne prend cependant pas de risque quant à la qualité d’image. Stabiliser et débruiter une image avec une couverture angulaire si large (pour un téléobjectif) est plus facile que pour un équivalent 135, voire 240 mm (comme chez Samsung et Huawei) !

De fait, les clichés en plein jour sont bons. Une fois encore, les téléobjectifs notamment de Huawei sont meilleurs – on pense à l’excellent 125 mm du Mate 40 Pro – mais celui d’Apple reste l’un des meilleurs dans la catégorie des « petits » téléobjectifs (inférieurs à 100 mm). Et surtout, le traitement d’image et la nature des couleurs sont raccord avec les autres modules caméra. Ce qui ne veut pas dire qu’on soit totalement satisfaits.

D’une part on peut regretter le manque de progrès sur ce module– au prix où sont les iPhone, on peut objectivement soulever TOUT point qui ne présente pas de progrès générationnel ! Mais plus que la qualité d’image – plutôt bonne – c’est du côté de la puissance que nous avons des griefs envers Apple.

Comparez les différences de puissance de zoom entre le « vieux » Samsung Galaxy S21 Ultra 5G, avec son équivalent 270 mm et le petit 77 mm de l’iPhone. Alors que Samsung, Huawei et d’autres offrent des téléobjectifs qui transforment votre smartphone en appareil photo de voyage, Apple pèche une fois encore par son conservatisme.

Interface logicielle solide, mais toujours incomplète

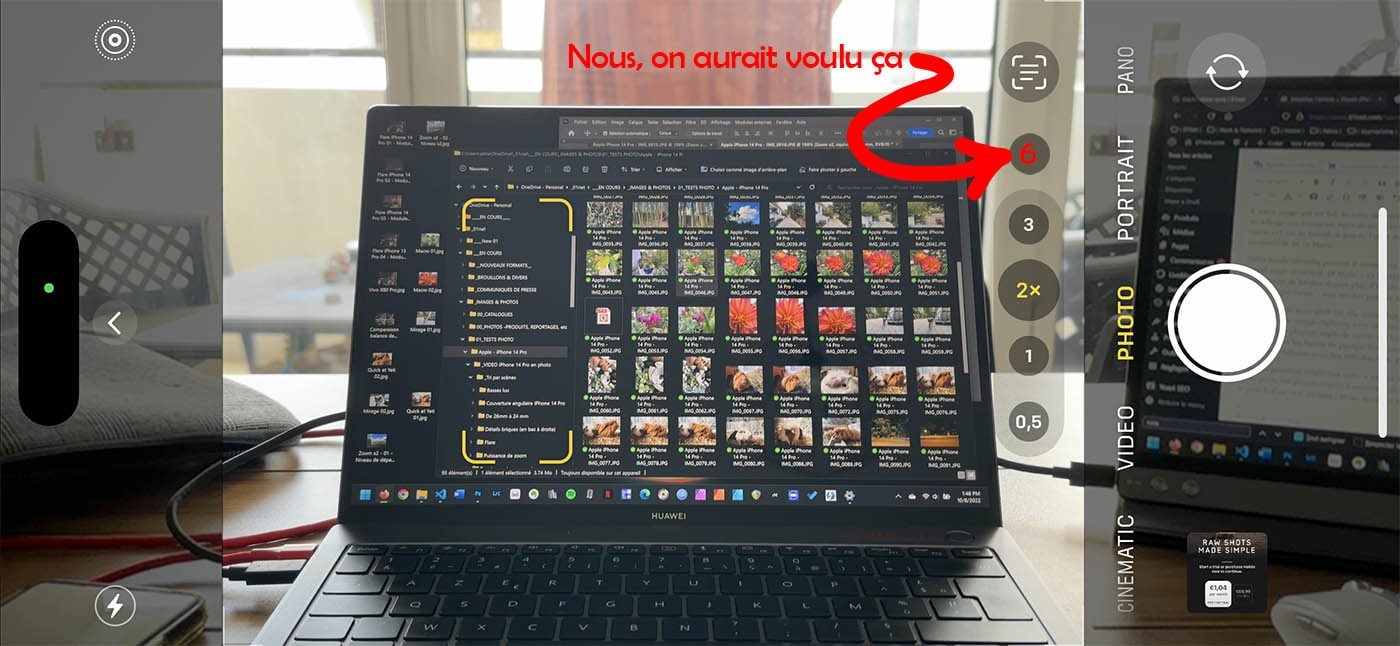

Il est parfois important de faire une pause sur l’interface logicielle. À l’exhaustivité des terminaux Android, s’est toujours opposé la simplicité chez iOS. Une simplicité de plus en plus battue en brèche par l’ajout régulier de fonctionnalités – modes (time-lapse, cinématique) changement de ratio d’image, correction d’exposition, etc.

Cette simplicité plaira à tous ceux qui utilisent leur iPhone comme un simple mémo numérique – et aux éditeurs de logiciels tiers à qui Apple laisse un peu de business ! Mais nous regrettons cependant l’accès au format RAW (Apple ProRAW) : impossible d’activer ce mode dans l’application photo. Il faut obligatoirement aller dans « Paramètres / Caméra / Formats ». Un mouvement de doigt pour sortir de l’application, un clic sur Paramètres, un long défilement et l’identification de l’icône, puis deux clics et l’activation de la fonction : c’est long, trop long. Ce d’autant plus qu’avec un traitement logiciel initial de qualité, un photographe amateur va surtout vouloir activer le RAW dans certains cas – lumière difficiles, contre-jour mal interprété, etc. Apple gagnerait (à nouveau…) à s’aligner sur les concurrents et permettre un accès à ce format directement depuis l’application).

Il semblerait toutefois qu’Apple ait conscience de ce problème. Cette aberration ergonomique devrait être corrigée très prochainement, car la bêta d’iOS 16.1 permet d’ores et déjà de facilement activer/désactiver le mode ProRAW, une fois qu’il l’a été une première fois dans les réglages centralisés de l’application Appareil Photo. Espérons que cet ajustement sera toujours présent dans la version définitive.

Autre manque logiciel : celui d’un zoom numérique validé par Apple au-delà du x3. Nous aurions désiré que l’entreprise s’inspire de ce que propose Google sur ses Pixel – et notamment son tout nouveau Pixel 7 Pro – c’est-à-dire un niveau logiciel supplémentaire de zoom. Un bouton de focale “x6” opto-numérique, dont la qualité aurait été optimisée par les ingénieurs de l’entreprise et aurait en partie palier la limite de la puissance de zoom du téléobjectif natif.

Ne vous méprenez pas : la partition photo de l’iPhone 14 Pro est bonne, très bonne. Que ce soit en rendu des couleurs, niveau de détails (en progrès), en autofocus (toujours bon) ou en simplicité d’usage. Mais avec des tarif si élevés, un telle position de leader mondial sur les smartphones haut de gamme, de tels budgets potentiels, etc. Le côté conservateur et suiveur d’Apple agace forcément. Nous attendions des capteurs encore plus grands, des zooms plus performants, un autofocus plus percutant et surtout plus intelligent (le NPU le permet !). Et nous n’avons au final qu’un iPhone 13 Pro certes amélioré, mais pas transcendé.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Bonjour, ce passage est tout à fait faux : “Si cette focale nous plaît (et elle nous plaît !), pourquoi parler de vrai/faux 50 mm alors ? Simplement parce que recadrer un semblant de 50 mm dans une image capturée avec une focale équivalente à un 24 mm ne restitue pas l’effet natif des perspectives.” C’est le strict équivalent d’un point de vue perspective… Une image d’un 300 mm est contenue dans celle d’un 50 mm, d’un point de vue perspective…