Sur le papier, Apple Intelligence vend du rêve. La suite d’outils développée par Apple promet en effet de révolutionner l’utilisation de l’iPhone avec des fonctions comme des outils d’écriture, des correcteurs d’image, des résumés de notifications ou encore l’intégration de ChatGPT. Le géant de Cupertino a certes mis du temps avant de lancer son IA, et davantage encore avant de la faire miroiter à l’Europe, mais voilà cette fois c’est la bonne : Apple Intelligence devrait arriver sur nos iPhone et iPad en avril.

C’est pourquoi nous n’avons pas hésité longtemps avant d’installer la mise à jour iOS 18.4 sur notre iPhone 16 Pro Max. Après quelques jours de test, on a vite déchanté. Voici notre avis sur Apple Intelligence.

L’aide à l’écriture : quand l’IA d’Apple manque de finesse

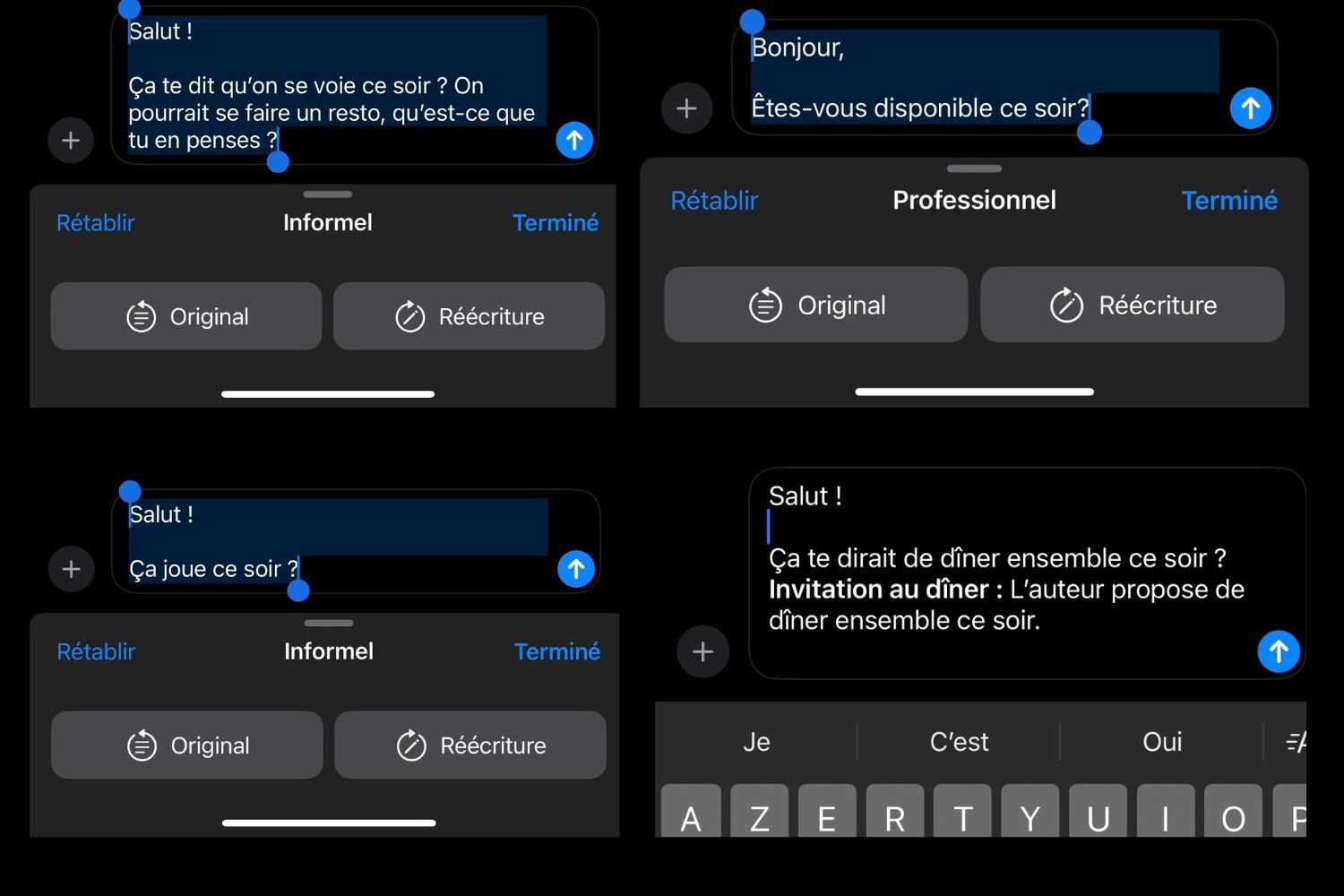

Une fois que nous avons installé la mise à jour, qui est désormais déployée en Europe, nous nous sommes empressés de tester les outils d’aide à l’écriture d’Apple Intelligence. Ceux-ci permettent de retravailler un texte avec l’aide de l’IA générative. La fonction s’affiche automatiquement par le biais d’un menu contextuel dès que vous écrivez quelque chose, que ce soit sur messages, mails ou une autre application.

En théorie, l’outil permet de s’appuyer sur l’IA pour concevoir des messages et des textes calibrés en fonction des besoins. En pratique, on a souvent eu l’impression que l’IA mise à disposition par Apple manque de finesse et de compréhension de la langue française. On est, à notre avis, loin des résultats obtenus avec ChatGPT, Grok ou encore Claude. Quand nous “convertissons” le message adressé à un proche, nous sommes rarement impressionnés par le résultat. En fait, on arriverait bien souvent à un meilleur résultat juste en réfléchissant un peu. Les options proposées par Apple, comme des reformulations concises, professionnelles ou informelles, restent amusantes, mais elles ne sont pas vraiment utiles. En général, on demande plutôt à l’IA d’écrire un message à notre place, plutôt que de le réécrire.

Pour des résultats plus convaincants, il faut impérativement convoquer ChatGPT, désormais intégré à l’échelle de l’OS, directement dans les outils d’écriture. En matière de rédaction, le modèle d’IA d’Apple, qui tourne en local, n’est pas à la hauteur. En passant par ChatGPT, on obtient évidemment des contenus plus précis et plus pertinents.

Malgré tout, nous n’avons pas pris l’habitude de nous servir d’Apple Intelligence dans nos activités quotidiennes, que ce soit pour écrire des SMS ou des mails. On se sert pourtant régulièrement de l’IA pour revoir du texte ou obtenir des résumés en travaillant sur notre iPhone. Le manque de précision de l’IA d’Apple nous a empêchés d’intégrer celle-ci à notre routine. Après deux semaines d’utilisation, on ne se sert des outils d’écriture qu’à l’occasion.

Des résumés imparfaits

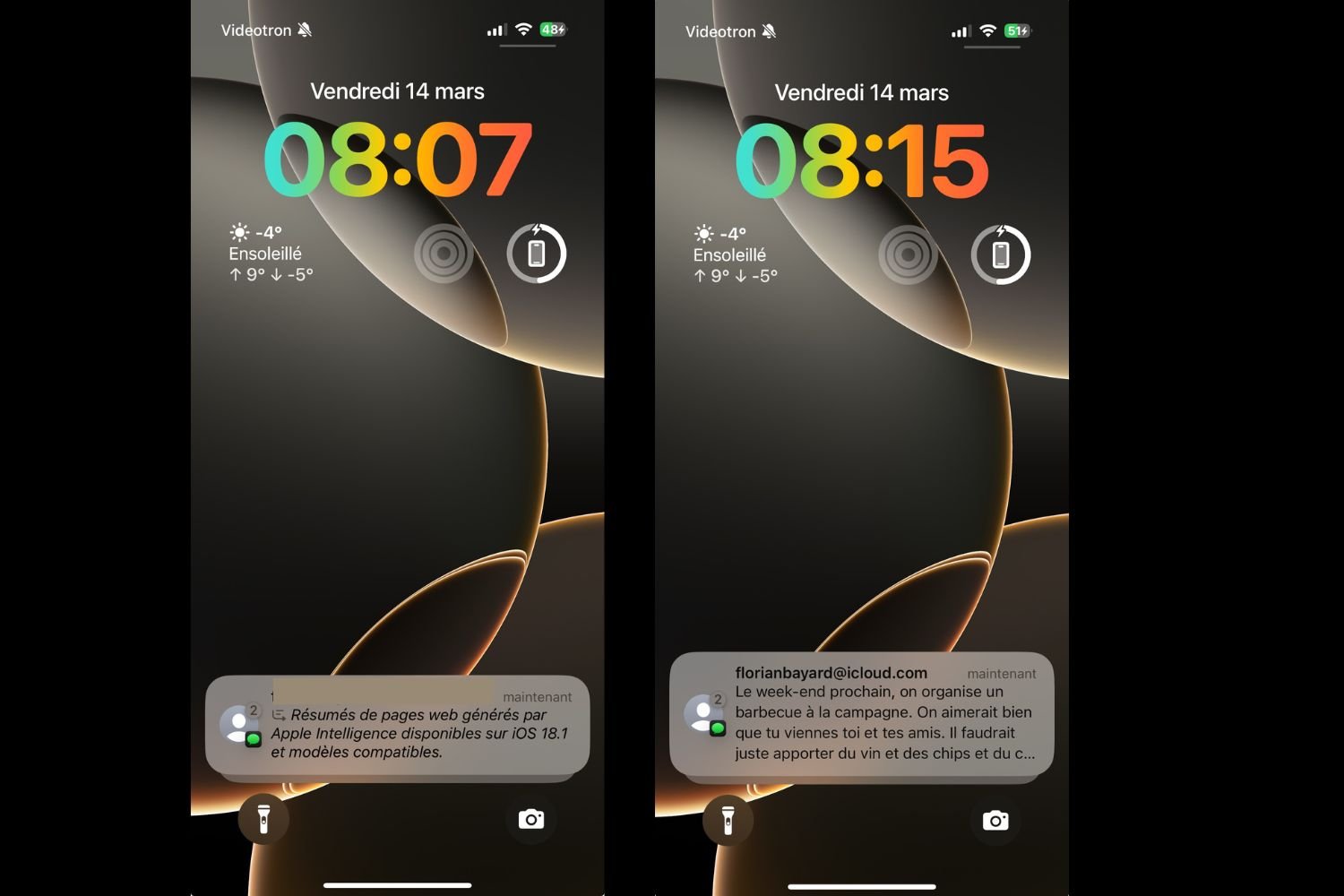

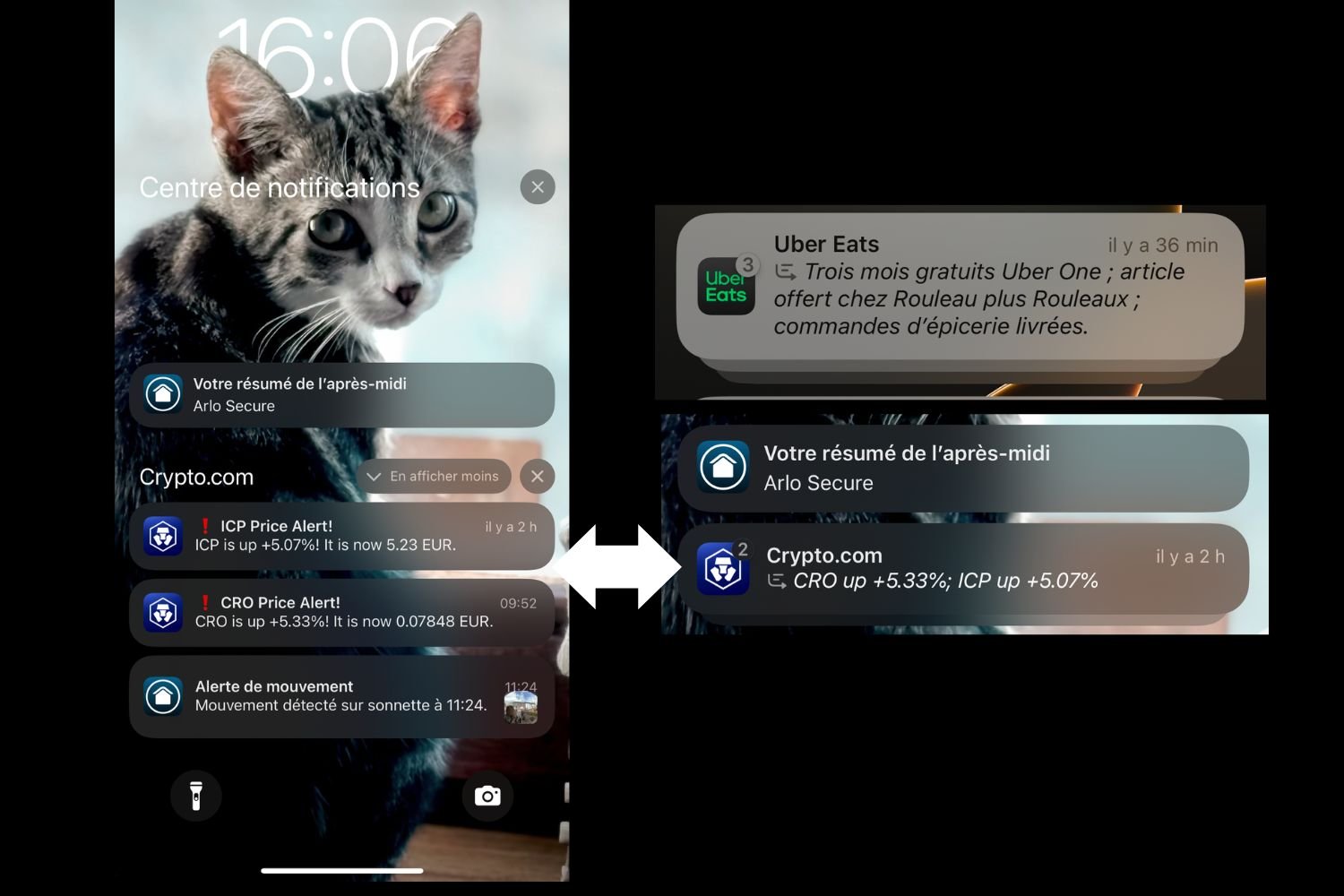

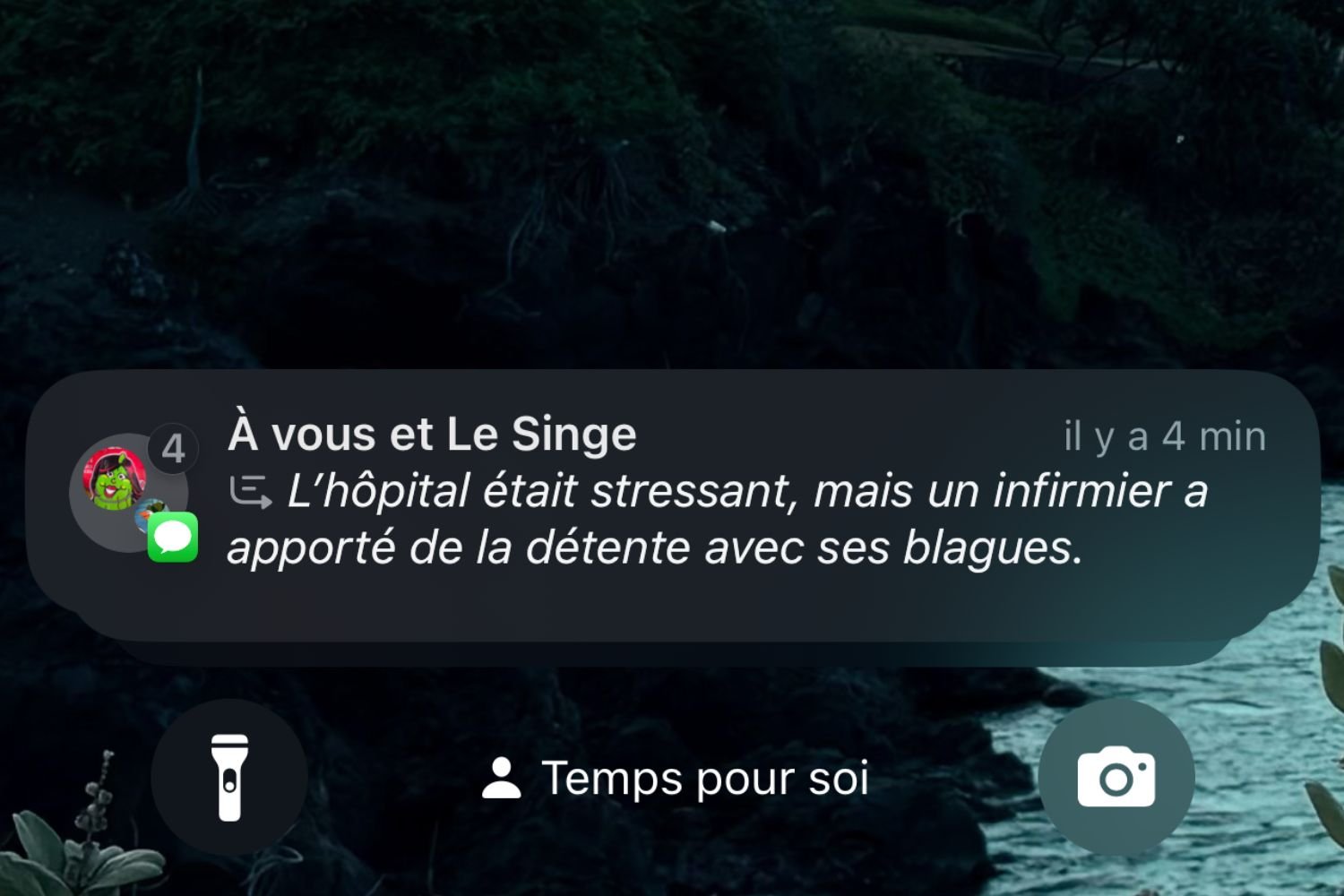

Le résumé des notifications nous a particulièrement déçus. La fonctionnalité doit proposer automatiquement des résumés des notifications qui s’affichent sur votre iPhone. C’est surtout taillé pour résumer de longues notifications d’actualités en un court texte qui vous fera gagner du temps. Malheureusement, Apple a été obligé de suspendre la fonctionnalité pour les actualités suite aux nombreux ratés rapportés par les utilisateurs. Apple Intelligence s’est en effet mis à propager de fausses informations en résumant de travers des contenus. Certaines apps sont désormais exclues du programme.

Par ailleurs, le modèle de langage choisi par Apple, qui tourne en local directement sur l’iPhone, s’est souvent montré incapable de proposer un résumé pertinent. Fréquemment, il faut cliquer sur la notification pour bien comprendre de quoi il s’agit. Le sens du résumé est parfois très éloigné de celui du message original.

Le plus souvent, la fonction est tout simplement inactive. Nous avons continué à recevoir nos notifications de la même manière qu’auparavant. En fait, Apple Intelligence résume un SMS sur deux, de manière totalement aléatoire. Parfois, l’IA résume les notifications envoyées par une plateforme de crypto, concernant le cours des monnaies numériques, en un seul message. Dans ces cas-là, l’option fonctionne, mais on peine à y trouver un véritable avantage. Le résumé manque trop souvent de lisibilité.Surtout, Apple Intelligence n’agit pas assez régulièrement pour avoir un véritable impact sur la manière d’interagir avec nos notifications. Sur ce point encore, Apple est resté un peu trop timoré.

Même son de cloche du côté du nouveau mode de concentration qui s’appuie sur Apple Intelligence. Si celui-ci se montre assez efficace en bloquant les notifications indésirables, il fait un peu double emploi avec les modes de concentration déjà configurés par nos soins. Si vous disposez déjà de plusieurs modes calibrés en fonction de vos activités, vous ne sentirez pas trop la différence en activant Apple Intelligence.

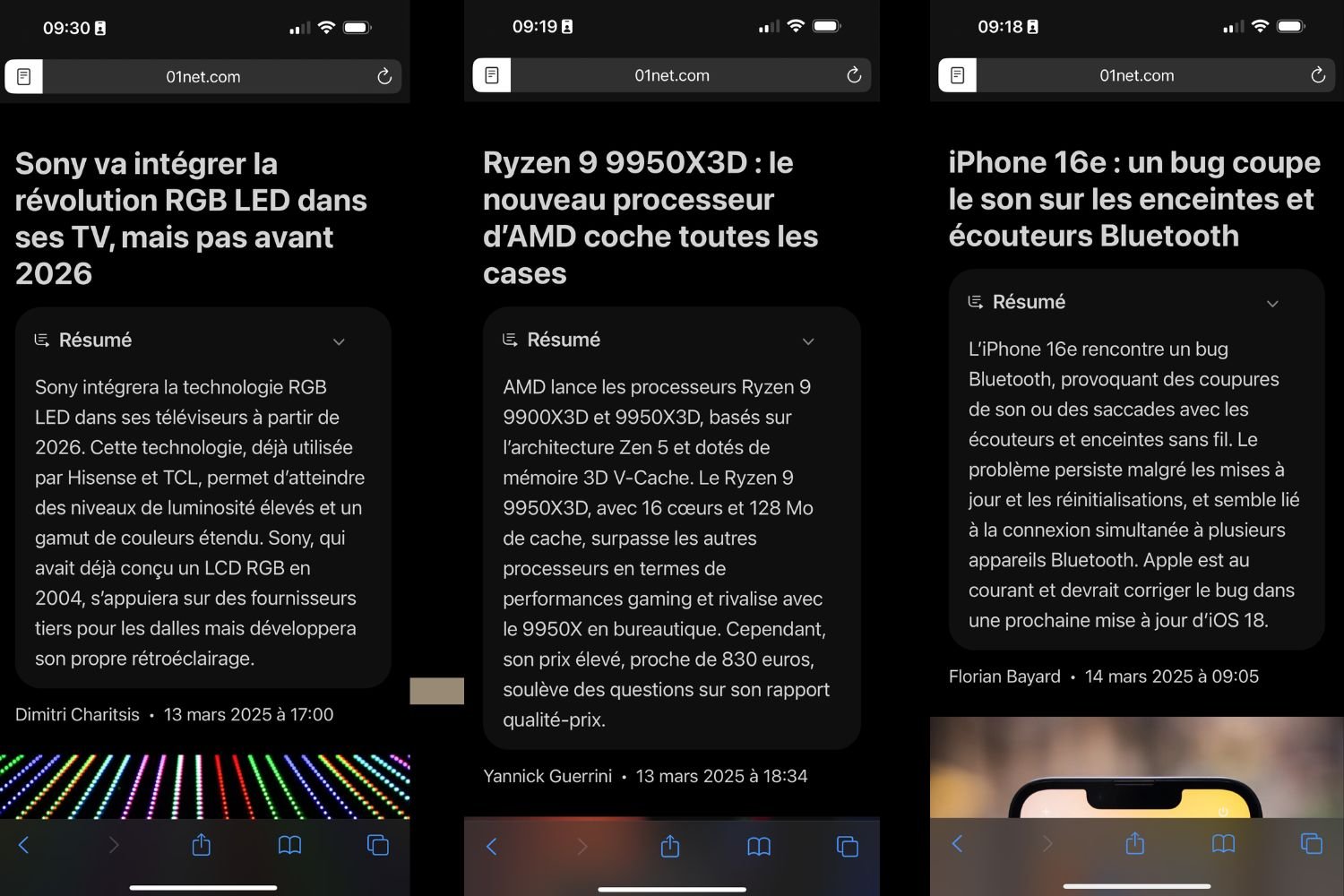

On a aussi testé les résumés d’articles sur Safari. Nous avons essayé la fonction avec une kyrielle d’articles trouvés en ligne. Dans la plupart des cas, l’IA d’Apple fonctionne comme prévu et permet d’obtenir un résumé succinct d’un long contenu. Sur les articles les plus longs, l’IA passe un peu à côté du sujet, et se focalise parfois sur des éléments anecdotiques.

Visual Intelligence, une bonne surprise

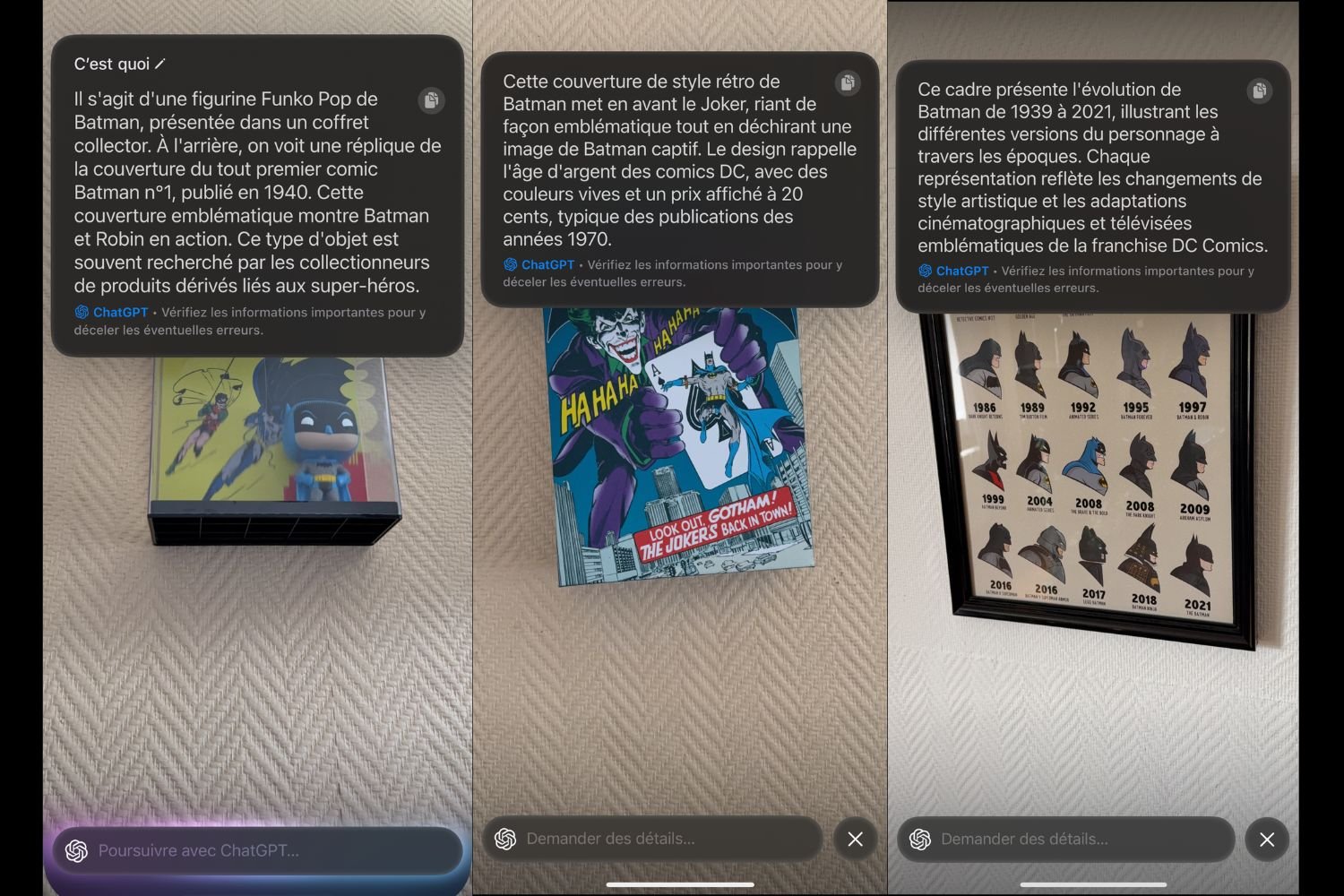

Visual Intelligence est une des bonnes surprises d’Apple Intelligence. Par le biais de l’appareil photo, il est possible de demander à l’IA de vous fournir des informations sur ce qui se trouve devant vous. Vous pouvez activer ce mode en appuyant longuement sur le nouveau physique des iPhone 16.

La fonction s’appuie directement sur ChatGPT. Dès que vous arrivez dans l’interface d’Apple Intelligence, une fenêtre de conversation vous propose de converser avec ChatGPT. L’IA d’OpenAI va alors interpréter l’image et vous décrire ce qu’il se trouve devant vous. Sur ce point, ChatGPT est très efficace. Il fournit rapidement des explications brèves sur ce qu’il voit. ChatGPT s’est montré difficile à piéger, bien qu’il manque parfois un peu de précision. Par le passé, on s’est souvent servi de ChatGPT pour comprendre le fonctionnement d’une machine inconnue, comme une chaudière ou un jacuzzi. Intégré à l’appareil photo de l’iPhone, celui-ci devient un véritable assistant de la vie de tous les jours, facile à convoquer d’un seul geste.

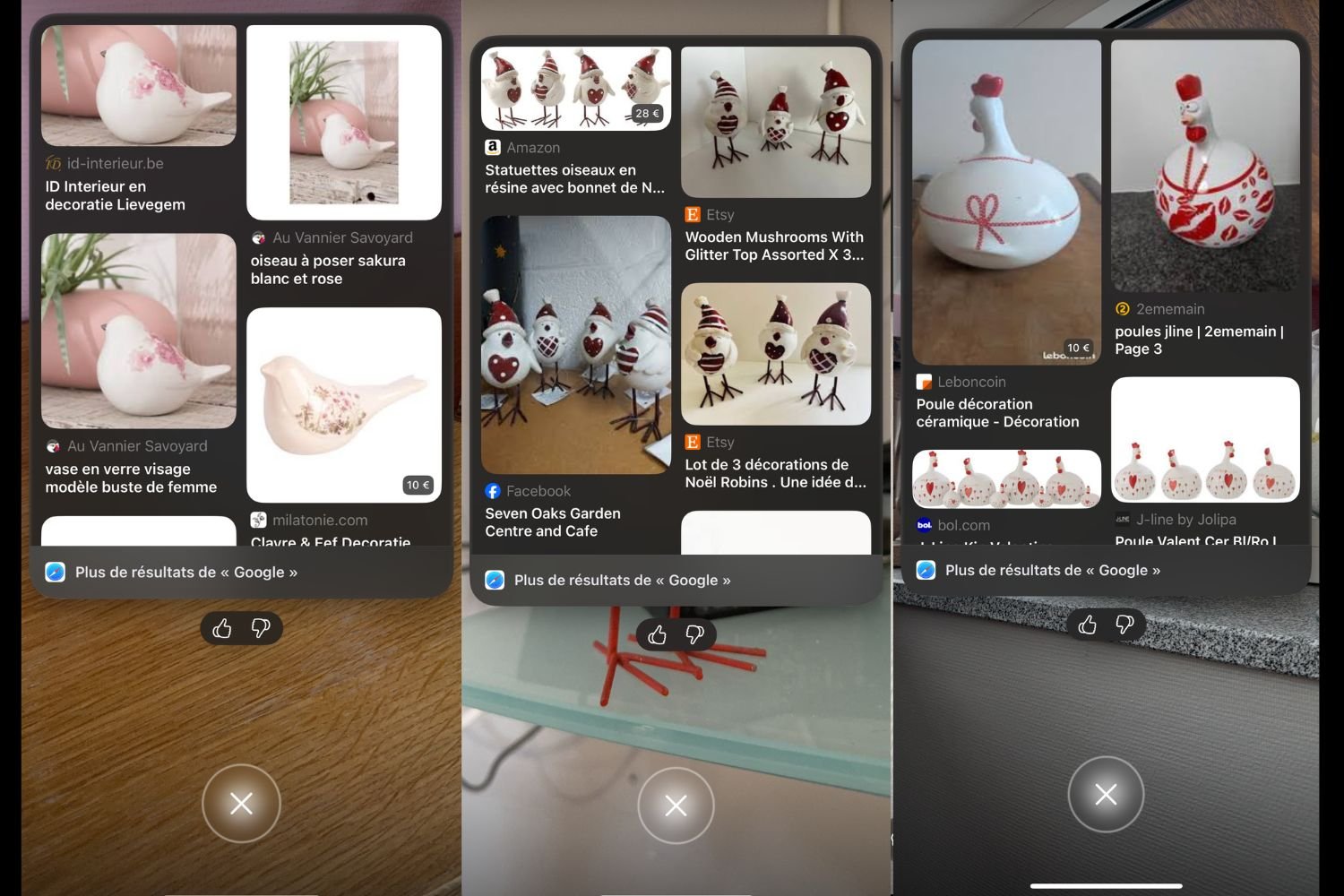

Par ailleurs, Visual Intelligence dispose d’un outil similaire à Google Lens. Cette fonction permet de rechercher en ligne des objets analogues à celui qui se trouve devant vous. C’est loin d’être révolutionnaire. Néanmoins, on apprécie que cette fonction fasse son entrée sur iOS.

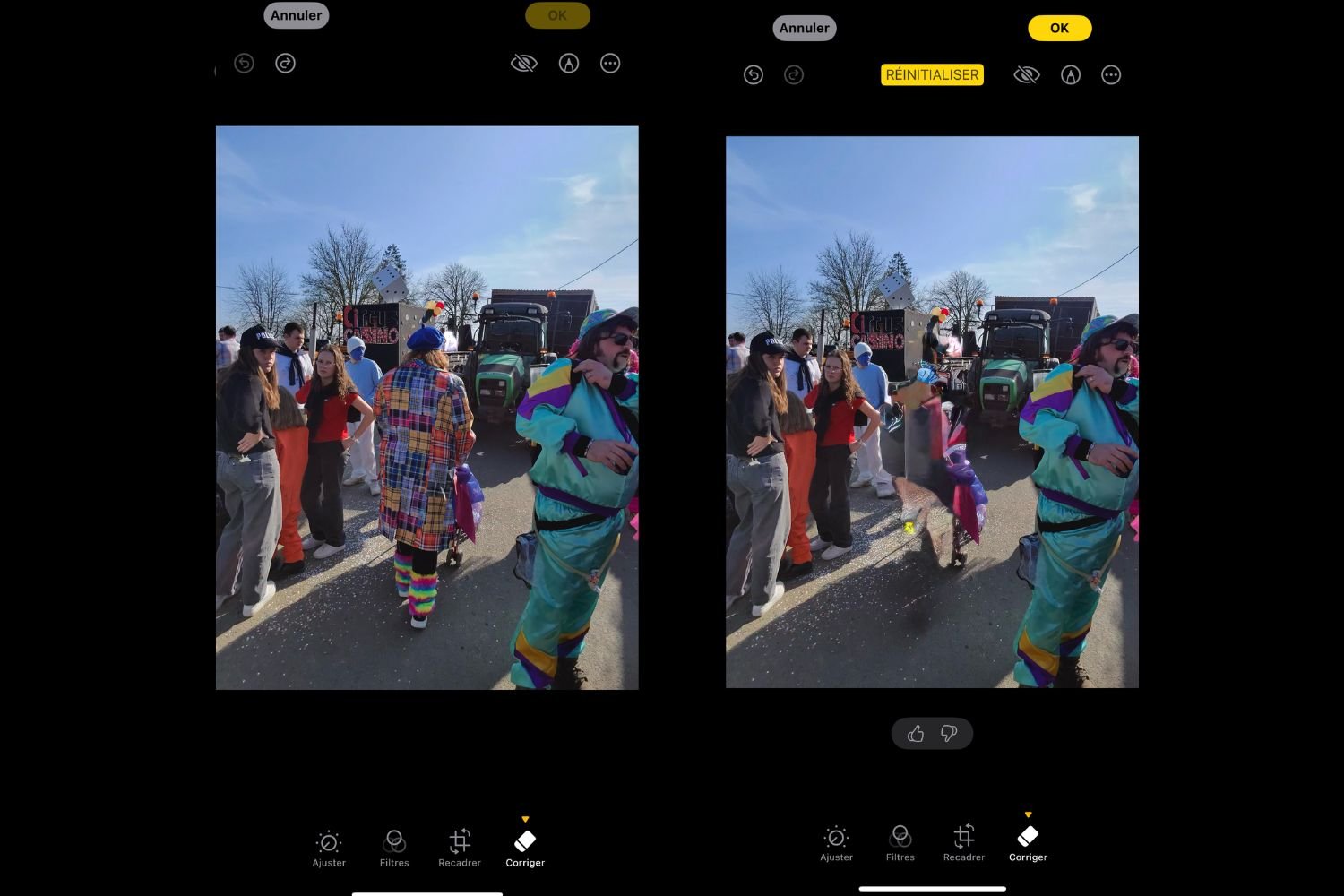

La gomme, Genmoji et PlayGround

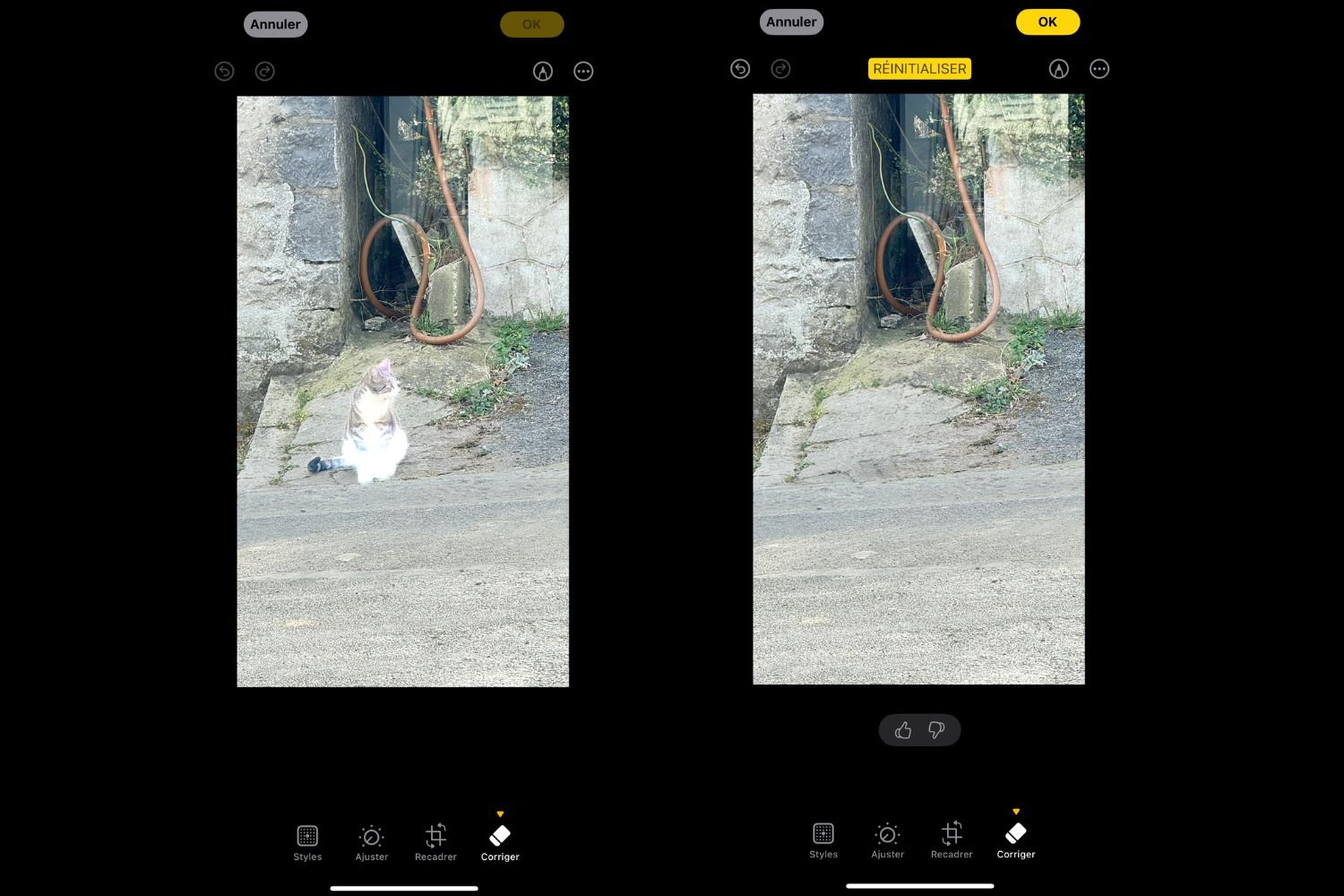

Citons aussi la fonction Corriger ajoutée à l’application Photos. Celle-ci permet de supprimer un élément d’une image d’un seul clic. Les résultats sont plutôt aléatoires. En règle générale, le passage de la gomme laisse des traces visibles sur l’image. N’espérez pas vous débarrasser d’un tracteur passant à l’arrière qui gâche votre photo de vacances. La gomme ne marche vraiment bien qu’avec des petits éléments.

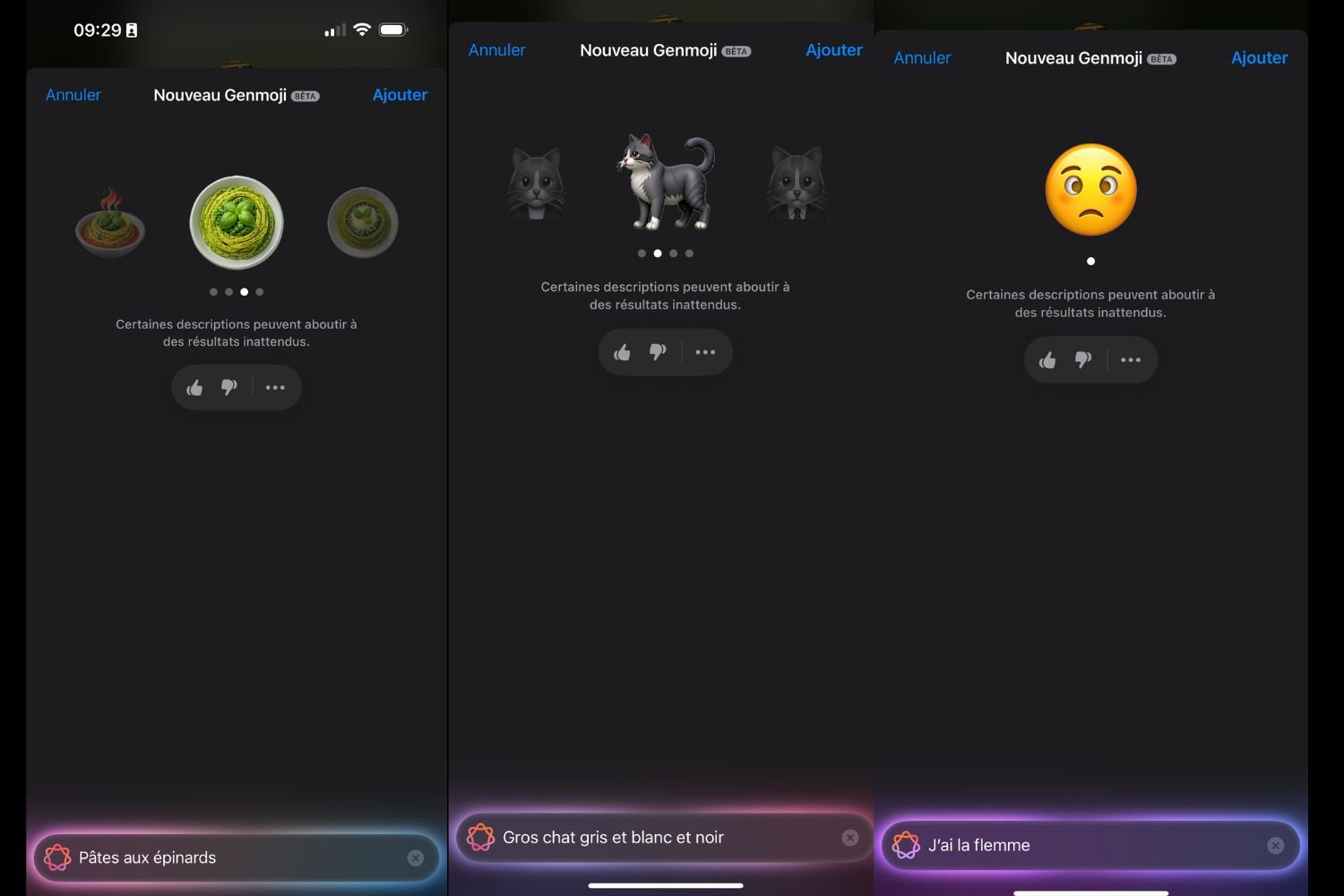

On s’est aussi un peu amusé avec les fonctions Genmoji et Playground. En bref, il s’agit d’un générateur d’emojis et un générateur d’images. Comme on s’y attendait, ce sont surtout des gadgets, dans la droite lignée des animojis annoncés avec l’iPhone X et la reconnaissance faciale Face ID.

Les outils fonctionnent plutôt bien, et les images générées sont généralement réussies, bien que simplistes. Ils sont surtout destinés au jeu plus qu’à un usage professionnel. Apple tire son épingle du jeu grâce à l’interface de Playground, ludique et facile à prendre en main, mais pèche par la puissance de l’IA qui génère des images. Tout le processus se déroule en local sur l’iPhone, ce qui bride vraisemblablement les possibilités offertes tout en faisant chauffer l’appareil, et fondre son autonomie. On aurait peut-être aimé qu’Apple délègue la génération d’images à une IA tierce, comme ChatGPT.

Finalement, on trouve que Genmoji, dont les promesses sont moins ambitieuses, est plus réussi que Playground. Intégré à iMessage, Genmoji nous a permis d’enrichir certaines de nos conversations avec nos proches. C’est assez amusant, mais, encore une fois, on ne se sert pas régulièrement de l’option passée la phase de découverte.

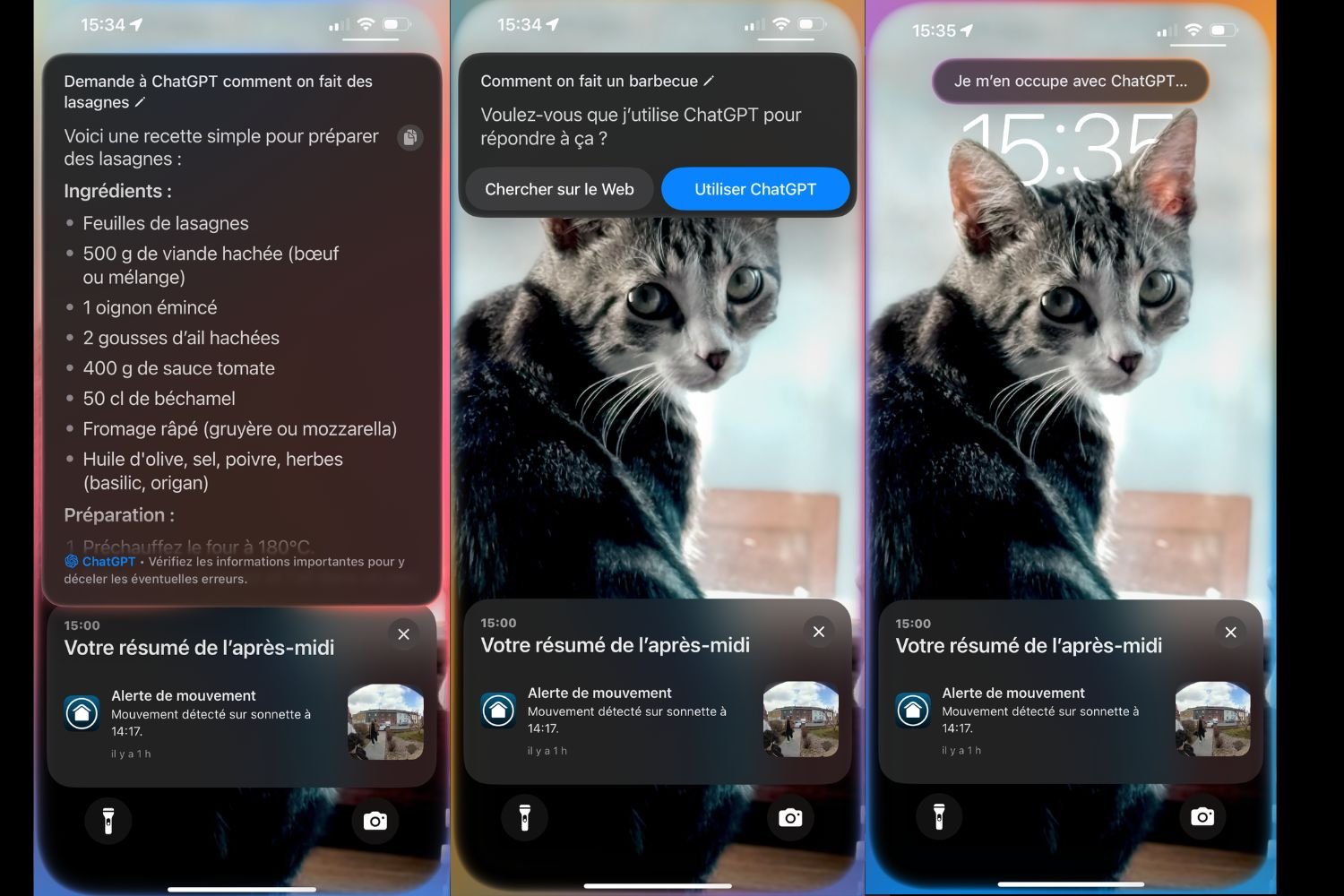

ChatGPT, l’atout phare d’Apple Intelligence

Intégré à iOS, ChatGPT doit venir assister Siri lorsque celui-ci est incapable de répondre aux questions des utilisateurs. Dans les faits, Siri n’a pas encore le réflexe de demander de l’aide à ChatGPT dès que c’est nécessaire. L’assistant vocal se contente bien souvent de répondre qu’il n’est pas en mesure de venir en aide à l’utilisateur. Pour convoquer le chatbot d’OpenAI, il faut souvent demander à Siri de faire appel à l’IA générative en lui demandant clairement de poser la question à ChatGPT. C’est particulièrement poussif. La situation s’est vite améliorée. Depuis quelques semaines, Siri a plus souvent tendance à convoquer ChatGPT au besoin, mais son intégration reste perfectible. On en arrive à une situation où un assistant vocal nous répond avec un pavé de texte…

C’est loin d’être une révolution étant donné que ChatGPT est déjà disponible sur l’iPhone par le biais de l’application d’OpenAI depuis l’an dernier. On avait d’ailleurs l’habitude de faire appel à ChatGPT par le biais du bouton Action de notre iPhone, grâce à la très pratique application Raccourcis, ou sur l’écran d’accueil par le biais d’un widget.

Malgré nos efforts, le réflexe de demander des infos à ChatGPT par le biais de Siri ne s’est pas imposé dans notre quotidien. Par contre, la présence de ChatGPT prend tout son sens au sein des outils d’écriture ou de Visual Intelligence. On peut très facilement obtenir des contenus qualitatifs pour enrichir nos SMS ou nos mails sans quitter l’application. En fait, ChatGPT reste le plus gros point fort d’Apple Intelligence. C’est le principal atout de l’iPhone sur le terrain de l’IA… C’est révélateur du retard accumulé par Apple sur ce terrain.

Avec ChatGPT, on aurait aimé qu’Apple aille encore plus loin. On aurait voulu que l’IA d’OpenAI soit vraiment intégrée à toutes les strates de l’OS, de manière à pouvoir le convoquer simplement quand on sert de n’importe quelle application, ou pour lui confier des tâches plus complexes. Apple ferait bien de reprendre la logique de Visual Intelligence, au sein duquel ChatGPT intervient de manière fluide et automatique, et de l’étendre à tout le système d’exploitation.

Une fonction clé encore manquante

Gardons à l’esprit qu’il ne s’agit encore que d’une première version de l’outil. On rappellera que certaines des fonctionnalités phares ne sont pas encore disponibles, des mois après l’annonce. C’est surtout le cas du Siri 2.0, qui se laisse encore désirer. De l’aveu d’Apple, la mise au point de l’assistant vocal prend plus de temps que prévu. Le nouveau Siri ne sera pas prêt avant l’année prochaine. Apple Intelligence restera donc amputé de sa principale fonctionnalité pendant un bon bout de temps.

Avec le temps, Apple Intelligence pourrait bien évoluer, et prendre une place plus importante dans notre quotidien. En l’état, l’IA à la Apple n’est qu’un gadget. Le futur Siri pourrait bien changer la donne en unifiant le système d’exploitation avec les fonctionnalités d’IA, mais il n’est pas encore près de pointer le bout de son nez…

Un usage extrêmement faible

Apple n’est pas dupe. Comme le rapporte Mark Gurman, journaliste chez Bloomberg, le géant californien s’est rendu compte que les utilisateurs d’iPhone ne se servent pas massivement des fonctions d’Apple Intelligence. Selon les données internes de l’entreprise, l’utilisation d’Apple Intelligence est extrêmement faible. En dépit des efforts marketing d’Apple, l’IA n’est pas devenue un nouvel argument de vente susceptible de doper les ventes d’iPhone. Les utilisateurs ont tendance à bouder les fonctions d’IA de l’iPhone.

En dépit des promesses affichées par Apple, Apple Intelligence n’a pas eu de véritable impact sur la manière dont on se sert de notre iPhone. En fait, notre usage est resté anecdotique. Il se passe le plus souvent plusieurs jours avant qu’on se serve d’Apple Intelligence. Un collègue a d’ailleurs remarqué qu’Apple Intelligence avait été désactivé, sans s’en rendre compte. Cette anecdote illustre bien à quel point l’IA d’Apple manque d’impact.

Notre premier avis sur Apple Intelligence

L’échec actuel d’Apple Intelligence découle d’abord du calendrier de déploiement d’Apple, qui a pris beaucoup de retard. La société a choisi de déployer ses fonctionnalités d’IA au compte goutte. De facto, la version d’Apple Intelligence actuellement disponible est incomplète. C’est pourquoi on a souvent eu l’impression de tester une solution en cours de développement. Le choix d’Apple de passer en grande partie par des modèles d’IA qui tournent en local, au lieu de serveurs à distance, contribue également à réduire les possibilités offertes. Cette approche vise à protéger la vie privée des utilisateurs, mais elle bride les ambitions d’Apple Intelligence.

Par ailleurs, Apple est resté prisonnier de son approche trop conservatrice. Les fonctions d’IA sont en effet venues s’ajouter en surface au système d’exploitation de l’iPhone, sans jamais bousculer les fondements de l’interface. Avec l’IA, Apple était en mesure de révolutionner le fonctionnement d’iOS. Au lieu de ça, Apple Intelligence est venu s’intégrer discrètement, presque en s’excusant, à l’iPhone sans bouleverser notre usage. C’est pourquoi Apple Intelligence n’a rien changé à notre vie quotidienne. Selon les rumeurs, iOS 19 devrait corriger le tir avec une vraie, et bienvenue, remise à niveau de l’interface de l’iPhone à l’ère de l’IA. On l’attend de pied ferme.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.