Alors que le Pentagone tient à faire entendre que les drones ne tueront jamais des cibles d’eux-mêmes, mais toujours parce qu’un humain a pressé le bouton (PDF, via Wired), la célèbre université de Cambridge, en Grande-Bretagne, a créé un centre d’étude du « risque existentiel » (Centre for the Study of Existential Risk – CSER).

Se poser des questions sur notre avenir

Ce centre a été fondé par un philosophe, Bertrand Russell, un astrophysicien, Lord Martin Rees, et un ingénieur, Jaan Tallinn, qui a également fondé Skype et participé à la création de Kazaa, la plateforme P2P de partage de fichiers qui a fait les grandes heures du piratage au début des années 2000.

Trois profils bien distincts qui partagent une question inquiète : comment l’humain va-t-il gérer la révolution de l’intelligence artificielle, de la robotique ou encore des nanotechnologies qui s’esquisse actuellement ?

De cette interrogation découlent évidemment des dizaines de questions connexes : et si les machines devenaient plus intelligentes que nous ? Et si nous n’avions plus notre place sur cette terre ? Et si nous manquions la dernière marche de l’« intelligent stairway » (Cf. MP3) ? Et si elles devenaient plus habiles à créer des programmes ou des robots que ne le sont les humains ? Alors, l’évolution technologique n’avancerait plus au rythme de l’humain et de son cerveau, mais à celui des circuits imprimés et des transistors toujours plus petits et performants. Ce serait notre chant du cygne : ce que le mathématicien Irving John Good, collaborateur du génial Alan Turing, prophétisait en 1965 en parlant de « notre dernière invention ».

2001 A Space Odyssey – Hal 9000 Odyssey part 1 par non-humain

Recueillir de l’intelligence

Sur le site, extrêmement dépouillé du CSER, on lit ainsi : « beaucoup de scientifiques sont préoccupés par le fait que les développements dans les technologies humaines pourraient bientôt poser de nouveaux risques allant jusqu’à l’extinction de notre espèce en tant que telle ». Partant de là, les trois pères fondateurs déplorent que « ces problèmes requièrent plus d’attention scientifique qu’ils n’en reçoivent pour l’instant ».

Ils annoncent conséquemment que leur « objectif est de détourner une petite fraction des grandes ressources intellectuelles de Cambridge et sa réputation fondée sur sa prééminence scientifique passée et présente, pour s’assurer que notre propre espèce ait un futur à long terme ».

Péril en la demeure ?

Ce projet est revenu sur le devant de la scène après que l’université a confirmé le lancement du centre pour l’année 2013. Le premier message daté d’avril 2012 a été suivi par la publication d’un article de Huw Price et Jaan Tallinn sur le site Conversation en août dernier.

Le centre pour la survie de l’espèce, si on voulait le sous-titrer un peu légèrement, ne semble donc pas devoir être lancé rapidement. Mais ses fondateurs eux-mêmes paraissent avoir de la peine à estimer l’urgence de la chose. « Nous ne savons pas encore exactement ce qui différencie la pensée humaine des machines à algorithme d’apprentissage de génération actuelle. Nous ne connaissons pas l’espace qui sépare le niveau de progression lent et stable de la courbe croissante ». Autrement dit, quand surviendra la singularité technologique dont parle le scientifique et auteur de SF, Vernor Vinge ? Sans apporter une réponse précise, ils donnent toutefois une première estimation : « certains indices de tendance pointent vers le milieu de ce siècle ».

Pire que la mort

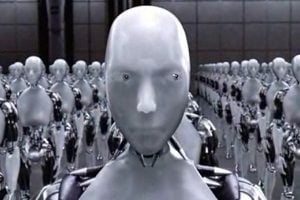

Que faire, dès lors, pour éviter HAL, iRobot et autres Terminator ? « Nous pensons qu’une bonne première étape pourrait être d’arrêter de traiter les machines intelligentes comme un dérivé de la science-fiction, et de commencer à les considérer comme une part intégrante de la réalité à laquelle nous, ou nos descendants, serons confrontés, tôt ou tard ».

Car, sans même imaginer un avenir apocalyptique à la Matrix, où l’humain ne serait qu’une pile, le pire pourrait bien être que nous ne soyons plus l’espèce la plus intelligente. Nous serions alors à la merci, non pas de « machines mal intentionnées, mais de machines qui ne nous considèrent pas dignes d’intérêts ». Pire que des animaux, pire que des insectes. Y aura-t-il des intelligences artificielles entomologistes ?

On a beau être prévenu qu’il ne faut plus aborder le sujet sous cet angle, il faut bien dire que cela ferait un beau scénario SF…

Sources

Cambridge Project for Existential Risk

Article de Huw Price et Jaan Tallinn sur Conversation

Podcast de Jaan Tallinn à propos de sa théorie de l’Intelligence Stairway

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.