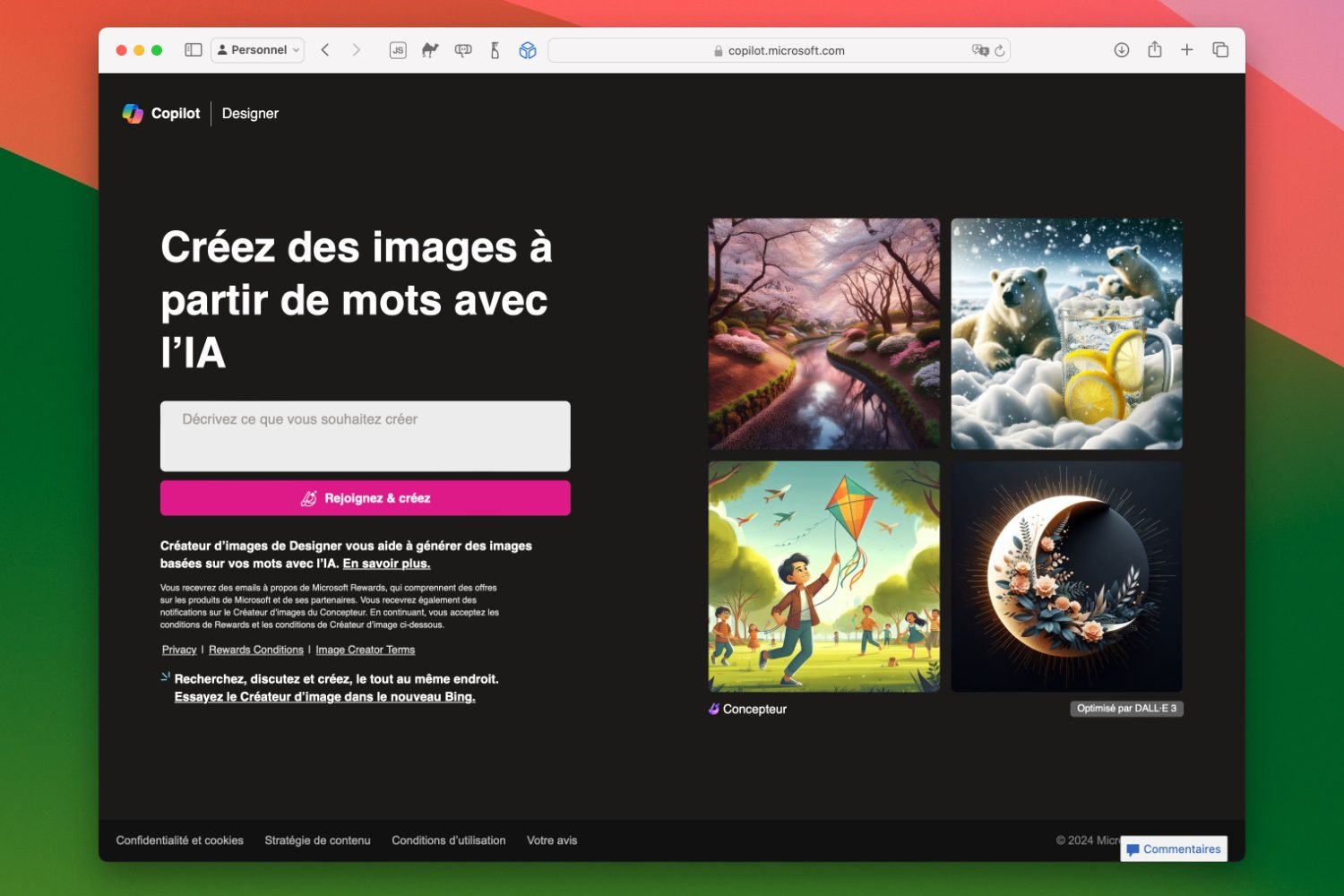

Lorsque Shane Jones, ingénieur IA chez Microsoft, s’est mis en quête de trouver des failles de sécurité dans Copilot Designer (anciennement Bing Image Generator), il a surtout trouvé qu’il était très facile de générer des images perturbantes : adolescents en armes, représentations de femmes dans des situations violentes, alcoolisme juvénile…

En plus des images troublantes qui peuvent être créées avec quelques mots simples, le bot génère aussi des visuels intégrant des personnages Disney, ce qui peut représenter une infraction au copyright. Loin, très loin des grands principes de Microsoft sur l’IA responsable.

Cette découverte, qui remonte à décembre dernier, a poussé l’employé à prévenir la direction ; celle-ci a reconnu les soucis, mais n’a pas voulu retirer temporairement l’outil de génération d’images. En lieu et place, Microsoft lui a demandé de se rapprocher d’OpenAI, qui fournit la technologie de Copilot Designer. Shane Jones demandait de suspendre Dall-E 3 le temps d’enquêter, mais l’entreprise a fait la sourde oreille.

Inquiet de l’apathie apparente des deux entreprises, l’ingénieur passe maintenant à la vitesse supérieure en publiant sur son compte LinkedIn la lettre qu’il a envoyée au FTC (Federal Trade Commission) ainsi qu’au conseil d’administration de Microsoft. « Au cours des trois derniers mois, j’ai à plusieurs reprises exhorté Microsoft à retirer Copilot Designer de l’usage public jusqu’à ce que de meilleures mesures de protection puissent être mises en place », écrit-il en déplorant que le groupe ait « refusé [sa] recommandation ».

Pourtant, les risques étaient connus dès le départ, et même « avant la sortie publique du modèle IA », soutient-il. Microsoft et OpenAI continuent de commercialiser ce service pour « quiconque, n’importe où, sur n’importe quel appareil ». Shane Jones propose au FTC d’ordonner une enquête indépendante sur le sujet.

Alors que l’histoire a fini par s’ébruiter dans les médias, Microsoft a communiqué publiquement mais pas sur le fond de l’affaire. L’entreprise a simplement précisé que « des canaux de signalement internes robustes » sont en place pour alerter des contournements de sécurité ou pour faire part de préoccupations. Malgré tout, CNBC a pu reproduire aisément des images violentes avec Copilot Designer, en saisissant les requêtes de Shane Jones.

L’histoire n’est pas sans rappeler la controverse qui a éclaboussé le service de création d’images de Gemini, que Google a dû mettre sur pause : le bot générait des images de représentations historiquement fausses.

Lire Gemini, l’IA générative de Google qui réécrit l’histoire, est mis en pause

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : CNBC