Suivre une valise ou une personne suspecte de caméra en caméra dans tout un aéroport, c’est déjà possible sans intervention humaine… grâce à la vidéosurveillance intelligente, un système logiciel qui récupère des images vidéo, en produit une interprétation et délivre une alerte. Mais ce type de dispositif ne fonctionne que dans un espace circonscrit et avec un champ d’observation limité à ce que voient des caméras, fixes la plupart du temps.

Des barrières vouées à être repoussées. Des chercheurs de l’Université de Cornell aux Etats-Unis s’attellent à faire collaborer des groupes de robots mobiles, pour qu’ils partagent leurs informations et interprètent ensemble les images qu’ils collectent.

Les travaux sont financés par l’Office naval américain de la recherche (ONR) et vont durer quatre ans. L’idée est de combiner plusieurs images d’une même zone issues de différentes caméras, afin d’identifier et de suivre des objets et des personnes d’un endroit à un autre. Le projet a pour ambition de faire travailler ensemble des observateurs mobiles, des caméras fixes et des sources externes. La promesse de plus rien laisser échapper à la vidéosurveillance.

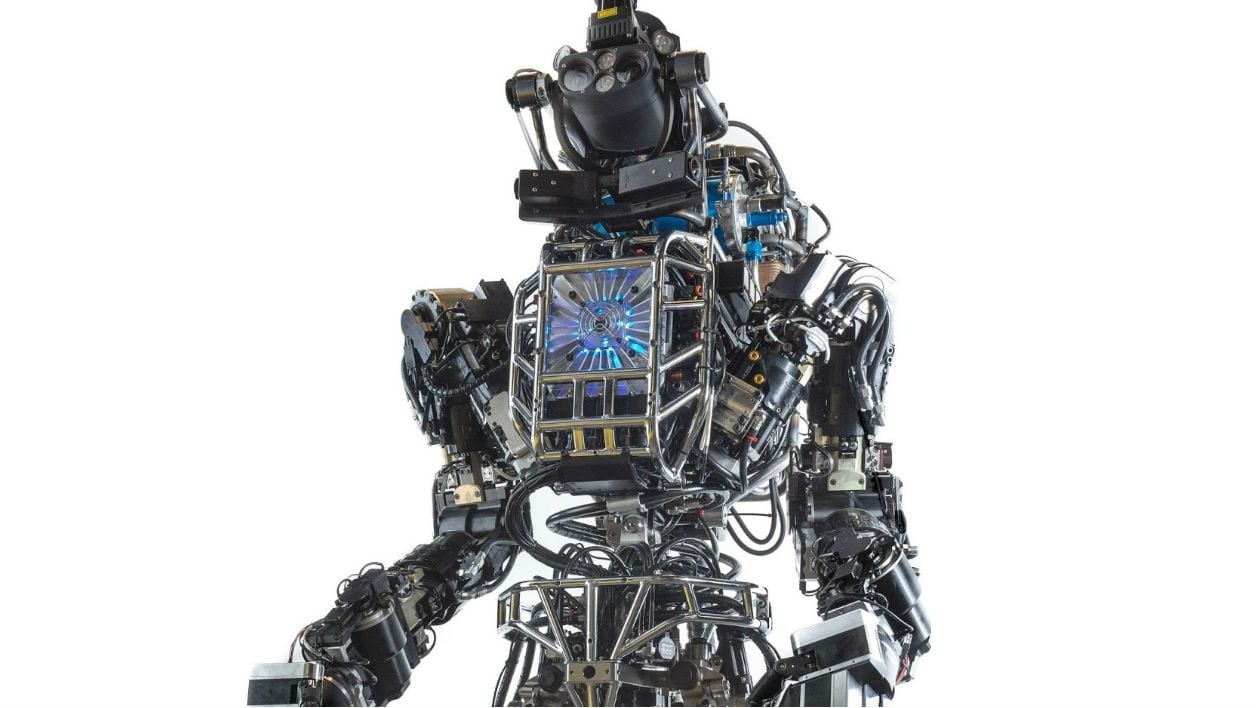

Robots humanoïdes, drones et voitures autonomes nous épieront

La partie la plus intéressante concerne les fameux observateurs mobiles. Il pourra s’agit de drones, de voitures autonomes et de robots humanoïdes mêlés à la foule. Ils enverraient leurs vidéos à une unité de contrôle centrale pouvant solliciter d’autres caméras, tout en ayant accès à Internet pour effectuer des recherches et mieux identifier le contenu. Ce qui ne trancherait pas avec les systèmes actuels, en revanche, c’est la nécessité de toujours définir préalablement des critères pour déclencher le tracking comme une personne qui court ou un sac à dos trop volumineux, par exemple.

L’interprétation reposerait à la fois sur des modèles statistiques et de deep learning. Impossible, en effet, qu’un opérateur humain vienne à bout de cette multitude de points de vue. Une fonction programmation est également prévue pour obtenir des données additionnelles afin de résoudre des incertitudes quant à la façon d’éviter un obstacle ou de se rapprocher d’une cible lorsqu’une vue plus précise est nécessaire.

La Navy espère pouvoir implémenter un jour ces systèmes sur ses propres drones et véhicules autonomes. Mais à court terme, les premières expérimentations devraient avoir lieu sur le campus de Cornell. La surveillance n’est évidemment pas la seule application possible. Le déminage et l’assainissement d’un terrain après un accident nucléaire, une inondation ou un ouragan sont aussi envisagés.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.