C’est l’histoire d’un éléphant qui a réussi à se retourner aussi rapidement qu’un lièvre. En 2023, IBM s’est lancée dans la course à l’intelligence artificielle face à de redoutables startups et des géants tels que Google, Amazon et Meta. En quelques mois, elle a introduit la plateforme WatsonX pour répondre à divers besoins à l’aide de nouveaux outils et de puissants modèles de langage. IBM crée même ses propres modèles, ajoutant cette plateforme « en haut de la pile » comprenant les services Red Hat et Z.

Pour Robert Haas, un chercheur du laboratoire IBM Research à Zurich (Suisse), 2023 a été une année hors du commun. Avec ses 27 ans de carrière chez « Big Blue », il juge le lancement comme une belle revanche sur des pronostics externes pessimistes. Et un beau moyen de rassembler les dizaines de milliers de salariés de cet énorme paquebot qu’est IBM. À l’instar du quantique, l’IA prend une place centrale. 150 000 salariés de la multinationale ont été invités à venir tester par eux-mêmes. Objectif : se rendre compte, le plus rapidement possible de l’ampleur de la technologie. Et y prendre part.

01net : La mobilité professionnelle et le manque de longévité en entreprise ne semblent pas toucher IBM, qui a réussi à vous faire rester 27 ans dans ses rangs. On imagine que de nombreux autres acteurs aimeraient vous débaucher. Pourquoi n’êtes-vous jamais parti ?

Robert Haas : C’est très simple : je suis parti ailleurs, mais toujours chez IBM. Voilà ce que je dirais pour faire simple, mais c’est vrai. C’est l’avantage d’une multinationale, je n’ai pas fait plus de 5 ans au même poste. Je suis passé de la recherche au développement, puis à la stratégie d’entreprise. Et me voilà de retour dans la recherche. Chacune de ces expériences m’ont aidé. À chaque fois que je change, je me sens un plus pertinent pour l’entreprise. Les profils qui ont connu différents postes comme cela permettent de relier les points dans cette immense constellation.

Avec le temps, on apporte davantage de valeur. En passant de la recherche à la stratégie, j’ai pu ajouter à mon quotidien un contact avec le client qui n’est pas possible quand l’on est uniquement dans la recherche. Et en même temps, mes compétences dans la recherche m’ont permis d’être plus clair avec eux, leur expliquer plus simplement ce qu’il se passe du côté de la R&D ; l’état actuel du produit et les évolutions futures. Ensuite, quand je suis retourné dans la recherche, j’ai aussi pu tirer des leçons de tout ça et changer les processus pour trouver une meilleure manière de fonctionner.

Maintenant, je suis retourné dans la recherche et cela me va très bien, car je peux continuer à m’exprimer librement. Les projets que je réalise ne seront pas forcément des projets qui déboucheront sur des produits chez IBM demain, alors c’est plus simple.

01net : Est-ce que les chercheurs du lab, en raison de leur diversité générationnelle, ont des points de vue variés, notamment en ce qui concerne l’intelligence artificielle ?

R.H : Évidemment, quand j’observe les nouvelles recrues qui rejoignent nos équipes en tant que doctorant, pour eux, les outils sont naturels. C’est un peu inné. Pour les générations précédentes, cela a nécessité un effort. Mais IBM a eu l’intelligence de s’en rendre compte, de faire une remise à niveau pour tous, et de faire expérimenter chacun, quel que soit son poste, les nouveaux outils d’intelligence artificielle. On s’est alors tous rassemblés cette année sous la forme d’un hackathon. On était plus ou moins 150 000. La recherche, la vente, les ressources humaines, la communication… tout le monde a été convié à tester l’IA.

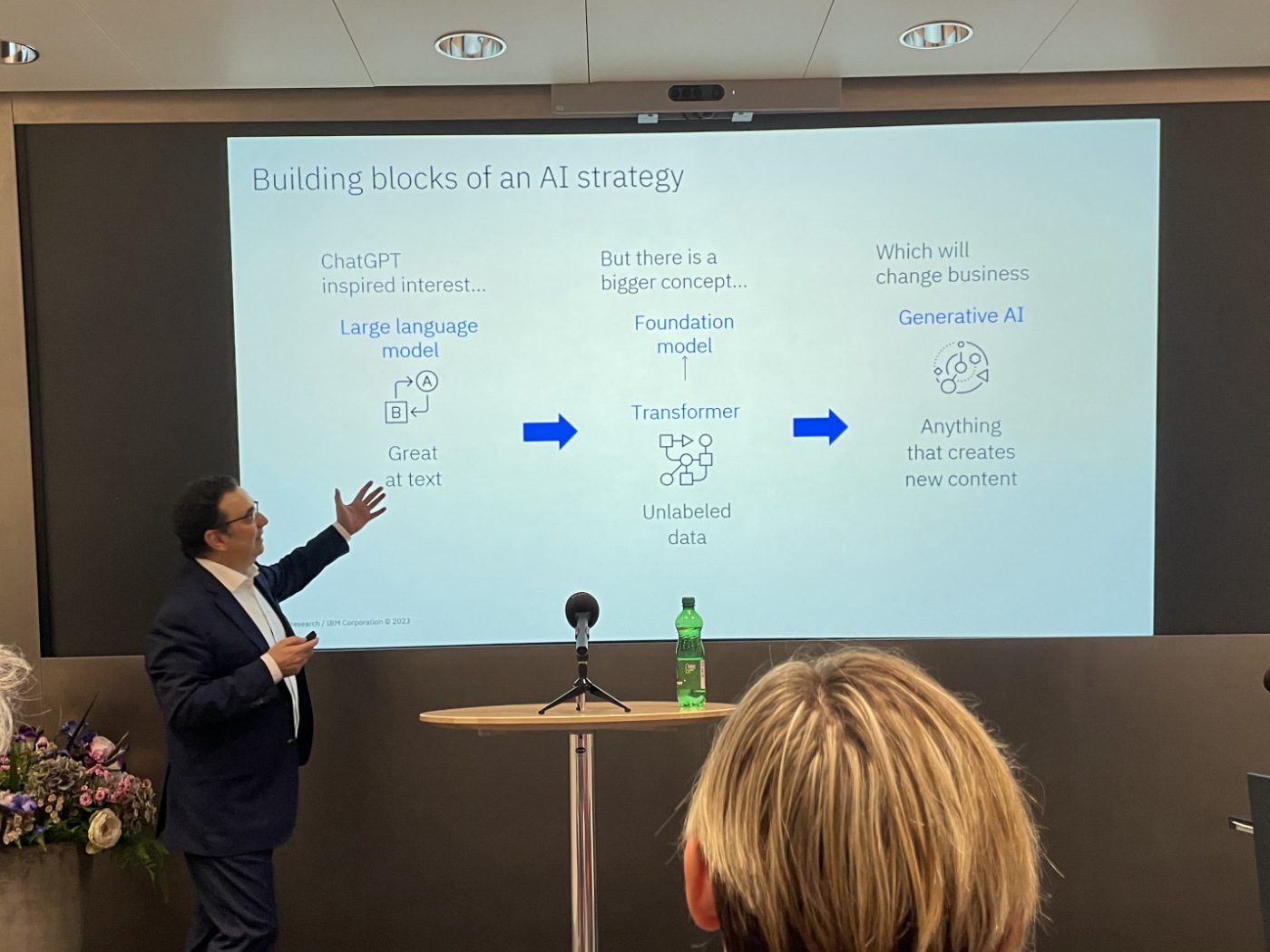

À travers ces ateliers, on s’est mis à faire du prompt tuning, et on s’est rendu compte de ce qu’on pouvait réaliser. Certains avaient déjà compris la valeur des large language models (LLM), qui allaient bien au-delà de ce qui avait été anticipé. Mais entre le fait d’avoir lu ça quelque part et de l’expérimenter, il y a une différence. On s’est rendu compte que les LLM pouvaient résoudre des problèmes auxquels nous ne les avions encore jamais entraînés. C’est là l’une des grandes spécificités de ceux que l’on appelle aujourd’hui les modèles de fondation (foundation models).

01net : Le grand public a eu le déclic il y a un an, avec ChatGPT. Chez IBM, à quel moment avez-vous compris ce qu’il se passait ?

R.H : Globalement, tout s’est passé en 2023, avec l’intégration de WatsonX, que nous avons annoncé à la conférence Think au début de l’année. Bien sûr, dans nos branches de recherche et développement, l’intelligence artificielle n’est pas nouvelle. Nous avons récemment fait un workshop avec nos clients pour les outils de support client et ce projet a démarré il y a plus de trois ans. Maintenant, tout a changé en termes d’échelle. Il y a moyen d’aller au-delà en termes d’efficacité et le boom de ChatGPT l’a bien montré.

À ce moment-là chez IBM, on s’est rendu compte qu’il était temps de tout orienter dans cette direction. De rassembler tous les travaux que l’on avait et d’amplifier notre action. Heureusement, ça a fort bien raisonné en interne. Parce que les gens se sont vraiment sentis investis grâce au hackathon que l’on avait organisé. Et cela a eu pour effet de changer la perception des analystes sur IBM.

01net : Quelle était leur perception ?

R.H : On nous a longtemps vu comme un éléphant ; un gigantesque paquebot qui prendra beaucoup de temps pour opérer son virage. Tout le monde ne s’attendait pas à ce que l’on arrive à le faire. Or, ce que l’on a montré, c’est que lorsque IBM se met en ordre de marche et aligne toutes ses forces vers un but spécifique, ça fonctionne.

Maintenant, ces analystes se disent que la société mérite d’être suivie sur ces sujets. Ils se disent aussi que l’on fait les choses bien pour le client. Que nos produits lui simplifieront la tâche, plutôt que de lui la complexifier. Le potentiel de l’IA, on le connaît. La difficulté, c’est de faire en sorte que nos produits ne se présentent pas comme une boîte de Pandore que l’on ouvre et qui nous perd dans un amas d’informations que l’on ne comprend pas, et qu’on ne contrôle pas.

Contrairement à d’autres entreprises, IBM a un historique qui ne comporte pas d’implication dans de gros scandales. Pas mal d’entreprises de l’IA ont payé de lourdes amendes. Les entreprises cherchent à avoir un partenaire qui leur permette d’évoluer sans risque. Elles savent maintenant vers qui se tourner.

01net : Cela veut dire que l’IA est un moteur de croissance pour IBM aujourd’hui ? Ou en êtes-vous encore au stade initial ?

R.H : Nous avons bientôt terminé de déployer toutes nos briques du projet WatsonX. Il ne manquait plus que la partie Gouvernance, que nous venons d’annoncer. Elle rejoint WatsonX AI où nous proposons aux clients de nombreux modèles, et WatsonX Data, pour que les clients puissent rassembler toutes leurs informations qu’ils aimeraient pouvoir intégrer à l’IA, en les rendant compatibles avec l’entraînement des modèles. WatsonX Gouvernance va faire en sorte que toutes ces nouvelles pratiques soient dans les règles de l’art, sans provoquer de risques aux utilisateurs.

La demande est bien présente chez nos clients. Et on y répond. On a développé cette nouvelle plateforme WatsonX qui vient se rajouter à la pile de celles que l’on avait déjà. Celles sur lesquelles on travaille depuis des années comme Red Hat.

01net : Est-ce que l’IA comme on la connaît aujourd’hui chez IBM va rester comme telle ? Ou comptez-vous aller plus loin, notamment dans l’intelligence artificielle généralisée ?

Tout cela va grandir. D’abord du côté de WatsonX, la plateforme est vouée à se développer comme les autres grandes plateformes IBM. J’aime la comparer avec ce que nous avons fait sur la plateforme Z. Elle n’est pas connue du grand public, mais elle est responsable de faire tourner en arrière-plan pratiquement chaque transaction de carte de crédit qui est effectué dans le monde. Les grandes banques en dépendent. Ce sont des systèmes qui, même dans des périodes de forte affluence comme avec Black Friday, continuent de fonctionner, sans problème. Ils ne sont jamais attaqués par des virus. À l’avenir, WatsonX doit avoir la même renommée.

Ici dans les laboratoires de Zurich, nous travaillons sur l’après. Dans les dix prochaines années, il y aura des innovations liées aux techniques d’intelligence artificielle qu’on mettra à disposition, telle que l’intelligence artificielle généralisée (AGI). Une intelligence artificielle plus intelligente. Un des concepts sur lesquels mes équipes travaillent ici est la partie symbolique, que l’on appelle l’intelligence symbolique. L’idée est de ne pas seulement dépendre d’un réseau de neurones qui demande une quantité colossale de données à répétition pour pouvoir apprendre.

Je vous donne l’exemple d’un système de conduite pour automobile, pour que ce soit plus compréhensible. Au lieu d’entraîner le système avec une grosse quantité de vidéos de voitures qui s’arrêtent à une intersection quand une autre voiture arrive de la droite, nous pourrions lui faire ingérer le code de conduite directement, et intégrer cette notion dans celle-ci. On en arrivera au même point, mais avec l’apprentissage neuronal classique, il faut une quantité phénoménale de vidéos différentes qu’il faudra répéter plusieurs fois pour que le réseau ait compris et ajusté ses poids pour obtenir la bonne réponse.

Le travail est donc d’aller faire ingérer le modèle de ces 50 pages comprenant toutes les règles et leur description, puis d’utiliser cette intelligence symbolique en combinaison avec l’intelligence basée sur les données, le Deep Neural Network. Ce sera beaucoup plus efficace ainsi. Notamment dans les situations uniques où le modèle n’aurait pas été entraîné. Avec un système de conduite, cela pourrait être utile si une voiture rencontre un panneau stop tombé sur le bas-côté de la route. On pourra aller plus loin dans ce que l’on appelle la out of distribution generalization : la généralisation de ce qu’on a appris en dehors des données fournies pendant l’apprentissage.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.