« Il est difficile de planter une graine pour le futur, de tenter de décrocher la lune tout en ayant pour objectif de fournir quelque chose de concret, d’applicable, de bénéfique ». C’est ce que glissait en substance Bill Dally, responsable de la recherche chez Nvidia, en amont de l’ouverture de la dixième GTC.

Ne vous arrêtez pas à son interface

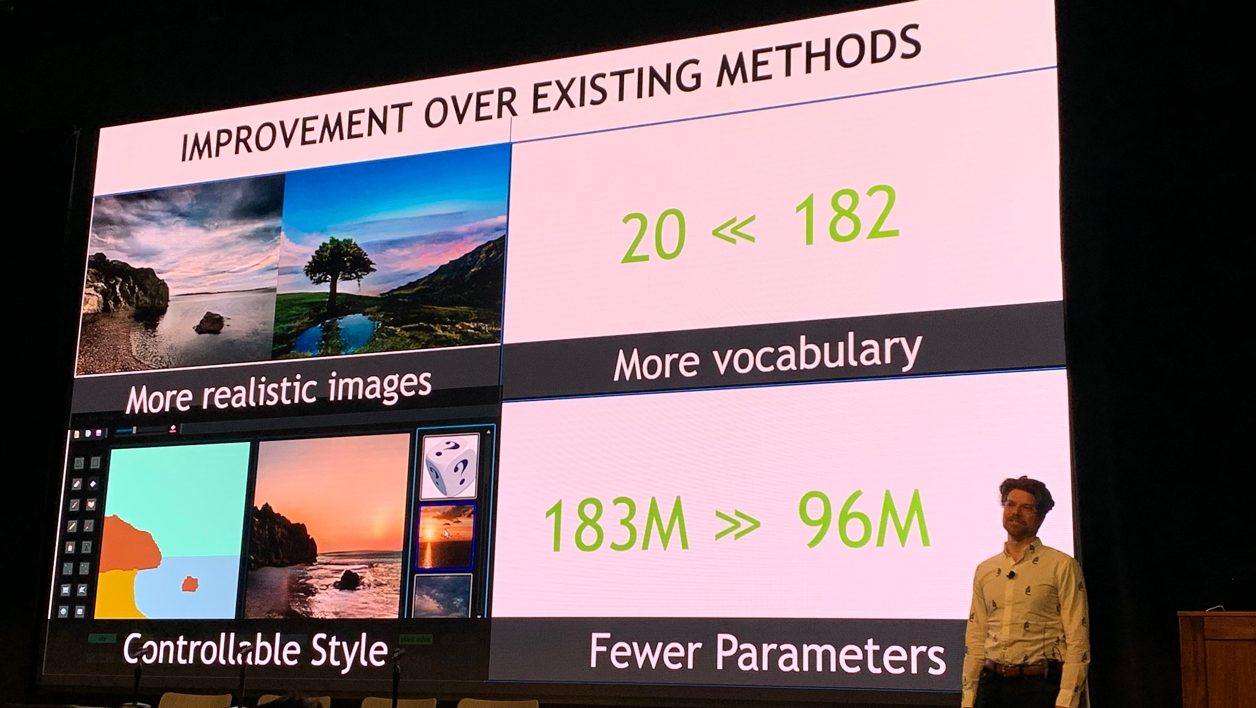

Des mots qu’on avait encore en tête quand deux chercheurs sont montés sur scène pour présenter un outil encore expérimental. L’interface ressemble à celle d’un logiciel de dessin sous Windows 3.1. Dans une barre verticale à gauche, trois pauvres outils attendent que quelqu’un se souvienne de leur existence, tandis que la partie inférieure de l’écran est occupée par des mots placés sur des boutons aussi gracieux que ceux d’un site en HTML 4.

« Mer, ciel, herbe, nuage, eau, neige, colline, bois, gravier », etc. La liste est longue. C’est une palette sémantique, explique Bryan Catanzaro, vice-président de l’apprentissage profond appliqué pour Nvidia, avant de demander à Ming-Yu Liu, un chercheur de Nvidia, de commencer à réaliser une suite de vagues gribouillis. Ils ressemblent plutôt à des aplats de couleurs minimalistes sur la partie gauche de l’écran.

Il nous faut alors une petite seconde pour comprendre que les formes et traits grossiers à gauche ont un pendant à droite. En fait, la partie gauche pourrait être une version enfantine et géométrique du ciel puis du paysage montagneux avec ses arbres, son coucher de soleil et ses pics acérés. Dans les faits, les scientifiques appellent cela des cartes de segmentation. Cela sonne mieux, mais c’est toujours aussi moche.

Le photoréalisme à la portée de tous

Pendant qu’on entend, relativement incrédules, Bryan Catanzaro annoncer que cette application permet de créer une photo à partir de ce qui ressemble à un dessin de livre de coloriage pour enfant de moins de 18 mois, on voit son acolyte, choisir le pinceau, puis sélectionner le mot « nuage ». Il dessine ensuite une forme rapide dans l’image à gauche, avant de choisir l’outil remplissage et de remplir ce qui aurait pu être un lamantin malade ou un étron volant. A gauche, la forme devient blanche, plane et moche, tandis qu’à droite, tout à coup, apparaît un nuage à faire rêver les paréidolistes les plus exigeants.

Sur sa lancée, Ming-Yu Liu dessine un arbre à gauche, en choisissant arbre dans la palette et évidemment, à droite, apparaît un pommier plutôt joli, taillé à la française. Ce pourrait également être un poirier, difficile à dire de loin.

On commence alors à se gratter la tête et arrête tout à trac quand le dessinateur-scientifique trace une mare dans laquelle se reflète immédiatement le ciel et notre cognassier.

Pour enfoncer le clou, Bryan Catanzaro demande à son coéquipier de mettre de la neige sur le sol. Magie ! Non seulement le sol devient blanc et ses formes plus adoucies, estompées, mais l’arbre… a perdu ses feuilles.

« Nous avons entraîné notre réseau neuronal pour qu’il soit capable de générer des pixels et textures qui correspondent aux mots choisis dans la palette sémantique et qu’il sache à quoi doit ressembler une diversité d’objets ou d’éléments naturels », sourit le vice-président de l’apprentissage profond appliqué, fier de son effet, « mais nous avons également fait en sorte qu’il apprenne l’existence de liens entre ces différents éléments. Ainsi, une surface d’eau reflète naturellement son environnement et un arbre perd-il ses feuilles à l’automne ou en hiver. »

Tout cela, évidemment, sans que le dessinateur, qui l’a bien cherché, ait à intervenir ou à se casser la tête.

Un réseau qui fait forte impression

Les deux scientifiques ont appelé leur projet GauGAN, mot-valise qui réunit Gauguin et GAN, pour Generative Adversarial Network, une évolution du deep learning qui permet à une intelligence de « créer » en se confrontant au savoir d’une autre IA. Le résultat est assez incroyable. En temps réel, sous nos yeux, sont nées des montagnes, des mers transparentes ou des mares opaques et, à quelques détails près, il aurait été difficile de savoir qu’on n’avait pas à faire à un vrai cliché.

Mieux encore, les deux chercheurs nous assurent que la beauté de la mathématique en jeu derrière ce tour de force assurera un rendu aléatoire à chaque arbre créé, à chaque ciel brossé, à chaque plage esquissée… Une infinité d’environnements se dresse devant nous.

En attendant qu’on s’en remette, Bryan Catanzaro nous explique que sa petite démo tourne sur une RTX 2080 Ti. Il faut un GPU puissant pour le rendu en temps réel, avec des Tensor Core plutôt musclés, argumente-t-il. Mais une démo plus limitée pourrait tourner sur un simple CPU ou avec une puce graphique plus modeste…

Alors Bryan Catanzaro, sans doute pour faire plaisir à Bill Dally, explique qu’il y aura bien des façons d’intégrer son programme dans des outils de création graphique pour architecte, par exemple. Il lui voit même un bel avenir dans la création de jeu vidéo, pour que les environnements soient plus réalistes et réactifs. Mais nous, on sait bien que Bryan n’a fait ça que pour nous faire plaisir. Il veut tout simplement qu’on puisse s’amuser à dessiner des M. Patate photoréalistes avec son GauGAN quand il sera disponible sur AI Playground, la partie du site de Nvidia où la société nous invite à jouer avec ses outils motorisés par une intelligence artificielle.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.