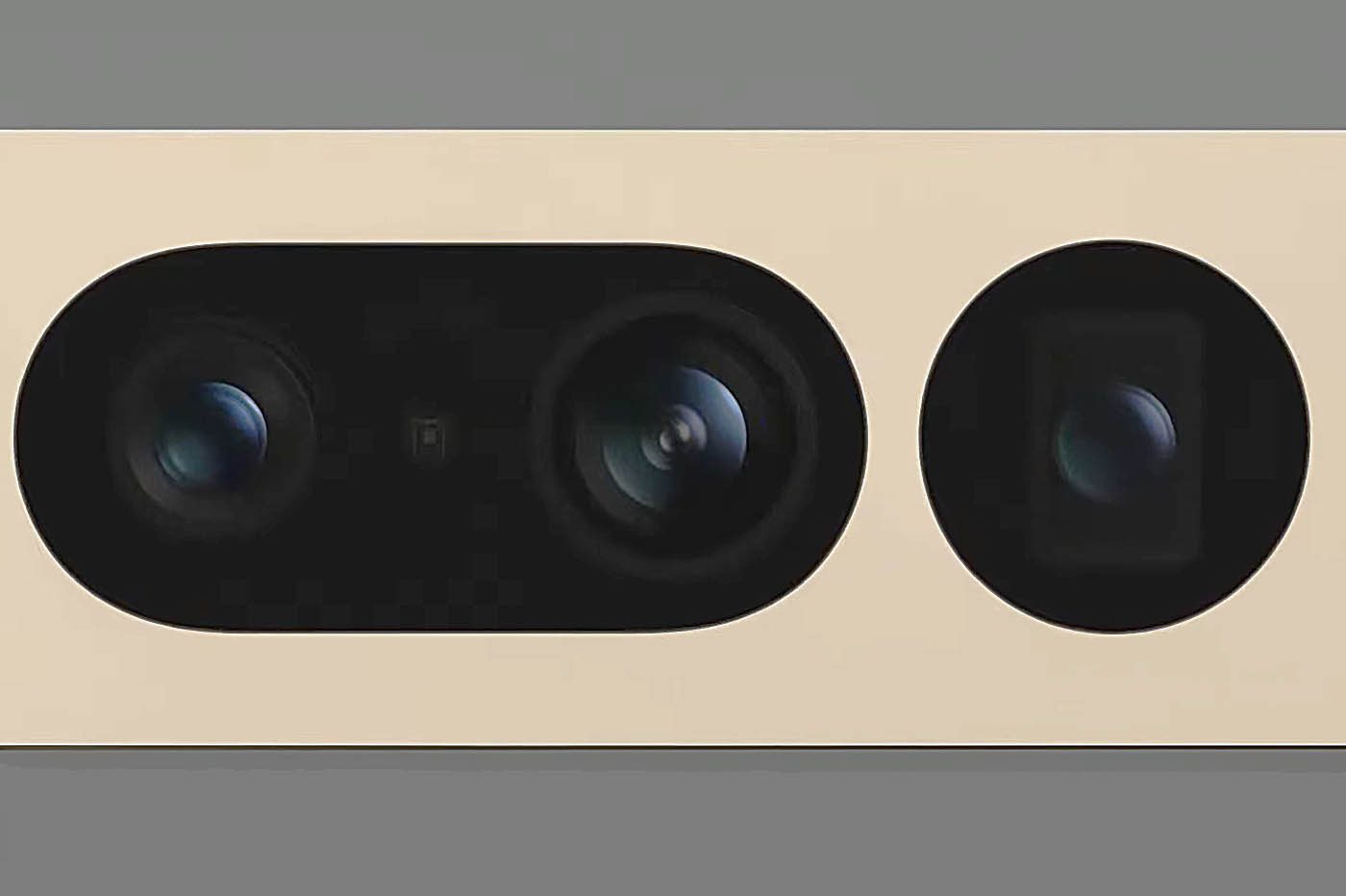

En écoutant la conférence de Google, on pourrait croire que Google fait toujours plus confiance à son processeur Tensor G2 et à ses super algorithmes issus de l’apprentissage machine. S’il est évident que Google n’a pas délaissé son ADN autour du visual computing, l’Américain semble avoir appris de ses erreurs. Au moins sur quelques plans. Par rapport au Pixel 6 Pro, le Pixel 7 Pro, fleuron de la nouvelle fournée, paraît similaire : un ultra grand-angle, un grand-angle et un téléobjectif. Mais en regardant de près les fiches techniques, on perçoit des changements d’importance dans les deux modules secondaires.

Le module caméra principal ne bouge pas – et ce n’est pas forcément une mauvaise chose. Il faut souvent deux voire trois générations pour maîtriser pleinement un module caméra, et l’équivalent 25 mm f/1.9 a fait ses preuves. Le capteur 48 Mpix est toujours d’assez grandes dimensions (1/1.31 pouce) et s’appuie toujours sur un système de quatuor de photodiodes (quad bayer).

Le premier progrès est à chercher du côté de l’ultra grand-angle. Déjà, Google sort du Moyen-Âge et lui offre (enfin !) l’autofocus. Ce n’est pas du luxe. Mais en plus, s’il conserve ses petites dimensions (1/1,29 pouce) et sa définition de 12 Mpix, il profite d’une toute nouvelle optique. Exit l’équivalent 17 mm, bonjour le 13 mm f/2.2 avec capacité de photo macro à 3 cm.

Si nous ne crachons pas sur tout ajout de fonctionnalité tant que cela reste de qualité, nous ne cacherons pas que l’ajout de macro sur l’ultra grand-angle n’est pas vraiment la bonne solution – pas plus que cela ne l’est sur les iPhone. Si cela permet quelques prises de vue sympas, la réalité est que non seulement la lumière reste un problème majeur à 3 cm de distance. Et que la totalité des objectifs macros des vrais appareils photo est à chercher au-delà des 50 mm. Et pour une bonne raison : c’est là que la compression des verticales, le respect des proportions et l’isolation des sujets sont les plus intéressant visuellement.

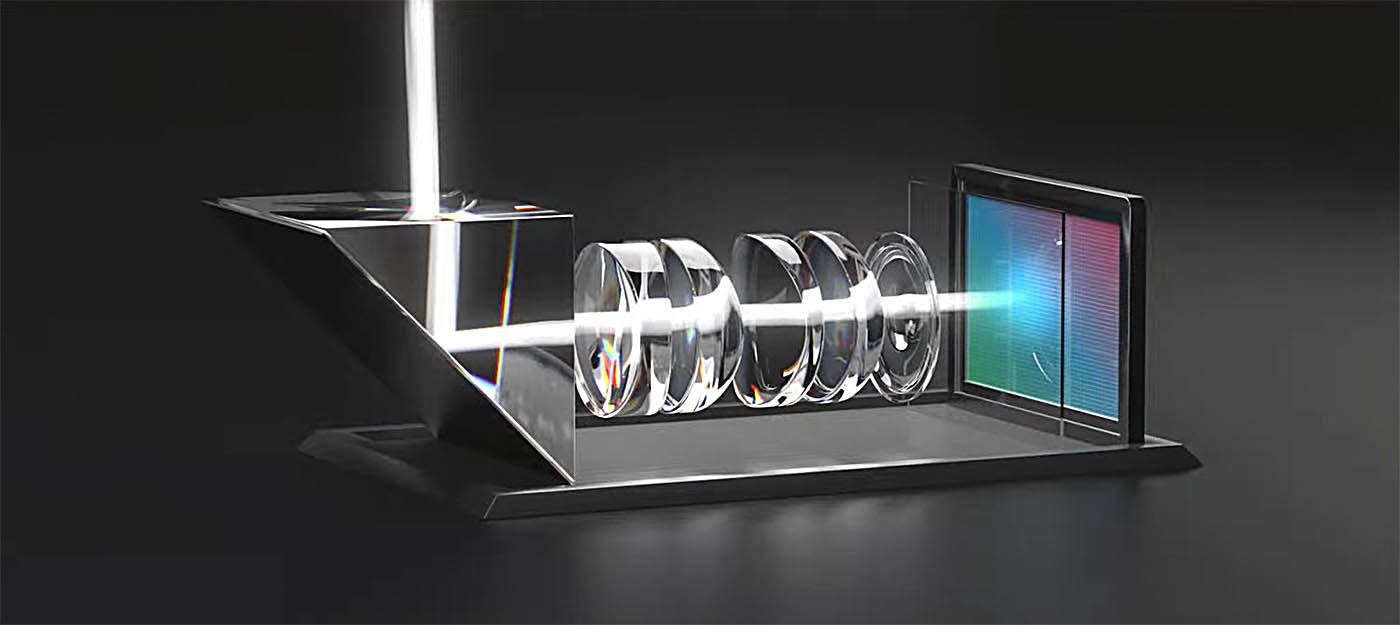

En matière d’évolution, le téléobjectif est le plus intéressant des trois modules. Non seulement on passe d’un équivalent 104 mm f/3.5 à un 120 mm f/3.5 qui offre un petit boost de zoom, mais il intègre surtout un capteur de grande dimension pour un téléobjectif, alors que de nombreux modules concurrents sont limités à du 1/4’’ (prononcer « un quart de pouce ») ou du 1/3.5’’, le module téléobjectif du Pixel 7 Pro emploi un gros 1/2,55’’. La même taille que le module caméra principal de l’iPhone 11 Pro ! Et grâce à la qualité de ses algorithmes, Google a gonflé les muscles et a revendiqué « la meilleure qualité de zoom sur un smartphone à ce jour ».

Zoom multi-modules appuyé par les algorithmes

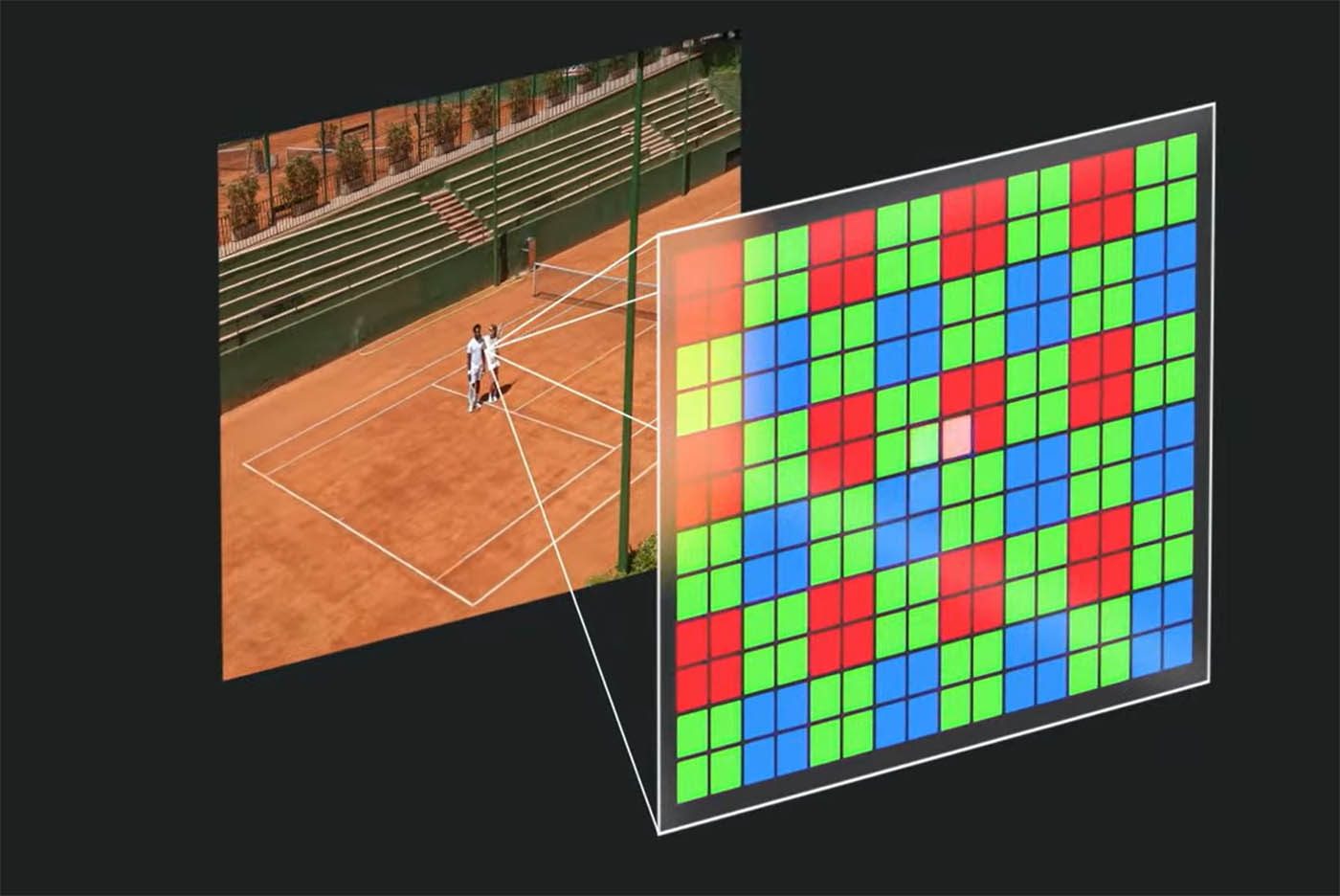

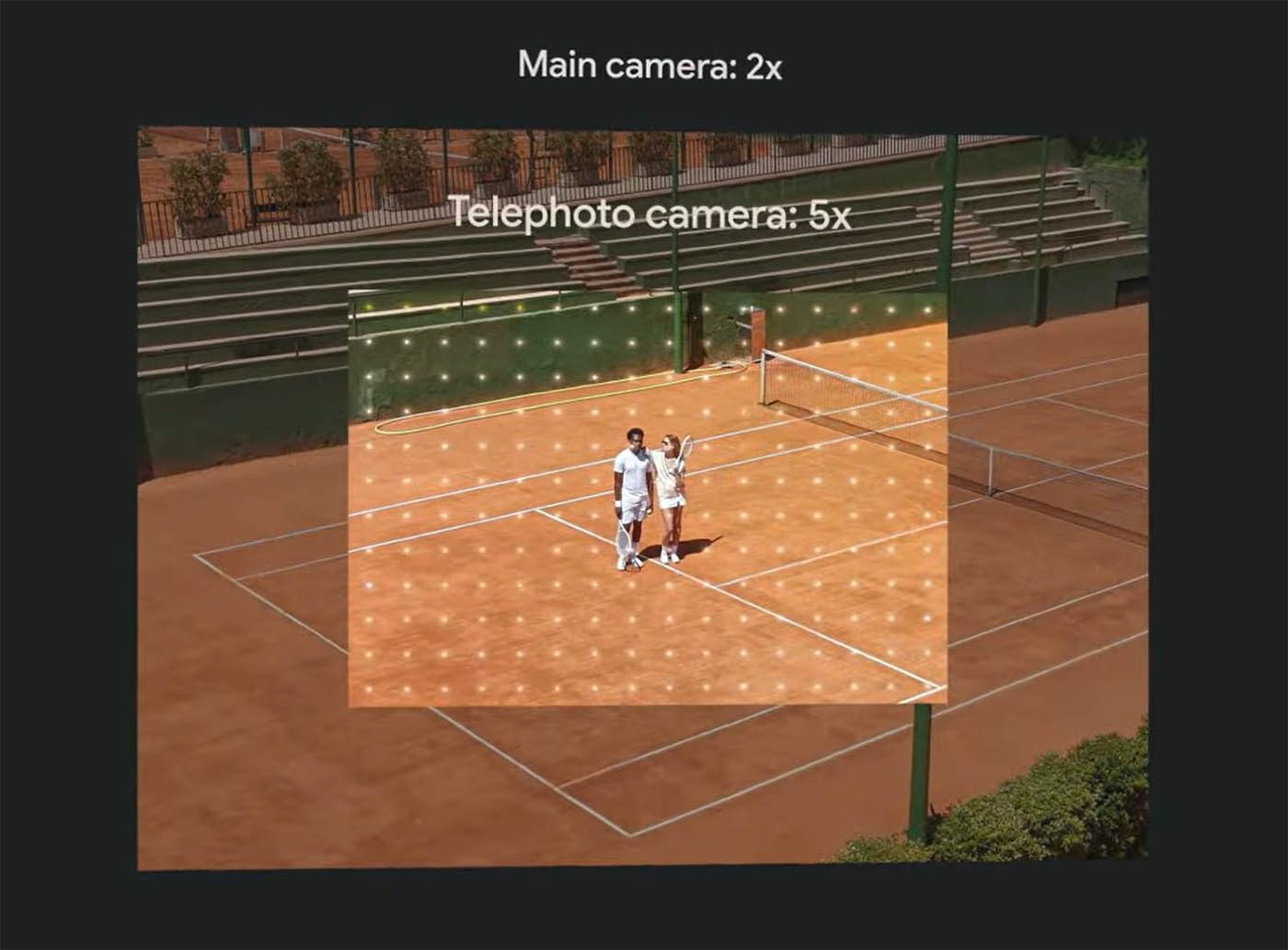

La qualité des algorithmes de zoom de Google est reconnue, même si les terminaux passés ont montré les limites de l’exercice – et Google a fini par intégrer de vrais téléobjectifs pour remplir sa mission. Pour le Pixel 7 Pro, Google revendique une puissance de zoom x10 avec un téléobjectif estampillé « x5 ». Non seulement grâce à l’entraînement de ses IA, mais aussi grâce à une approche multi-module qui double virtuellement la puissance native de chaque focale.

Cette approche lui permet non seulement d’améliorer la qualité à chaque couverture angulaire native des modules, mais aussi et surtout à tous les paliers intermédiaires. Et Google d’utiliser, comme Apple, le « cœur » du capteur module caméra principal pour proposer un équivalent 50 mm. Un module caméra « virtuel » qui a comme avantage de ne pas avoir (trop) recours à de la recomposition d’image puisque les 12 Mpix peuvent être utilisés nativement.

Google affirme avoir retravaillé tous ses algorithmes entraînés par apprentissage machine (machine learning, ML) sur des ensembles de données plus grands et plus riches que par le passé. Ce qui lui permet d’améliorer la qualité d’image dans de nombreux domaines. Comme celui longtemps délaissé de la couleur de peau.

Un rendu des couleurs plus juste pour toutes les peaux

En mai 2021, Google avait présenté ses travaux pour améliorer le rendu de la couleur de peau des humains non asiatiques ou caucasiens. En effet, une grande partie des travaux autour des algorithmes de rendu d’image initiaux étaient hérités des travaux effectués dans le monde des pellicules chimiques. Qui étaient spécifiquement travaillées pour bien reproduire les peaux claires, le marché principal de la photo à l’époque.

Si une bonne partie de l’industrie photo travaille dessus depuis des années, Google a été le premier à consacrer une importante communication autour de ce problème. Le géant est allé plus loin cette année en faisant grossir son pack d’images à plus de 10.000 clichés de personnes à peaux plus ou moins sombres. De quoi améliorer, notamment, le rendu des peaux noires dans les scènes sombres, un travail difficile, car c’est justement quand la lumière baisse que les algorithmes ont du mal à différentier les textures. Pour Google, le Pixel 7 Pro est l’appareil photo « le plus inclusif », ce que nous vérifierons lors du test photo.

La chasse aux flous présents… et passés !

Si Google a fait des efforts en matière de hardware, l’ADN du géant américain est évidemment logiciel. Outre son travail autour des algorithmes de zoom, de détourage ou de rendu des peaux sombres, Google s’est aussi penché sur un problème récurrent du monde de la photo : la netteté des images. Ou plus précisément sur les photos floues. Grâce à son SoC Tensor G2 et ses nouveaux algorithmes ML de réduction du bruit, la fonction Photo Unblur du Pixel 7 Pro est deux fois plus performante que la génération précédente pour lutter contre les flous en post-traitement d’image. Pour le module caméra principal, il fusionne ses images à celles captées par l’ultra grand-angle pour éliminer tout flou de bouger des sujets.

Ce bonus qui ne s’arrête pas à la prise de vue. Google a effet intégré Unblur (déflouter en anglais) à Google Photos. Ainsi, ses algorithmes et la puce de votre Pixel 7/7 Pro peuvent travailler directement sur vos images stockées dans le cloud. Et ainsi faire (au moins en partie) disparaître les flous de vos anciens appareils photo. Dommage que Google ne propose pas cette fonction à tous les souscripteurs détenteurs de compte Google Photo et non détenteurs de Pixel…

À rebours de cette fonction, Google a ajouté pour la première fois une fonction de flou à son mode vidéo. Logiquement appelé Cinematic Blur (flou cinéma), la fonction est dans les pas de ce que propose Apple. Même si nous avons un doute quant à sa qualité : si celui d’Apple présenté l’an dernier avec l’iPhone 13 Pro était plutôt bon, les deux trois séquences que Google a dévoilées nous ont semblé un peu bancales. Espérons qu’il s’agissait de la compression YouTube utilisé pour la conférence en ligne.

Toujours dans la partie logicielle, Google profite de sa maîtrise de l’analyse d’image et de la puissance de son assistant vocal pour faciliter la prise de vue aux personnes aveugles ou mal voyantes. De quoi aider ceux à qui les yeux font défaut à faire de beaux selfies seul(e)s. Un progrès pour la communication visuelle de millions de personnes qui n’ont pas les yeux pour apparaître à leur avantage.

Si Google reste évidemment une machine de guerre logicielle, il est louable de voir l’Américain faire plus attention au hardware. Mais nous ne vous cacherons pas que nous sommes curieux de voir si, oui ou non, Google est en droit de revendiquer « la meilleure qualité de zoom sur un smartphone à ce jour ».

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.