Près de deux semaines après sa sortie, le chatbot de Microsoft fait-il aussi bien que ChatGPT, le robot conversationnel d’OpenAI sur lequel il s’appuie ? C’est la question à laquelle nous allons tenter de trouver un début de réponse. Car pour l’heure, le chatbot de Microsoft ne semble pas encore tout à fait opérationnel. Il faut dire que ses débuts ont été plutôt laborieux. La firme de Redmond, visiblement pressée de couper l’herbe sous le pied de Google avec Bard, s’est lancée à corps perdu dans une course à l’IA conversationnelle… sans vraiment prendre conscience des risques que cela pouvait engendrer.

Quelques jours après avoir été dévoilé au grand public, le modèle d’intelligence artificielle que Microsoft a intégré à son moteur de recherche Bing a commencé à dérailler. À tel point que l’entreprise américaine a rapidement dû prendre des mesures pour le museler afin de l’empêcher d’entrer dans des conversations délirantes. Le chatbot de Microsoft a ainsi fait le buzz à plusieurs reprises après s’être parfois montré colérique, déprimé et agressif.

La firme de Redmond, qui parait avancer un peu à l’aveugle, s’appuie néanmoins sur ces précieux retours d’utilisateurs pour tenter d’ajuster au mieux les paramètres de son chatbot. Le but est de faire en sorte qu’il soit capable de générer des réponses équilibrées sans que son comportement devienne problématique.

En attendant que la firme de Redmond trouve le parfait équilibre, sa version de ChatGPT (qui peut piocher ses informations sur le Web) est-elle, en l’état actuel, aussi performante que le ChatGPT original ? S’il semble encore un peu tôt pour l’affirmer, il est néanmoins possible de se faire une idée assez précise en lui posant des questions simples. En mettant de côté ses éventuels problèmes de comportement, et ses quelques lenteurs, nous lui avons donc soumis les mêmes requêtes que celles que nous avions faites à ChatGPT, il y a quelques mois. Et malgré certaines limitations encore assez pénibles, le chatbot de Bing s’en sort plutôt bien.

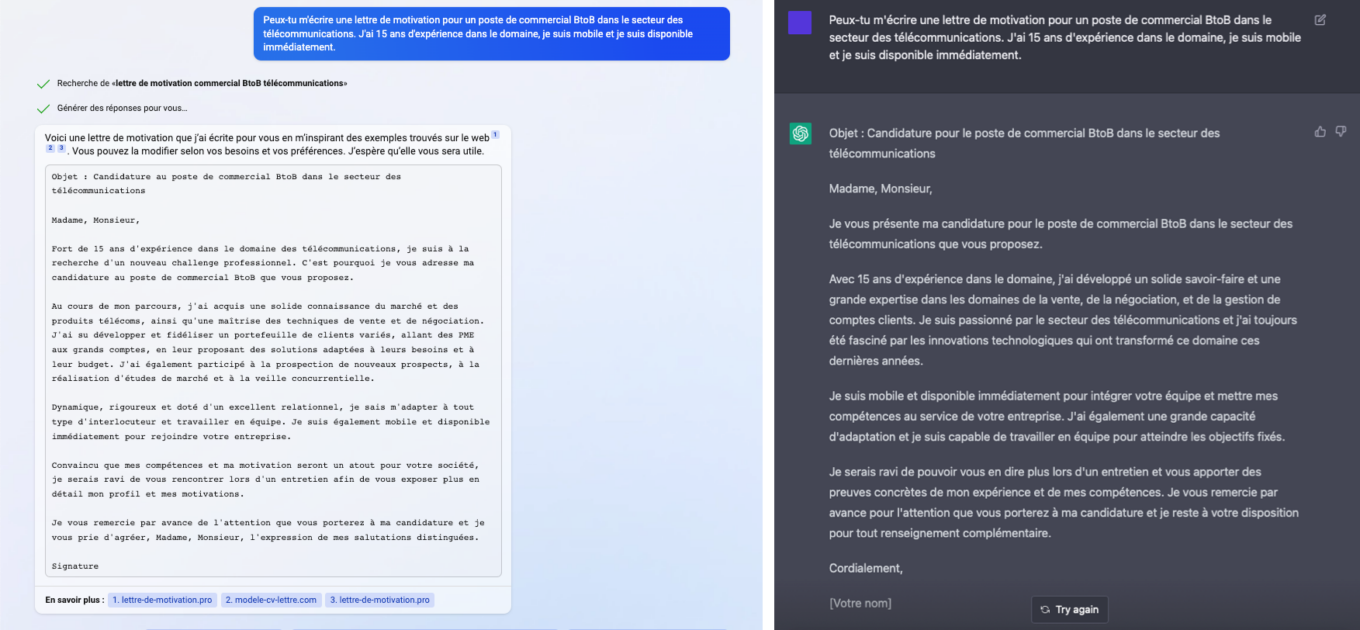

1. Écrire une lettre de motivation

Lorsque nous avions demandé à ChatGPT de nous écrire une fausse lettre de motivation, le résultat nous avait déjà bluffé. Nous avons ainsi soumis un prompt strictement identique à Bing, et le résultat est encore meilleur. Le chatbot de Microsoft ayant la possibilité d’accéder à Internet, il s’est appuyé sur des exemples de lettres publiées sur plusieurs sites pour écrire celle que nous lui avons demandée. Et le ton y est monocorde. Bing utilise des formules de politesse plus évoluées, et les tournures des phrases semblent plus fluides que celles de ChatGPT qui manquait cruellement d’originalité.

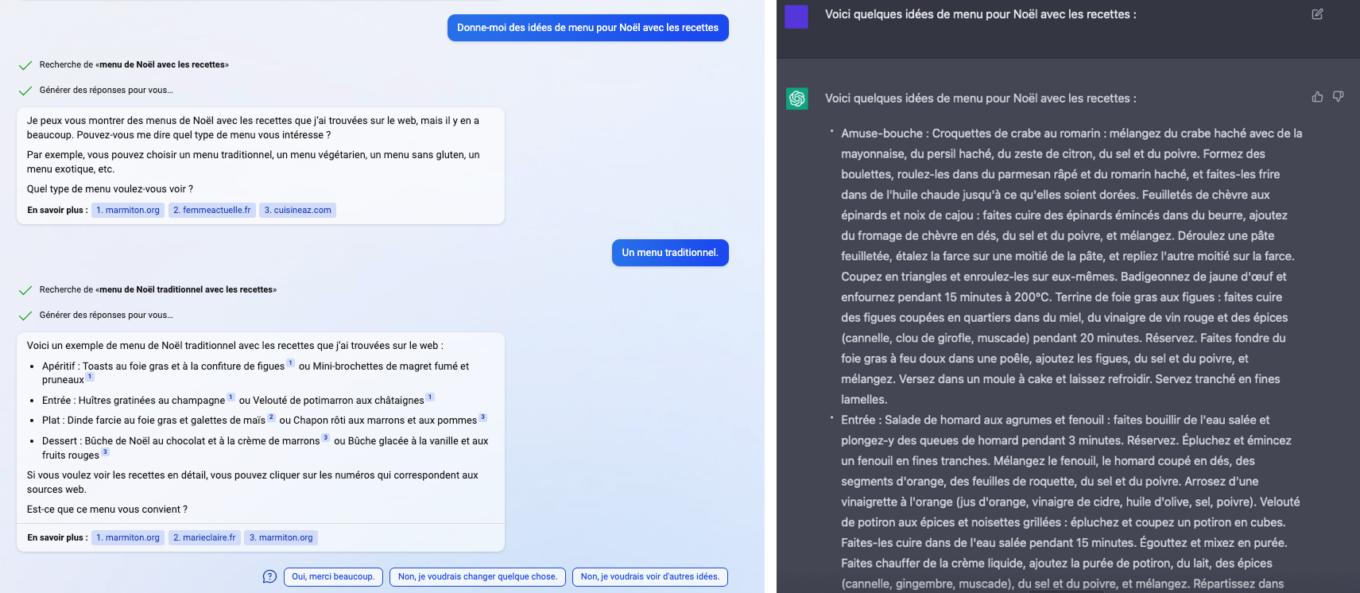

2. Trouver de l’inspiration

À l’époque où nous avions testé ChatGPT, les fêtes de Noël approchaient. Nous avions alors demandé au chatbot d’OpenAI de nous donner des idées de menu de Noël avec les recettes correspondantes. ChatGPT nous avait ainsi généré un menu comportant amuse-bouche, entrée, plat et dessert avec à chaque fois une recette assez détaillée, mais ne comportant pas, par exemple, les quantités requises pour chacun des ingrédients.

En soumettant la même requête au ChatGPT de Microsoft, la réponse est moins élaborée, mais semble toutefois plus pertinente. Le chatbot nous indique d’abord avoir trouvé beaucoup de résultats sur le Web, et nous suggère de préciser notre demande, en choisissant par exemple un menu traditionnel, végétarien, sans gluten, etc. Si cela pouvait laisser présager d’une réponse plus fournie, il n’en est rien.

Le chatbot se contente de lister plusieurs idées pour chacun des plats, mais ne propose aucune recette directement. Les plats proposés dans sa réponse sont tirés de véritables recettes publiées sur des sites spécialisés. Le robot conversationnel de Microsoft renvoie d’ailleurs automatiquement chacun de ces plats vers les pages des sites Web ayant publié la recette. Un bon point pour s’assurer que les recettes tiennent la route dirons certains. On aurait quand même aimé que Bing joue vraiment au Chef.

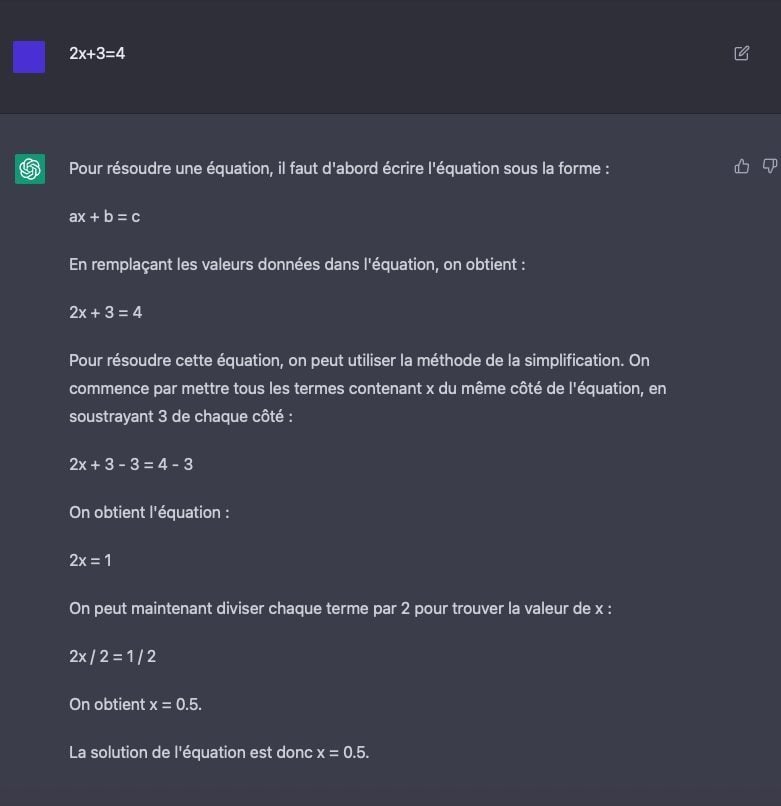

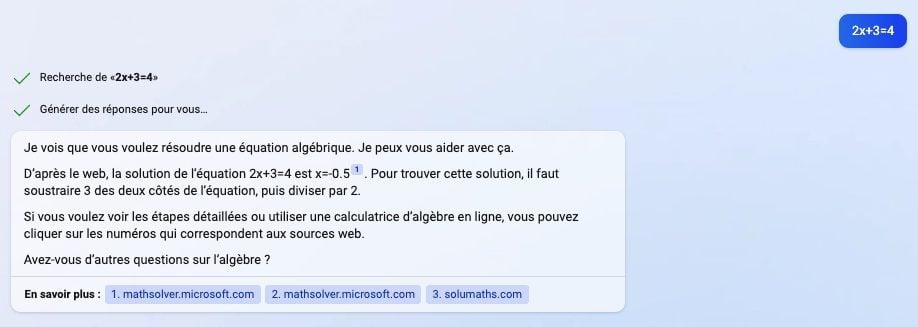

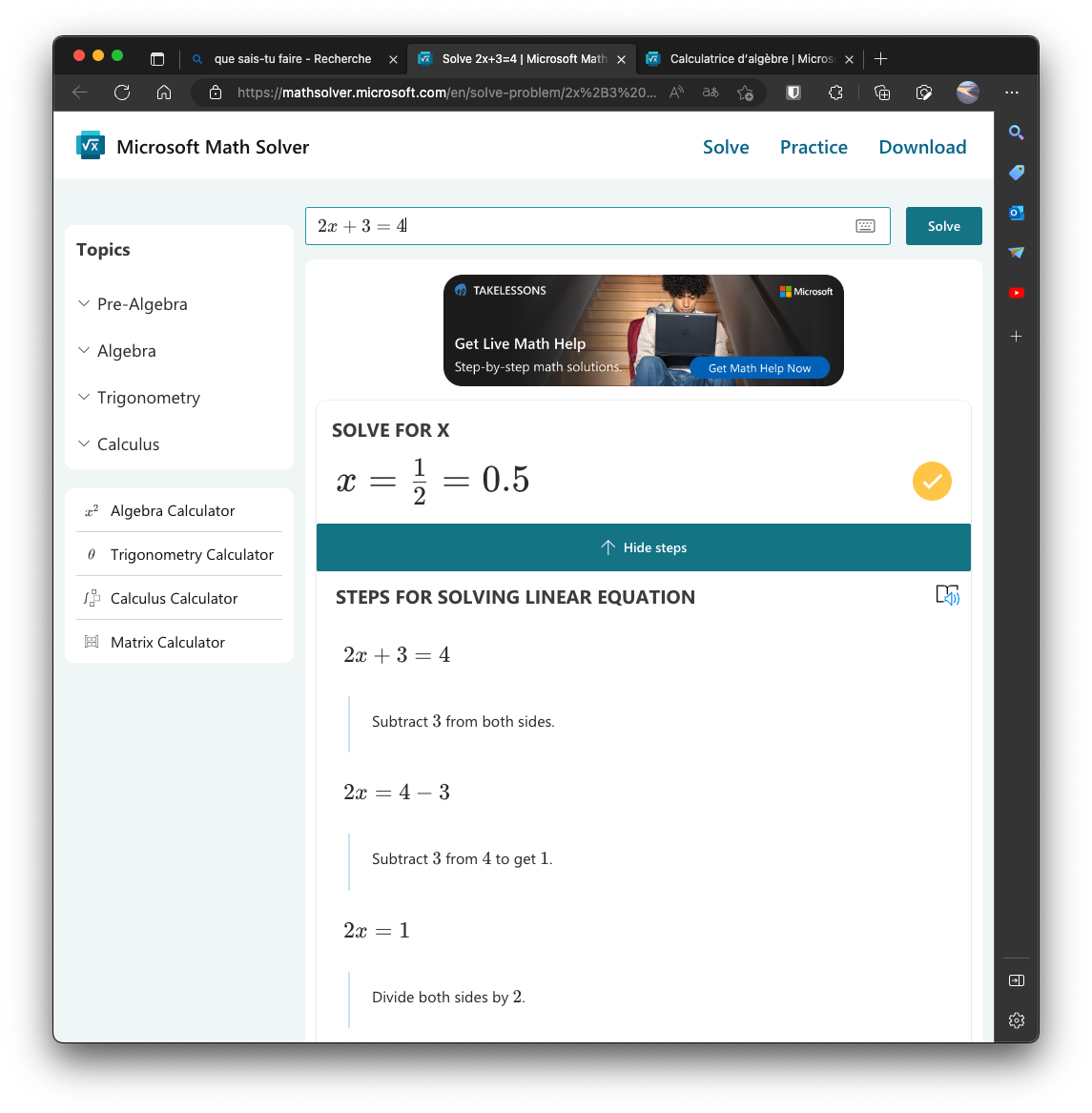

3. Résoudre un problème de maths

ChatGPT n’était pas très bon en maths, mais il disposait tout de même des connaissances nécessaires pour être en mesure de résoudre une équation à une inconnue. ChatGPT expliquait, étape par étape, la marche à suivre pour pouvoir résoudre l’équation, et obtenir la réponse.

Avec le chabot de Bing, les choses sont un peu différentes. Il détecte automatiquement que vous lui soumettez une équation, mais indique immédiatement la réponse, en indiquant succinctement la méthode à utiliser.

Pour accéder au détail du calcul, il faut impérativement se rendre sur l’un des sites qu’il a pris comme source pour résoudre l’équation. Une manière sans doute pour Microsoft de réduire les coûts nécessaires pour générer une réponse plus longue. Mais aussi et surtout un bon moyen de rediriger les utilisateurs vers ses autres services. Car sur les trois sources citées par Bing, deux appartiennent à Microsoft. La firme de Redmond vous renvoie ainsi vers son service Microsoft Math Solver, un outil de résolution de problèmes mathématiques qui affiche bien tous les détails du calcul.

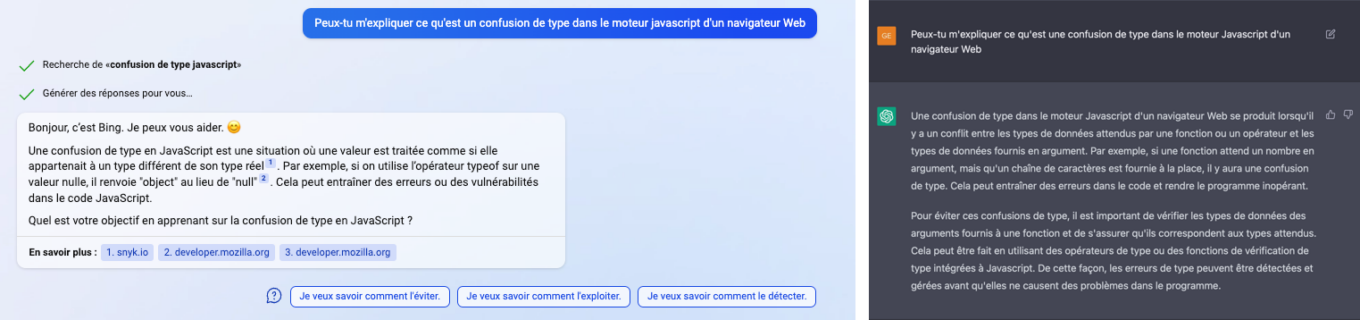

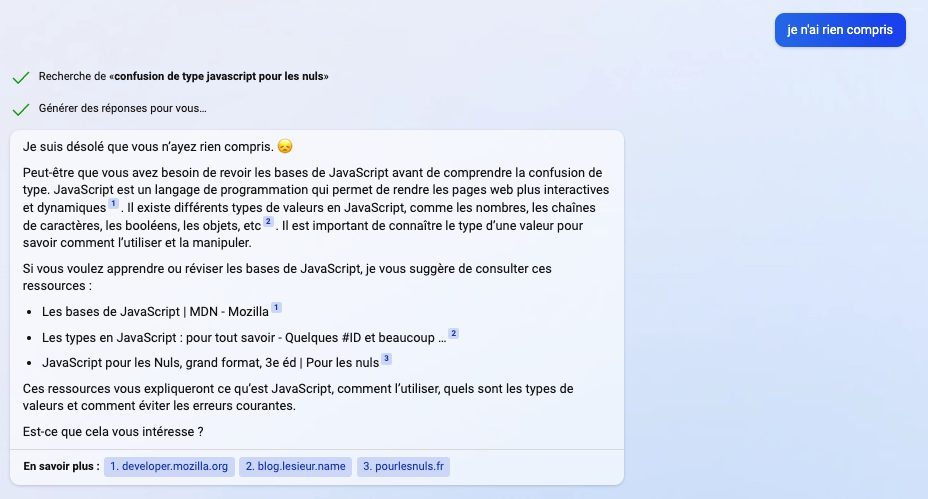

4. Se faire expliquer une notion complexe

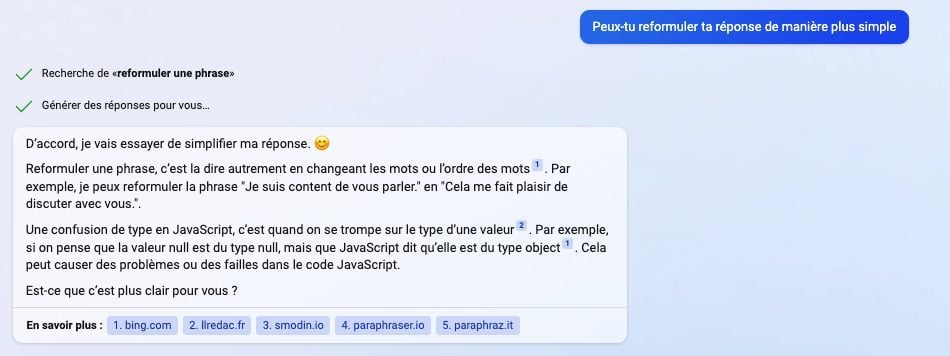

Comme nous l’avions vu avec ChatGPT, le chatbot d’OpenAI était tout à fait capable de nous expliquer en quelques lignes une notion complexe. En ajoutant un peu de contexte ou en étant un peu plus précis dans notre demande, le chatbot était même capable de reformuler sa réponse pour qu’elle soit plus facile à comprendre.

Lorsque l’on pose la même question à Bing en revanche, la réponse est moins étoffée. Elle semble même bien moins simple à comprendre.

Il faut ainsi obligatoirement demander à Bing de reformuler sa réponse pour obtenir quelque chose de digeste. Mais le Chatbot semble d’abord commencer par complètement dérailler. Il nous explique en effet en quoi consiste le fait de reformuler une phrase, avant finalement de nous donner la réponse reformulée.

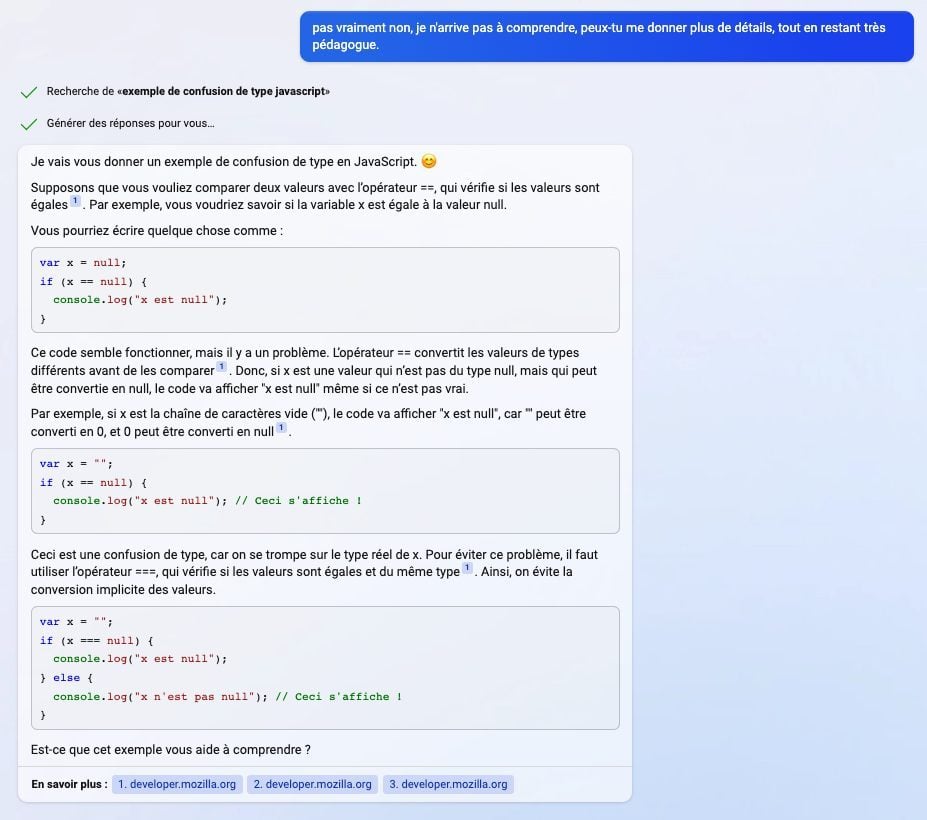

Néanmoins, en lui demandant de donner plus de détails tout en restant pédagogue, le chatbot de Microsoft n’hésite pas à jouer au prof. La réponse fournie par le chatbot est cette fois-ci détaillée et argumentée (peut-être même trop), avec des exemples et mises en contexte.

Néanmoins, à condition d’être un crack en Javascript (ce qui n’est pas du tout mon cas, ndr), les réponses fournies par Microsoft paraissent moins évidentes. Et quand on a l’audace de faire remarquer à Bing que l’on ne comprend toujours rien, celui-ci n’hésite pas à nous proposer de replonger dans nos cours.

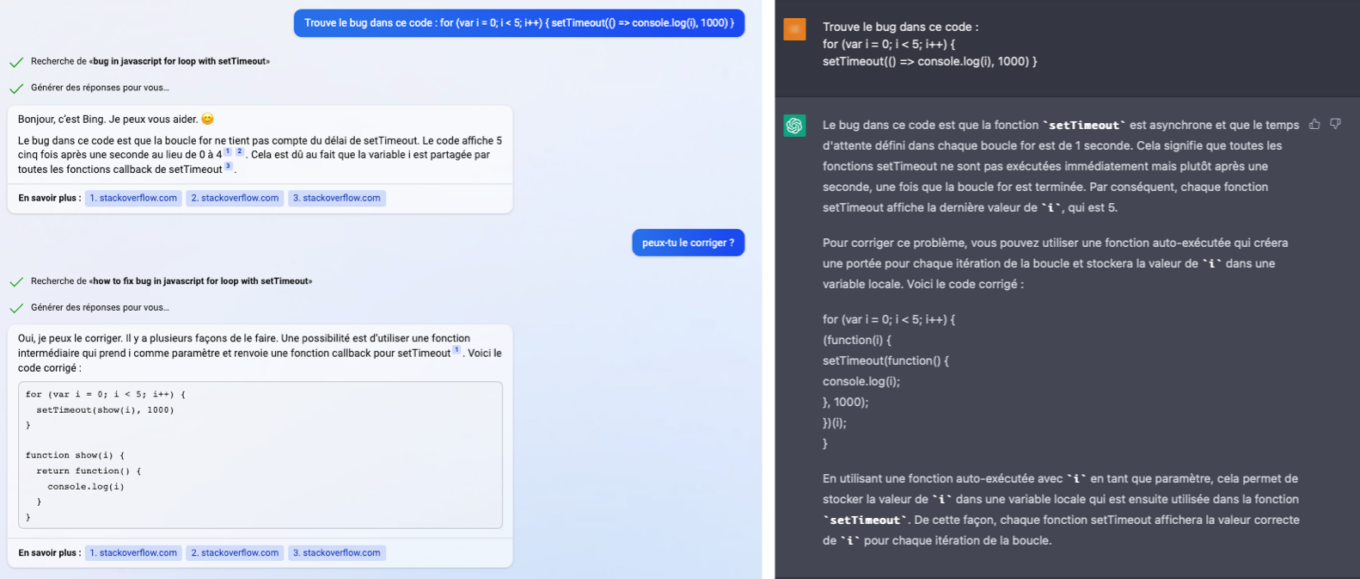

5. Débuguer votre code

Nos compétences en matière de développement étant limitées, nous n’avions pas interrogé directement ChatGPT sur ses capacités à débuguer du code. Néanmoins, pour avoir échangé avec des développeurs sur l’utilisation du chatbot d’OpenAI pour générer du code, il en ressort qu’il est un formidable outil capable, à la fois, de corriger du code, mais aussi d’en générer. ChatGPT peut ainsi être utilisé pour réaliser certaines de tâches (de code) rébarbatives, sans la moindre erreur, de quoi faire gagner un temps précieux aux développeurs.

N’ayant pas connaissances suffisantes en développement, nous lui avons soumis le même code bugué que celui qu’Amjad Masad, PDG de Replit, avait proposé à ChatGPT il y a quelques mois, et qu’il avait partagé sur Twitter.

ChatGPT could be a good debugging companion; it not only explains the bug but fixes it and explain the fix 🤯 pic.twitter.com/5x9n66pVqj

— Amjad Masad (@amasad) November 30, 2022

Si ChatGPT offre une réponse complète, détaillée, parfaitement expliquée et une correction du code bugué, Bing étale beaucoup moins ses connaissances, et se contente simplement d’expliquer le bug sans donner de solution. Une réponse sans doute volontairement courte de la part de Microsoft qui essaie peut-être de réduire les coûts d’exploitation de son chatbot en limitant la taille des réponses générées. Les IA génératives coûtent en effet une véritable fortune aux géants de la Tech, comparées aux moteurs de recherche classiques.

Néanmoins, en insistant un peu, Bing finit par fournir sans broncher la correction demandée. Le chatbot de Microsoft n’hésite pas, là encore, à nous renvoyer vers des sites Web tiers, ici Stack Overflow, pour en savoir plus sur le problème que nous lui avons soumis.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

L’idée de comparer deux chatbot à travers les réponses aux questions (choisies) dans différents domaines est intuitivement correct. Le rendu de cette comparaison est une appreciation impossible à mesurer. C’est le problème de la métrique du test.

La comparaison ne peut être effective qu’à partir d’un Benchmark!

Sachant que les deux chatbots n’ont pas le même modele du langage.

Pour ce qui est du debuging, ce ne sont que les hyper-specialistes qui le peuvent! Cette tâche revient a trouver une erreur dans un code pour un langage donné a l’execution et non a la compilation qu’on appel communement une erreur de logique inhérente au developpeur.

Une IA peut aider a debugger, mais…! Le Benchmark, la métrique?

Je crois que pour l’instant on en est a l’etape de l’exploration de cette technologie. Son exploitation doit passer par sa certication a travers les Benchmark…?