On pourrait croire à une déclaration de guerre : Nvidia, roi du GPU, en lice pour racheter ARM, vient d’annoncer un processeur. De quoi menacer Intel et AMD ? Non… Enfin, pas tout de suite.

« C’est un processeur conçu pour un usage bien précis », a expliqué Paresh Kharya, directeur senior au sein Nvidia, « pas un concurrent des processeurs x86 ». Son entreprise entend bien continuer de travailler avec AMD et Intel pour placer ses puces aux côtés de leurs déclinaisons de l’architecture x86.

Une puce pour répondre à un problème croissant

Mais alors, quelle est l’ambition de ce processeur, baptisé Grace en hommage à Grace Hopper, informaticienne de génie qui créa le COBOL et le premier compilateur au début des années 50 ?

Grace est le premier processeur destiné aux data centers de Nvidia. Il est conçu pour accélérer les calculs des algorithmes d’intelligence artificielle. La société de Santa Clara annonce qu’il offre « dix fois les performances des serveurs actuels les plus performants dans ce domaine ».

Une puce qui a donc pour ambition d’améliorer l’exécution des algorithmes de langage naturel, les systèmes de recommandations intelligents ou les supercalculateurs d’IA. Autant de machines qui doivent gérer d’énormes ensembles de données, qui requièrent à la fois une grosse puissance de calcul et une énorme quantité de mémoire vive associée.

A découvrir aussi en vidéo :

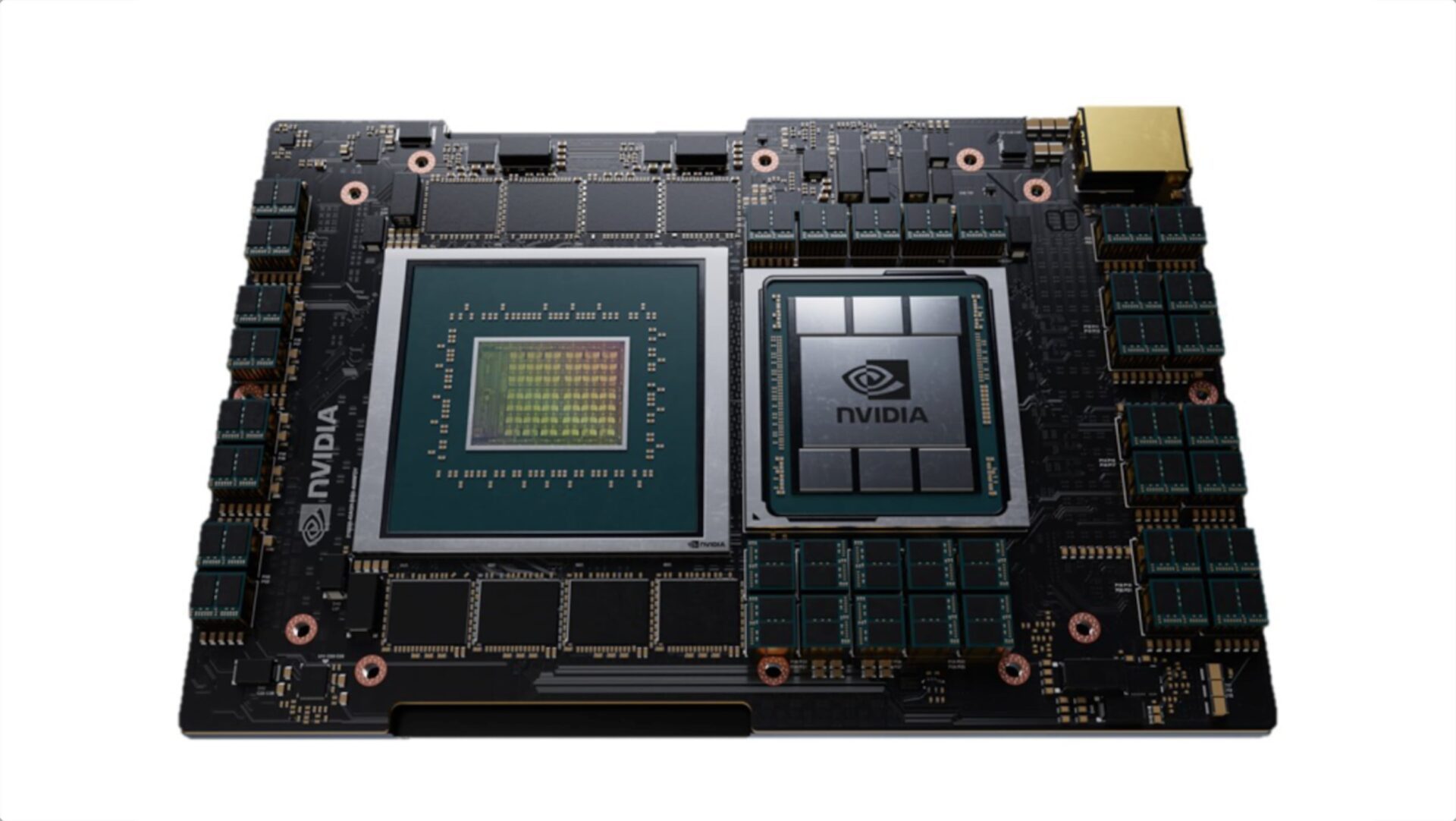

Au cœur de Grace, Nvidia a glissé une architecture ARM, un choix qui a été évidemment arrêté bien avant le lancement de l’option de rachat de la structure anglaise. Les cœurs CPU ARM sont combinés avec un sous-système mémoire basse consommation, afin de trouver le meilleur équilibre entre consommation électrique et performances, avance Nvidia.

Cette approche répond à un véritable enjeu actuel du monde de l’IA : « réussir à faire tourner des modèles de plus en plus gros », a mis en perspective Paresh Kharya : « Là où un modèle de langage comme ELMo comptait environ 94 millions de paramètres en 2018, GPT-3, l’actuel star du domaine, en totalise plus de 175… milliards ».

Le représentant de Nvidia nous a expliqué, lors d’une présentation anticipée du processeur, qu’on assiste à un doublement du nombre de paramètres tous les deux mois et demi. « Les modèles d’IA intégrant des milliers de milliards de critères sont donc tout proches », a-t-il conclu.

Tout repenser pour contourner un goulet d’étranglement

Nvidia est évidemment le grand zélateur du rôle central des GPU dans le domaine de l’intelligence artificielle. Un monde dans lequel, jusqu’à présent, des processeurs Intel ou AMD surpuissants cohabitent avec des GPU Nvidia.

Or, avec les architectures de calcul actuelles, les chercheurs de Nvidia ont constaté qu’il y a un goulet d’étranglement (à 64 Go/s, tout de même) au niveau de l’accès à la mémoire du processeur par les puces graphiques en charge des calculs parallèles.

Nvidia a donc décidé de rebattre les cartes en utilisant plusieurs de ses technologies. Tout d’abord, ses ingénieurs ont adapté sa technologie NVLink pour aboutir à une bande passante de 900 Go/s entre le CPU et le GPU – autrement dit, c’est un x14 par rapport à ce qui existait jusqu’à présent.

Ensuite, Nvidia a accru la bande passante de la mémoire (LPDDR5 EEC) pour atteindre les 500 Go/s. « Deux fois plus de bande passante, pour 10 fois moins de consommation d’électricité par rapport à de la DDR4 », promet Paresh Kharya.

Il s’agit en fait d’une nouvelle architecture qui fournit une cohérence de cache unifié avec un seul espace d’adressage mémoire. Elle combine la mémoire système et la mémoire HBM des puces graphiques

Enfin, là où on trouvait le couple GPU Nvidia et puces x86, on trouvera désormais, en lieu et place d’un processeur Intel ou AMD, une puce Neoverse, les modèles de processeurs ARM développés pour les serveurs, de nouvelle génération. Nvidia n’est donc pas en guerre contre Intel ou AMD, mais il essaie de se passer d’eux quand il le peut…

Cette nouvelle génération Neoverse ne devrait pas être disponible avant 2023, date de disponibilité de ce premier processeur pour IA de Nvidia.

Grace en Suisse et au Nouveau Mexique

Grace a déjà trouvé deux preneurs. Elle sera au cœur d’un nouveau supercalculateur pour l’intelligence artificielle, baptisé ALPS, qui a été commandé par le CSCS, le Centre national suisse de calcul scientifique. Il sera capable de produire 20 Exaflops de calculs IA. Ce qui lui permettra d’entraîner des modèles GPT-3 en deux ou trois jours là où il faut actuellement plusieurs mois.

Pour arriver à de telles performances, ALPS comptera non seulement sur Grace, mais également sur « un GPU Nvidia qui n’a pas encore été annoncé », nous a précisé Paresh Kharya.

L’autre candidat à être touché par la Grace sera le Laboratoire national de Los Alamos, dans le Nouveau-Mexique, aux États-Unis. Multidisciplinaire, ce centre de recherche est notamment connu pour avoir été le berceau du Projet Manhattan pendant la seconde guerre mondiale.

Car Grace est taillé pour l’IA et les HPC (ces bêtes de calcul intensif). Il devra dès lors se frotter à de nombreux domaines, comme l’économie, la biologie, mais aussi… l’informatique quantique.

Grâce à sa puissance, à sa gestion innovante de la mémoire, Grace devrait en effet permettre de doper un pan essentiel de ce futur de l’informatique auquel Nvidia s’attaque dès maintenant : « la simulation des circuits quantiques », selon Paresh Kharya.

Un nouvel outil, développé par Nvidia et baptisé CuQuantum, devrait faciliter l’utilisation des GPU de Nvidia pour simuler le fonctionnement des composants quantiques, et donc réussir à produire des machines quantiques plus performantes.

Loin de nos cartes graphiques (frappées par la pénurie) et de nos PC de joueurs, Nvidia continue de dessiner le futur avec ses puces. Il y ajoute des éléments provenant des banques d’IP d’ARM. Un cheminement entamé avant la procédure de rachat, même si chaque nouvelle annonce de la société de Santa Clara semble valider ce rapprochement stratégique.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.