Ces derniers mois, ce sont surtout les LLM (Large Language Model) qui ont été sur le devant de la scène, avec en guise de têtes d’affiche des solutions comme ChatGPT ou Gemini. Néanmoins, ces mastodontes ont un défaut : leur gigantisme justement, avec un très grand nombre de paramètres ; une gageure pour les gérer en local. Ainsi, à l’ombre de ses géants, des modèles de langage pour IA plus modestes se développent ; ils sont logiquement appelés SLM, pour Small Language Models. Parmi ces jeunes pousses, nous retrouves des espèces telles que Gemma 2B et 7B de Google, le Claude 3 Haiku d’Anthropic ou encore Llama 3 8B de Meta. Microsoft vient d’en fait éclore une nouvelle : Phi-3 Mini.

Phi-3 Mini, premier représentant d’un trio

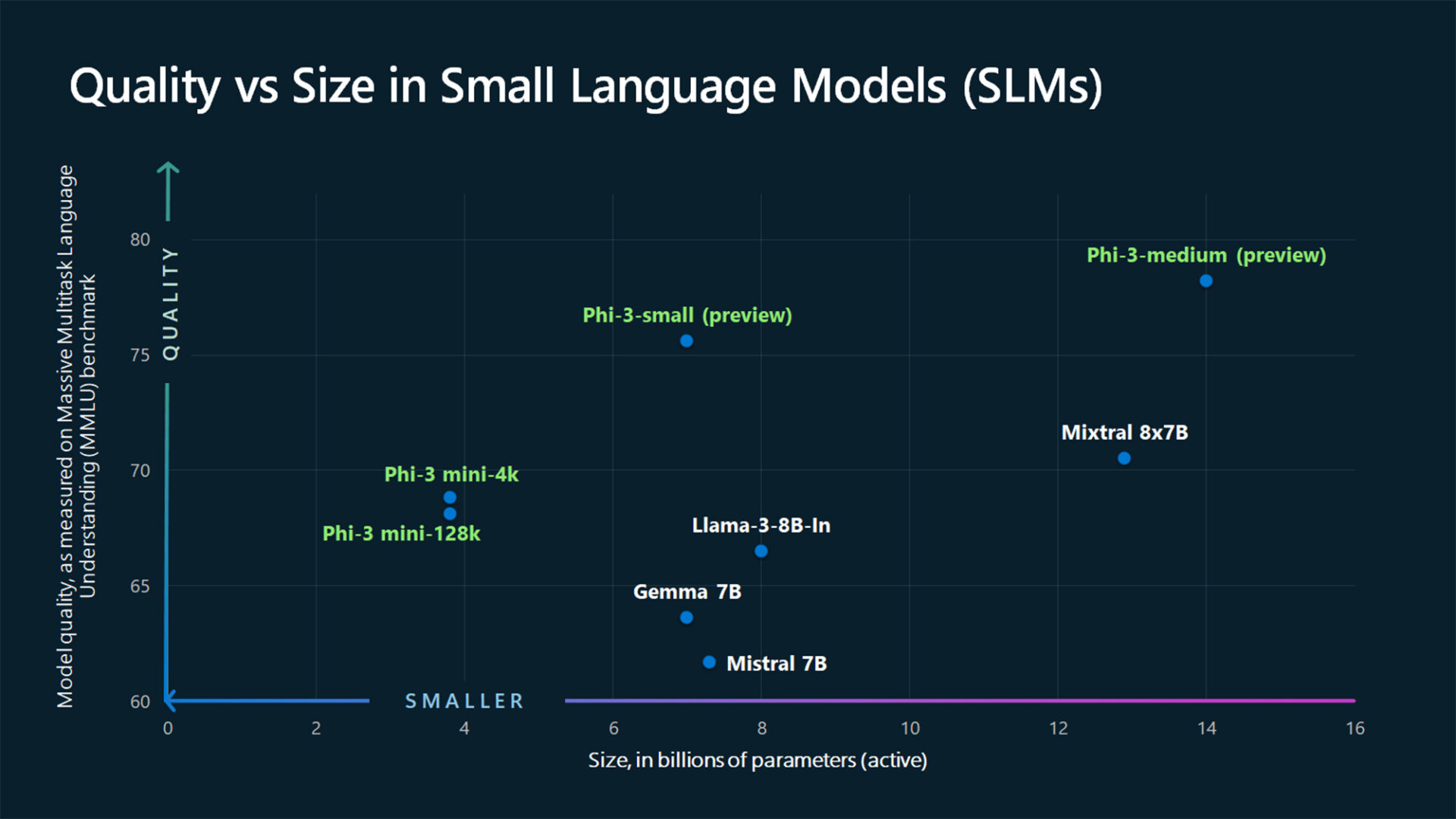

Phi-3 Mini est le premier représentant mis à la disposition du public d’un chapelet de trois graines ; les deux autres, attendues dans les prochains mois, sont Phi-3 Small et Phi-3 Medium. En matière de nombre paramètres, ces modèles nécessitent des terreaux de respectivement 3,8 milliards, 7 milliards et 14 milliards. En outre, vous l’aurez compris avec le chiffre 3, il y a eu des précédents : Phi-1 et Phi-2, ce dernier ayant fait ses débuts en décembre dernier.

En dépit de sa petite taille, Phi-3 Mini n’est pas inefficace pour autant. Microsoft allègue qu’il offre des performances supérieures à celles de modèles deux fois plus grands. Dans une déclaration adressée à nos confrères de TheVerge, Eric Boyd, vice-président de Microsoft Azure AI Platform, ajoute que « Phi-3 Mini est aussi performant que des LLM comme GPT-3.5 mais dans un format plus petit ».

Un SLM entraîné à l’aide d’un LLM

Vous vous en doutez, pour qu’un modèle SLM soit performant, il faut qu’il ait été très bien entraîné. Tandis que les LLM le sont via une quantité massive de données récoltées sur Internet, pour un SML, une telle moisson n’est pas pertinente. En conséquence, les équipes de Microsoft ont adopté une approche différente pour former Phi-3 Mini. « Au lieu de s’entraîner sur des données web brutes, pourquoi ne pas rechercher des données de très haute qualité ? », résume Sébastien Bubeck, vice-président de Microsoft chargé de la recherche sur l’IA générative.

Toutefois, comme le précise la société, si « distinguer les informations de haute qualité de celles de faible qualité n’est pas difficile pour un humain » (une assertion discutable), ça l’est nettement plus pour un modèle de langage, qui, jusqu’à preuve du contraire, n’est qu’un aspirateur à données sans aucune capacité de raisonnement. Ceci dit, pour effectuer le tri préalable ainsi que la sélection d’informations pertinentes, Microsoft a eu recours à un LLM. Un entraîner d’un nouveau genre qui explique, aux dires de la société, l’excellence de Phi-3 Mini.

« La puissance de la génération actuelle de grands modèles de langage est vraiment un outil que nous n’avions pas auparavant en termes de génération de données synthétiques », souligne Ece Kamar, qui dirige le Microsoft Research AI Frontiers Lab. Au fond, nous retrouvons ainsi un peu l’image d’Épinal du maître et de l’élève, le premier distillant une partie de son savoir au second.

Dans les faits, les petits modèles d’IA sont moins chers à faire fonctionner que les grands, et surtout, facilitent – en l’état actuel du hardware – l’usage local.

Une spécificité explicitée ainsi par Microsoft : l’entreprise écrit qu’en raison de la capacité des SLM à fonctionner hors ligne, un plus grand nombre de personnes seront en mesure d’utiliser l’IA d’une manière qui n’était pas possible jusqu’à présent. Et si à l’ère du tout connecté, solliciter un chatbot surpuissant via des serveurs ne semble pas insurmontable, c’est en fait une remarque de citadin résident dans un pays à l’infrastructure réseau relativement bien développé : la firme de Redmond évoque simplement le cas de zones rurales dépourvues de services cellulaires ; plus précisément, l’exemple d’un agriculteur qui, inspectant ses cultures et trouvant des signes de maladie sur une feuille ou une branche, serait en mesure d’avoir recours à un SLM doté d’une capacité visuelle afin de prendre une photo de la culture en question et ainsi obtenir des recommandations immédiates sur la manière de traiter les parasites ou les maladies – diagnostic et thérapie vraisemblablement dictés directement par Bayer, mais c’est un autre débat.

Luis Vargas, vice-président de l’IA chez Microsoft, nous dépeint ainsi un monde idéal dans lequel « si vous vous trouvez dans une région du monde qui ne dispose pas d’un bon réseau, vous pourrez quand même bénéficier d’expériences d’IA sur votre appareil » ; ce, grâce aux SLM. Ô joie !

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Microsoft