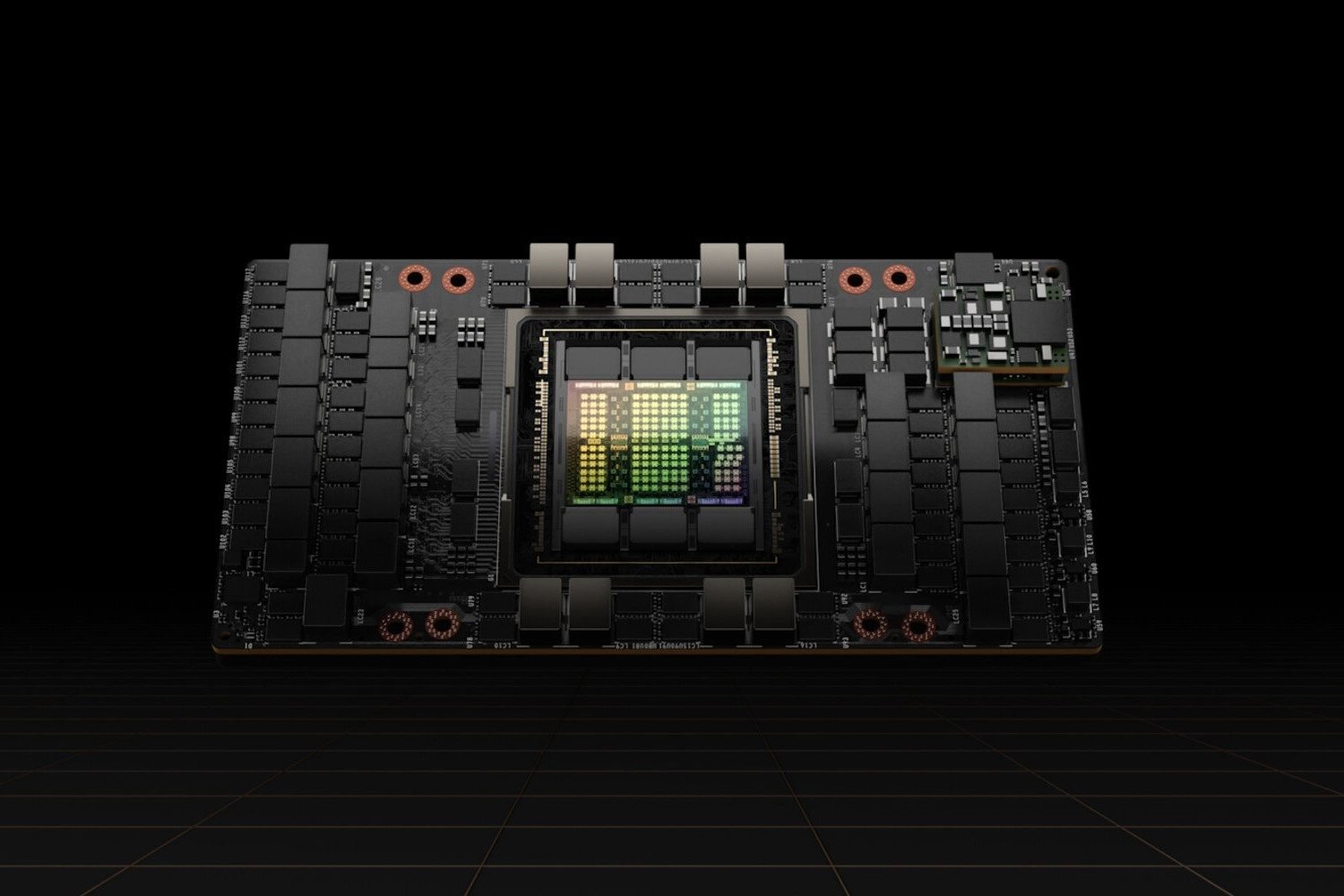

Grâce à l’engouement autour de l’intelligence artificielle, la demande en produits NVIDIA ne cesse de croître. L’entreprise dirigée par Jensen Huang est désormais devant Amazon en bourse. Elle a créé l’évènement en milieu de semaine avec la publication de ses résultats financiers ; établi un nouveau record à Wall Street hier, avec une hausse de 277 milliards de sa valorisation en une journée. Les moteurs de cette croissance ne sont pas les cartes graphiques GeForce, mais bien les cGPU pour les centres de données tels que le H100. Pour sa prochaine génération, Blackwell, NVIDIA s’attend à une demande bien supérieure à l’offre.

L’IA, moteur de NVIDIA

À l’occasion de la publication des résultats de l’entreprise, Colette Kress, sa directrice financière, a déclaré aux investisseurs : « Nous nous attendons à ce que nos produits de nouvelle génération soient soumis à des contraintes d’approvisionnement, car la demande dépasse largement l’offre ».

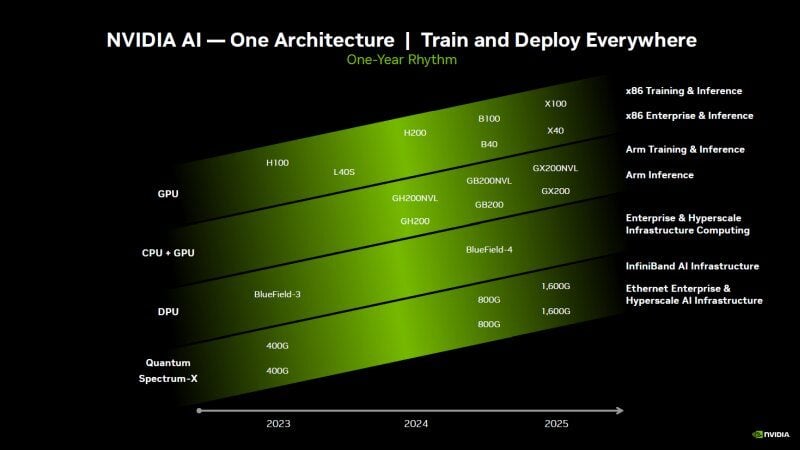

Par prochaine génération, Colette Kress entend Blackwell, l’architecture qui succédera à Hopper. Hopper a abouti à des produits comme le H100 ou plus récemment le H200. Cette architecture est cantonnée aux serveurs ; les GeForce RTX 40 Series exploitent pour leur part l’architecture Ada Lovelace.

Selon la feuille de route de la société, les premières solutions Blackwell sont prévues avant 2025. Forcément, d’ici là, l’emballement autour de l’intelligence artificielle ne se sera vraisemblablement pas tassé…

De fait, la demande surpassait déjà l’offre pour les H100. Un récent rapport d’analystes du cabinet UBS indique que le délai de livraison pour le GPU H100 80 Go est maintenant de trois ou quatre mois, alors que l’attente avoisinait plutôt les neuf ou dix mois en 2023. Les restrictions à l’export des H100 et H800 dans certains pays comme la Chine n’y sont peut-être pas étrangères, bien que l’approvisionnement ne soit pas totalement coupé en pratique.

Une offre forcément limitée au départ

Les puces Blackwell semblent bien parties pour améliorer encore les performances dans les charges de travail IA. En matière de conception, Blackwell inaugurerait le MCM (Multi-chip module) chez NVIDIA. Cette caractéristique permettra de maximiser les rendements au niveau du silicium par rapport à un GPU monolithique, donc d’augmenter la productivité, bien que l’emballage de solutions MCM soit aussi plus complexe, donc plus risqué.

Dans tous les cas, comme le souligne Jensen Huang, le lancement d’un nouveau produit implique une production croissante, mais linéaire. En cas de forte demande, il faut obligatoirement un délai pour satisfaire tous les clients (certes, sauf à accumuler des stocks pendant des mois avant le lancement, mais c’est une pratique totalement absurde pour une entreprise).

« Chaque fois que nous avons de nouveaux produits, comme vous le savez, nous passons de zéro à un très grand nombre, ce qui ne peut se faire du jour au lendemain. […] en ce moment, nous sommes en train de produire le H200, il n’y a aucune solution miracle pour répondre à la demande à court terme au cours de cette montée en puissance de la production ».

Bref, les clients de NVIDIA sont prévenus : pour espérer avoir la primeur, ils doivent sécuriser leurs commandes dès maintenant.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : NVIDIA via SeekingAlpha

La faute a Nvidia et AMD qui spécule sur la stupidité des acheteurs prêt a payer 3000 Euros a cause du prix insolent des GPU… La preuve, EVGA a arrêté définitivement la fabrication de carte graphique a cause de la guerre exagérée que Nvidia et AMD pratique….