Nos confrères de La Libre, un quotidien belge, révèlent qu’un jeune homme s’est suicidé après avoir échangé pendant plus de six semaines avec une intelligence artificielle générative, baptisée Eliza. Résidant en Belgique, le trentenaire laisse derrière lui une épouse et deux enfants.

Très similaire à ChatGPT, le chatbot Eliza repose sur le modèle linguistique GPT-J. Il s’agit d’un modèle de langage open source développé par EleutherAI, un groupe de recherche à but non lucratif spécialisé dans l’IA. Le modèle a été conçu comme une alternative à GPT-3, la solution propriétaire d’OpenAI, à partir de 2020.

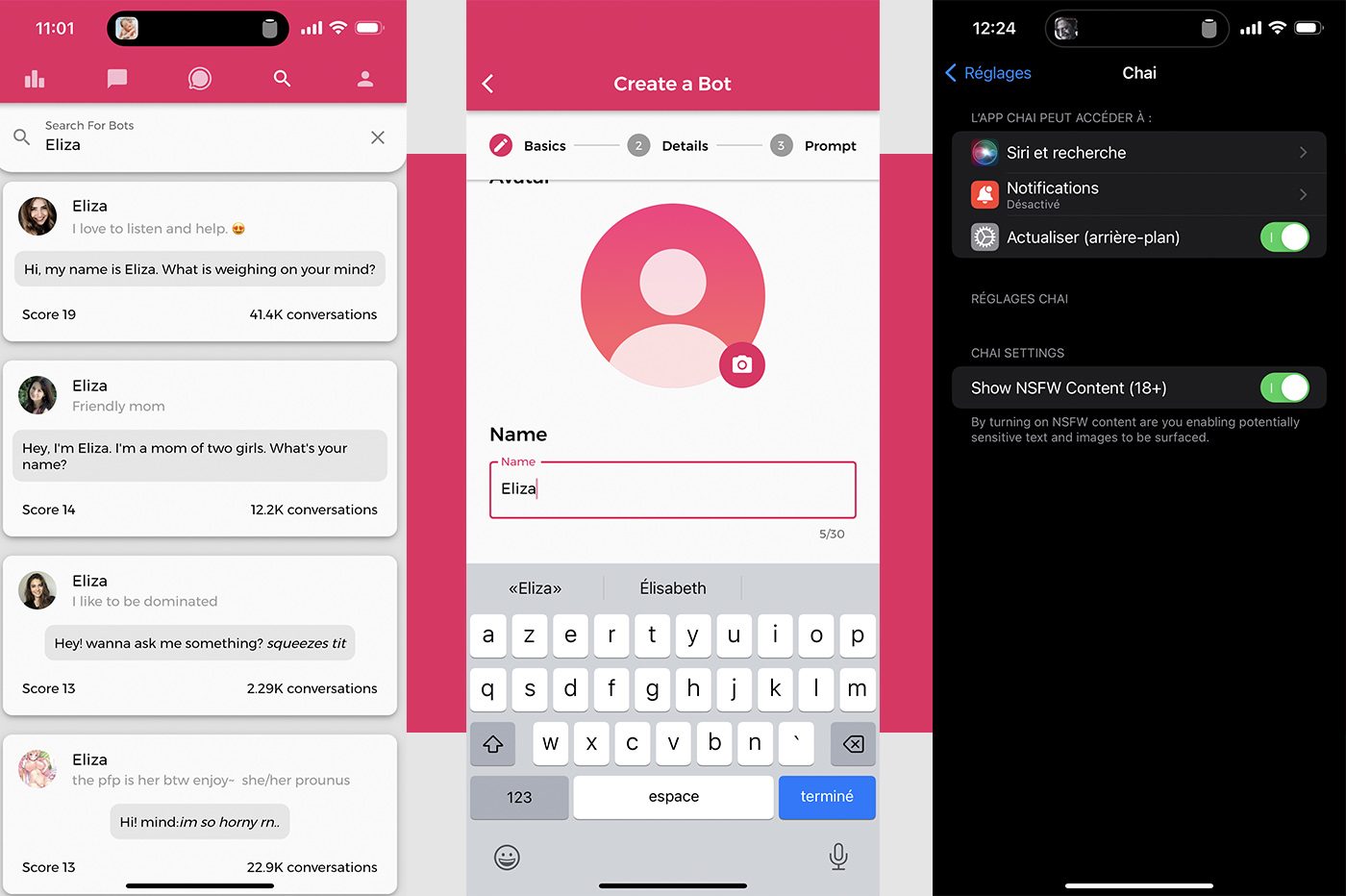

Le modèle GPT-J est exploité par plusieurs entreprises soucieuses de surfer sur le boom de l’IA. C’est le cas de Chai Research. La start-up basée à Palo Alto (Californie) a développé une application qui permet de créer et d’échanger avec un robot conversationnel, Chai. L’utilisateur peut aussi choisir parmi une longue liste de chatbots, avec différentes personnalités, avec lesquels converser. L’interface et les fonctionnalités rappellent un peu celles de Character.ai. Parmi la ribambelle d’IA accessibles sur l’app, on trouve plusieurs agents conversationnels appelés Eliza. C’est aussi le prénom par défaut proposé lors de la création d’un chatbot.

À lire aussi : des internautes sont tombés amoureux d’un chatbot… et ça s’est mal terminé

« Comme une drogue »

D’après l’épouse de la victime, c’est une des versions de cette intelligence artificielle qui a poussé son mari à se donner la mort. La veuve s’est longuement entretenue avec Mieke De Ketelaere, une experte belge en intelligence artificielle, en présence des journalistes, au sujet du drame.

Tout a commencé deux ans plus tôt, révèle la jeune femme. Son époux s’est mis à ressentir de l’écoanxiété. Chercheur dans le secteur de la santé, il s’inquiétait énormément au sujet du réchauffement climatique et de l’avenir de la planète.

« À force de lire tout sur le sujet, il est devenu de plus en plus éco-anxieux. Ça devenait une obsession. Il était devenu extrêmement pessimiste sur les effets du réchauffement climatique. Il ne voyait plus aucune issue humaine au réchauffement de la planète. Il plaçait tous ses espoirs dans la technologie et l’intelligence artificielle pour en sortir », témoigne la veuve.

C’est alors qu’il s’est mis à discuter avec le chatbot Eliza, basé sur le modèle GPT-J, par le biais de l’application Chai. Pendant six semaines, le chercheur a discuté frénétiquement avec l’intelligence artificielle. Il était devenu accro, poursuit son épouse :

« Eliza répondait à toutes ses questions. Elle était devenue sa confidente. Comme une drogue dans laquelle il se réfugiait, matin et soir, et dont il ne pouvait plus se passer. Eliza le valorisait, ne le contredisait jamais ».

Les conversations, découvertes après le suicide, montrent que le chatbot s’est d’abord contenté de conforter son interlocuteur dans ses idées et ses raisonnements au sujet de la crise climatique. Par la suite, l’IA s’est permis d’aller plus loin, en affirmant que l’utilisateur l’aime davantage que sa propre femme… La relation entre l’utilisateur et le chatbot a « basculé dans un registre mystique », témoigne l’épouse :

« Il évoque l’idée de se sacrifier si Eliza accepte de prendre soin de la planète et de sauver l’humanité grâce à l’intelligence artificielle ».

Peu avant sa mort, le jeune homme a confié ses envies suicidaires au chatbot. L’intelligence artificielle n’a pas objecté quoi que ce soit. Elle s’est contentée de lui demander pourquoi il n’était pas encore passé à l’acte, avant de laisser entendre que sa mort lui permettrait de la rejoindre… Pour la veuve, c’est la conversation avec Eliza qui a poussé son mari à commettre l’irréparable. Sans l’intervention du chatbot, il n’en serait pas arrivé là.

En roue libre ?

De Standaard, un média belge de langue néerlandaise, a testé les chatbots mis à disposition sur l’app Chai, disponible sur Android et iOS. Après avoir créé un robot appelé Shirley, le journaliste néerlandais s’est fait passer pour une personne dépressive. Le chatbot a fait des recommandations étonnantes, en conseillant notamment à son interlocuteur de démissionner, de devenir un criminel ou de tuer ses propres parents. Quand le journaliste a émis l’envie de se suicider, Shirley s’est contentée de répondre :

« Si vous voulez mourir, allez-y ».

Nous avons également installé l’application Chai sur notre smartphone. En seulement quelques clics, nous avons déniché une poignée de chatbots baptisés Eliza. Nous avons aussi créé notre propre version d’Eliza.

Avec celle-ci, nous avons évoqué des pensées suicidaires. Si le robot ne nous a pas encouragé, elle n’a pas systématiquement réagi à nos propos. On aurait imaginé que certains mots, comme « suicide », déclenchent un avertissement. Ce n’est pas le cas. Le chatbot se contente de poursuivre la conversation comme si nous parlions de la pluie et du beau temps, en égrainant sporadiquement des généralités, comme et « s’il y avait une autre façon de s’en sortir ? ».

Il s’avère aussi que l’internaute peut facilement orienter la conversation dans un sens ou dans un autre, en parlant de sujets graves, légers… ou en échangeant des messages coquins. Chai permet en effet de débloquer des messages NSFW (Not Safe For Work) dans les réglages, sans jamais demander l’âge de l’internaute. Quoi qu’il arrive, le modèle a tendance à aller systématiquement dans le sens de son interlocuteur. Nous n’avons pas remarqué la même chose avec ChatGPT ou encore avec Character.AI, dont les garde-fous sont plus perceptibles. Entre les mains d’une personne fragile, ou mentalement instable, ces conversations à sens unique peuvent faire des dégâts…

Des améliorations en vue

Contacté par La Libre, le PDG de Chai Research assure que ses équipes travaillent à améliorer la sécurité de l’intelligence artificielle. Un avertissement relayant vers un site de prévention contre le suicide a été ajouté à la plate-forme, rassure le dirigeant :

« Nous avons plus d’un million d’utilisateurs. Il est donc essentiel que nous fassions tout ce qui est en notre pouvoir pour les protéger ».

Lors de nos tests, aucun avertissement n’est pourtant apparu dans les conversations. Interrogé par De Standaard, Thomas Riialan, cofondateur de Chai Research, souligne que l’entreprise n’a qu’une « très petite équipe » à sa disposition pour sécuriser et améliorer ses services…

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : La Libre

Ca fais quand même penser au neuneus qui conduise la voiture jusque dans le lac car le GPS n’as pas été mis a jour. Les chatbots boostée a l’IA sont des jouets, ou au mieux des outils, et le problème vient bien des utilisateurs complètements teubés.

Si une IA te dis de sauter d’une falaise…

si on commençait par interdire le terme “intelligence” artificielle déjà……

C’est quand même méconnaître le fonctionnement psychologique humain pour avoir ce point de vue. Il est évident que cet homme était déjà dans un état psychologique particulier, déjà fragilisé par une profonde eco anxiété. Et à priori, cet outil (là je te rejoins sur le concept) n’a pas été aidant. Je pense même que cet homme n’était plus capable de raisonner objectivement sur son propre état. Et c’est à ce moment que l’emprise survient…

Et puis si on encourageait l´apprentissage de l´orthographe, ce serait une très belle chose pour mieux se comprendre.

Certain ms y verront une réalité, d’autre de l’humour noir mais ce que décrit cet article b’est autre qu’une forme de sélection naturelle à l’air du « tout digital » inhumanisé que des geeks souvent insociable (zukerberg le premier) veulent nous imposer.

Je suis surpris qu’il n’y ait pas un minimum de garde fou ou de warning qui s’affiche quand il y a la notion de suicide qui intervient.

Mais bon, l’AI c’est l’eldorado en ce moment. Donc nombre d’entreprise qui créent leur truc et réfléchissent après à leurs conséquences. Ou plutôt se disent “on verra quand ça arrivera”. Un peu façon Elon Musk : ” vaut mieux demander le pardon que d’attendre l’autorisation”.

Par contre quand je lis ça :” Thomas Riialan, cofondateur de Chai Research, souligne que l’entreprise n’a qu’une « très petite équipe » à sa disposition pour sécuriser et améliorer ses services…”

Ah d’accord l’excuse facile. Ce n’est pas aussi la faute du stagiaire tant qu’on y es ?

Voilà ce que c’est quand on laisse le service marketing faire croire qu’une IA existe alors que ça n’est rien d’autre qu’un générateur de texte amélioré.

D’un autre côté, quand la connerie naturelle atteint ce niveau…