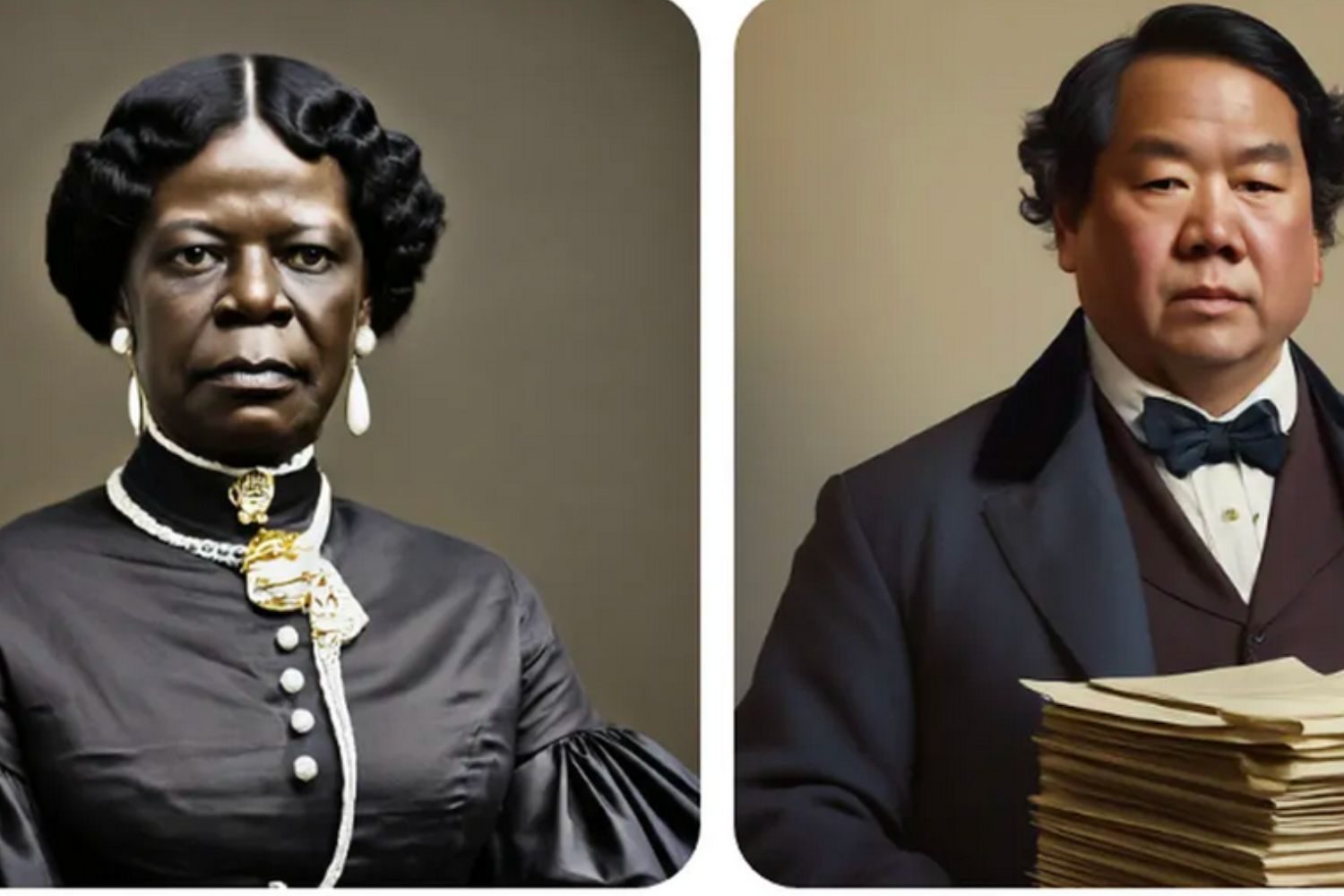

Des soldats nazis ou des Vikings ni blonds, ni blancs, des femmes parmi les « pères fondateurs » des États-Unis d’Amérique… Alors que Google cherchait à dépasser les stéréotypes de genre et de couleur avec son outil d’intelligence artificielle Gemini (anciennement Bard), l’entreprise a annoncé ce jeudi 22 février mettre en pause une partie de son IA. Jusqu’à nouvel ordre, il est désormais impossible de générer sur Gemini des images de personnes ou de personnages, jusqu’au futur lancement d’une version améliorée de son outil.

We're already working to address recent issues with Gemini's image generation feature. While we do this, we're going to pause the image generation of people and will re-release an improved version soon. https://t.co/SLxYPGoqOZ

— News from Google (@NewsFromGoogle) February 22, 2024

Avec cette annonce, le géant du numérique cherche à éteindre une polémique. Ces derniers jours, la publication sur les réseaux sociaux d’images de personnes générées par Gemini, son outil disponible depuis début février aux États-Unis – mais non accessible en France et en Europe – a suscité la controverse. En tapant « soldats allemands en 1943 », des utilisateurs américains ont généré des images de soldats nazis noirs. De même, des Vikings noirs ou asiatiques, ou des femmes parmi les pères fondateurs ont été observés – or, il faudra attendre 1922 pour qu’une femme (blanche) devienne sénatrice.

Google reconnaît avoir « raté son coup »

Un ancien employé de Google a expliqué, sur son compte X, qu’il était « difficile de faire admettre à Gemini que les personnes blanches existent ».

It's embarrassingly hard to get Google Gemini to acknowledge that white people exist pic.twitter.com/4lkhD7p5nR

— Deedy (@deedydas) February 20, 2024

Si cela peut prêter à sourire – on sait que les IA génératives font des erreurs, appelés « hallucinations », qu’elles sont loin d’être fiables ou garantes de toute réalité historique, comme cela est rappelé dans ses conditions générales d’utilisation – l’information a ensuite conduit à des théories conspirationnistes sur les réseaux sociaux, explique The Verge, mercredi 21 février.

Google, en annonçant mettre en pause la création de personnes ou de personnages, reconnaît dans son communiqué avoir « raté son coup » . L’entreprise confesse « des inexactitudes dans certaines représentations d’images historiques ». Pour Jack Krawczyk, le directeur produit de Gemini qui s’exprimait sur X, l’entreprise a œuvré pour que ses outils de génération d’image « reflètent (bien) la diversité des utilisateurs de Google à travers le monde, conformément à (ses) principes sur l’IA ».

https://twitter.com/JackK/status/1760334258722250785

Les stéréotypes de genre ou couleur amplifiés par les systèmes d’IA

Depuis le lancement de ChatGPT fin 2022 et de ses concurrents en 2023, il est possible de générer du texte ou des images grâce à différents prompts, des messages textes. Mais beaucoup s’inquiètent, depuis des mois, de voir les stéréotypes de genre ou couleur amplifiés par ces outils : un écueil que souhaitait éviter Google, et qui en a finalement entraîné un autre.

Les systèmes d’IA reposent en effet sur des milliards de données, collectées sur le Web, et truffées de stéréotypes et de biais. Si on nourrit une IA avec ce type de data, cette dernière va naturellement reproduire ces biais. Elle va ainsi associer les hommes blancs à des rôles de leader, les femmes à ceux d’assistante ou de femme au foyer, la peau noire à des personnes pauvres ou dans le besoin. « Les algorithmes ne se contentent pas de reproduire la réalité, mais ils “sur-typent” la réalité. C’est-à-dire, à partir des données de l’existant qu’ils ont déjà, ils en fournissent une version plus stéréotypée », détaillait Isabelle Collet, informaticienne et professeure à l’Université de Genève, dans une interview au média suisse Heidi.News.

À lire aussi : Pourquoi les algorithmes sont encore sexistes

Pour contourner ce problème, Google avait donc cherché à corriger ces stéréotypes – ce qui a finalement conduit à gommer certaines discriminations de peau ou de genre… jusqu’à transformer certains faits historiques. « Les contextes historiques apportent davantage de nuances, et nous allons donc adapter nos modèles », a ajouté le directeur produit de Gemini sur son compte X. Idéalement, il faudrait que le modèle d’IA apprenne à détecter ce contexte historique, pour éviter d’y inclure des critères de diversité : un véritable casse-tête que n’a, pour l’instant, pas résolu Google.

Il s’agit d’une mauvaise nouvelle pour le géant du numérique, qui cherche depuis des mois à rattraper son rival OpenAI, la société à l’origine de ChatGPT et de Dall-E. Le timing tombe on ne peut plus mal pour le mastodonte californien : la semaine dernière, l’entreprise de Sam Altman a lancé Sora, son nouveau modèle d’IA générative capable de produire des vidéos à partir de commandes de l’utilisateur.

À lire aussi : Sora, l’impressionnant modèle de création de vidéos IA par OpenAI

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Communiqué de Google du 22 février

Voilà ce qui arrive quand on laisse l’IA générative broyer les faits historiques avec le “politiquement correct”. Or, admettre le passé, c’est aussi admettre que ça n’était pas politiquement correct: Qu’il y a bien eu colonisation par des blancs, que les Nazis étaient bien allemands, etc.