Les clichés de la Lune du nouveau smartphone haut de gamme de Samsung sont à nouveau sous le feu des critiques ! Comme pour le Galaxy S22 Ultra l’an dernier, le S23 Ultra lancé en février dernier est suspecté par des utilisateurs de « truquer » les photos de notre satellite naturel. Quand on dit « truquer », on parle ici d’une amélioration de l’image qui serait « contre-nature ». Comprendre que le Space Zoom du smartphone ne capturerait en fait que les contours grossiers de la Lune pour lui appliquer un filtre. Lequel n’améliorerait pas simplement les détails : il en ajouterait.

Si nous n’avons pas encore pu nous livrer à une contre-expertise, il faut reconnaître que les investigateurs en herbe semblent avoir soigné leur mode opératoire. À savoir prendre une photo de la Lune sur le web, convertir le fichier en très basse définition (170×170 pixels), l’afficher sur un écran, puis prendre l’écran en photo… Et constater que des détails absents de la source – une Lune en basse définition – apparaissent sur la photo finale capturée par un Galaxy S23 Ultra !

Lire aussi : Basses lumières et « cinéma » : on décrypte les promesses photo et vidéo du Galaxy S23 Ultra (février 2023)

L’information, très relayée notamment sur les sites « pro » Apple comme AppleInsider fait évidemment couler beaucoup d’encre (numérique). Mais avant de s’insurger de ce « complot » ou d’encenser la « prouesse technique » – ce dont il s’agit en fait, comme nous allons le voir plus loin – faisons d’abord quelques rappels quant à la nature de la photographie sur smartphones. Qui est bien plus éloignée des « vrai » appareils photo que vous ne pouvez le croire.

Tous les smartphones recomposent déjà les photos

Regardez le cliché ci-dessus pris ce week-end à l’Opéra de Bucarest en Roumanie. Le terminal de capture est le très bon Oppo Find X6 Pro (capteur principal de 50 Mpix). En zoomant à 100% sur la seconde image, on voit que la danseuse laisse apparaître des contours « fantômes » qui sont la marque du processus de la capture. À savoir non pas une image unique, mais une séquence de clichés simultanés. Scandale ? Manipulation ? Mensonge ? Non, la norme de la photo sur smartphone. Et le prix à payer pour avoir de belles photos tout le temps.

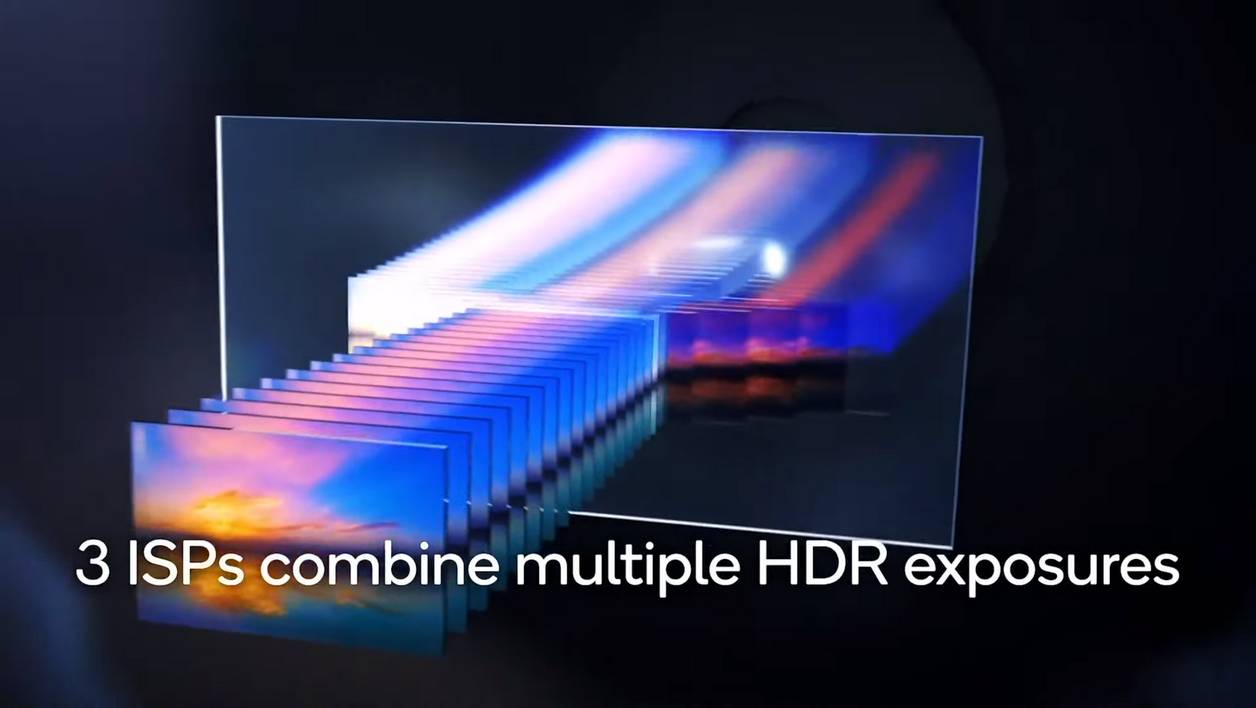

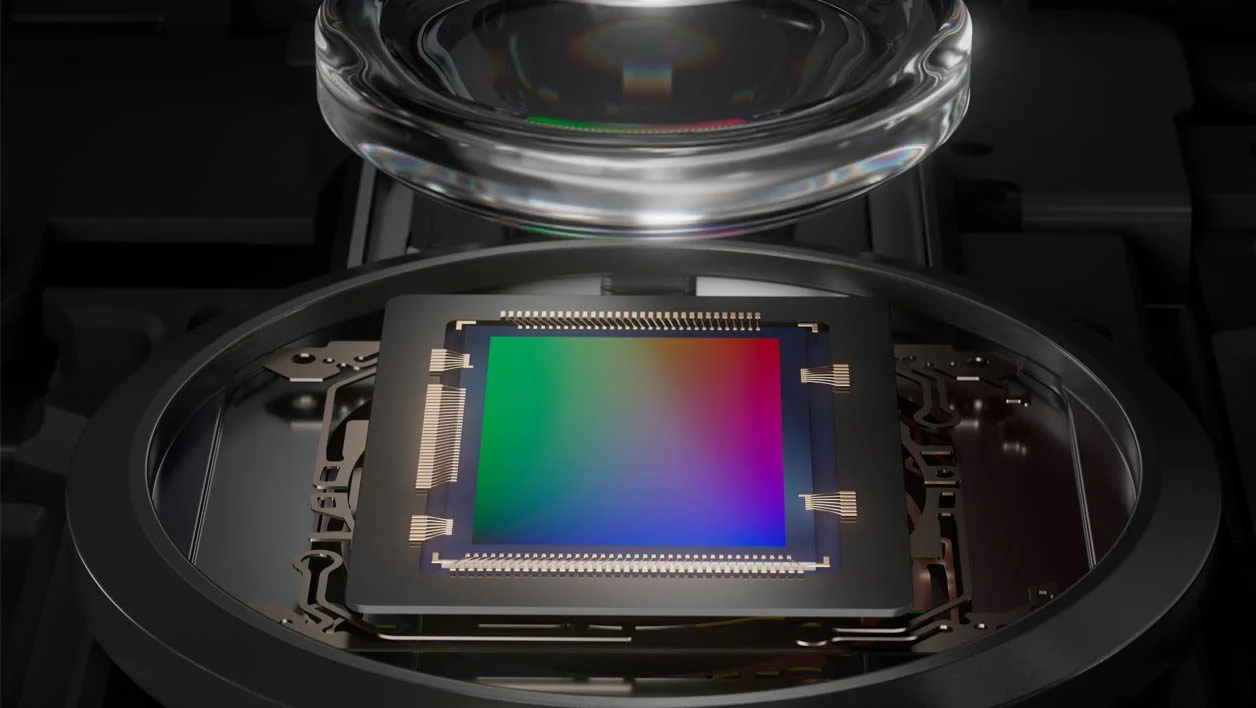

Si les capteurs ne cessent de grandir dans les smartphones – avec notamment cette tendance à l’intégration du capteur Type 1 pouce –, le contexte technologique est toujours le même : les modules caméra des smartphones ont besoin d’un coup de pouce pour produire des images de qualité. C’est d’abord dans les capteurs de smartphone que Sony a déployé ses technologies HDR (trois prises de vue matérielle pour améliorer la plage dynamique) ou encore Exmor RS – le capteur empilé qui peut capturer les images plus rapidement pour la recomposition à postériori. Des technologies qui permettaient de dépasser les limites des petits capteurs.

Dépasser les contraintes physiques

Ensuite, il faut regarder les contraintes physiques qui sont bien plus restrictives que celles des « vrais » appareils photo. Ainsi, le bloc optique d’un Sony RX100 Mark III et d’un Xiaomi 13 Pro tous les deux équipés d’un capteur Type 1 pouce. Le premier dispose d’un corps de boîtier épais ainsi que d’un bloc optique qui se déploie, offrant ainsi à l’ensemble un zoom variable et lumineux (f/1.8 en grand angle et f/2.8 en bout de zoom). Face à lui, plaqué derrière l’écran OLED et la carte mère du terminal, le module caméra du Xiaomi 13 Pro ne dispose que de quelques millimètres pour installer capteur et optique.

Une optique qui s’avère être LE talon d’Achille de l’ensemble. Une faiblesse contrebalancée par des milliards de dollars investis aussi bien dans la qualité des plastiques des lentilles (mettre du verre est souvent trop cher, trop risqué et trop compliqué). Mais aussi et surtout dans les processeurs d’image (ISP) et les algorithmes. Un duo de choc qui a accouché, au fil des années du développement des smartphones, d’un panel d’astuces plus ou moins complexes profitant de la puissance toujours grandissante des processeurs. Cela met en lumière la réalité actuelle de tous les terminaux : à chaque fois que vous pressez le déclencheur de votre application « Photo », une horde d’images sont capturées, des milliers de calculs sont effectués. Pour que l’œil de votre sujet soit net, que les nuages dans le ciel ne soient pas cramés, que l’ombre de l’arbre soit débouchée et que les mouvements soient compensés. La question se pose donc : est-ce toujours la même photographie qu’avec votre boîtier photo ?

Un problème de conception de ce qu’est une photographie

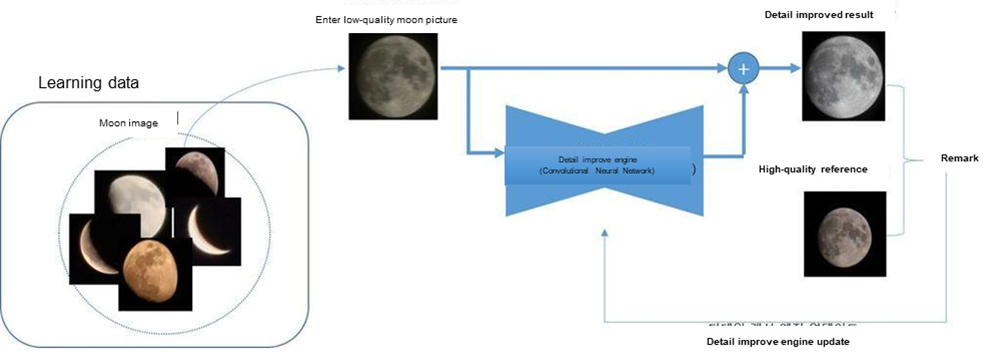

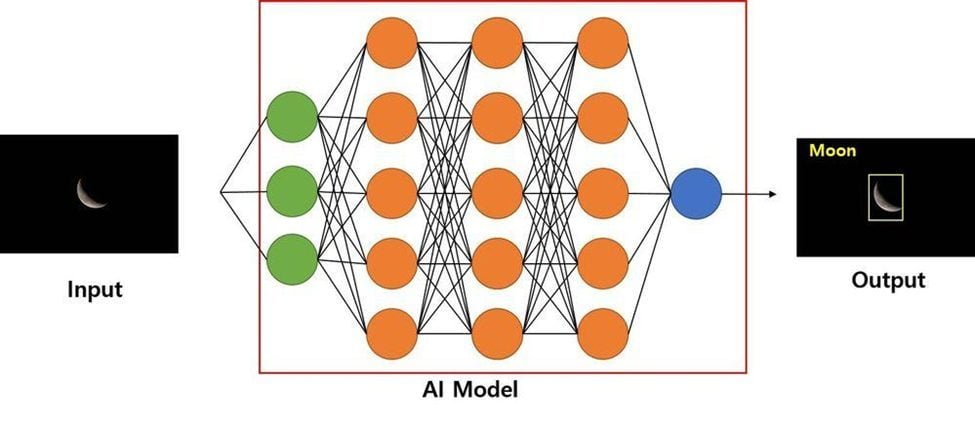

Quand le Galaxy S23 Ultra prend une photo de la Lune, il semblerait qu’il effectue une vraie recomposition de l’image en réinventant des détails qu’il ne saurait être à même de percevoir – les amateurs d’astrophotographie pourraient d’ailleurs nous donner des détails sur les formules optiques des super téléobjectifs et la limite de la perception des détails à distance !

Lire aussi : Entretien : plongée au cœur de la vision photo d’Oppo, avec Simon Liu, son excentrique directeur (mars 2022)

Si c’est bien le cas, il faut nous interroger sur l’élément qui est dérangeant dans la démarche par rapport aux technologies de ré-éclairage des portraits (Apple, Google) où les portraits produits sont non seulement faux compte tenu de la lumière originale… mais potentiellement aussi irréels dans la façon qu’ont les visages de « prendre » la lumière – et ici, la nature est cruelle car des gens beaux ne sont pas forcément photogéniques. On peut aussi se demander si une photo de nuit où le smartphone intègre le mouvement d’un sujet plus tard que l’arrière-plan de l’image est réellement un instantané ou une reconstitution de scène.

Le début de la conversation est technique – les smartphones recomposent les images pour dépasser leurs limites techniques et produire de belles photos sans avoir à les retravailler sur PC. Ce qui satisfait le plus grand nombre et permet à tout un chacun de faire de « bonnes » photos. Mais la suite de la conversation semble quasiment philosophique : quand mon Galaxy S23 Ultra prend une photo de la Lune ce lundi 13 mars 2023 – qui sera une Lune gibbeuse décroissante avec un éclairage à 67% si on en croit les sites spécialisés dans les phases lunaires –, est-ce vraiment cette Lune-là qu’il enregistre… ou une version sublimée ? Avant même que nous fassions nos propres tests, rappelons cependant que Samsung a bien communiqué sur le mécanisme qui entoure la capture de photos de la Lune avec ses smartphones haut de gamme sur ce post.

Il n’y a donc ni mensonge, ni tromperie, mais un gros effort de développement logiciel pour reconnaître la Lune (exposition, température de couleur) et appliquer, au moment de la prise de vue, une routine d’amélioration (issues de l’apprentissage profond). Quant à la preuve de la qualité de l’image perçue à l’écran par les détracteurs, ceux-ci semblent oublier que l’affichage temps réel de l’écran de smartphone à la prise de vue du smartphone est un flux vidéo compressé. L’essentiel de la mémoire tampon est utilisée à stocker plusieurs images en RAW, des fichiers qu’il serait trop couteux en processing et énergie d’afficher. Mais le débat va bien évidemment plus loin que ce cliché de Lune.

Le facteur bénéfice/risque des algorithmes

Outre le débat philosophique de l’image « souvenir » qui est enregistrée, s’ajoute aussi une question plus épineuse : jusqu’où les photos « recomposées que produisent les smartphones peuvent-elles être jugées être représentatives de la réalité ? Si la Lune n’est pas la Lune, si les algorithmes « améliorent » les visages, alors quel type de photo peut être jugé recevable comme une preuve face à un jury de tribunal ? C’est tout le paradoxe des progrès techniques dans la photo sur smartphone : alors qu’ils ont rendu les clichés plus lisibles, plus propres et plus « justes » techniquement (peu de flous, moins de zones bouchées ou cramées, plus de détails, etc.), les nouvelles « boîtes noires » que sont les algorithmes rebattent les cartes de la crédibilité des clichés.

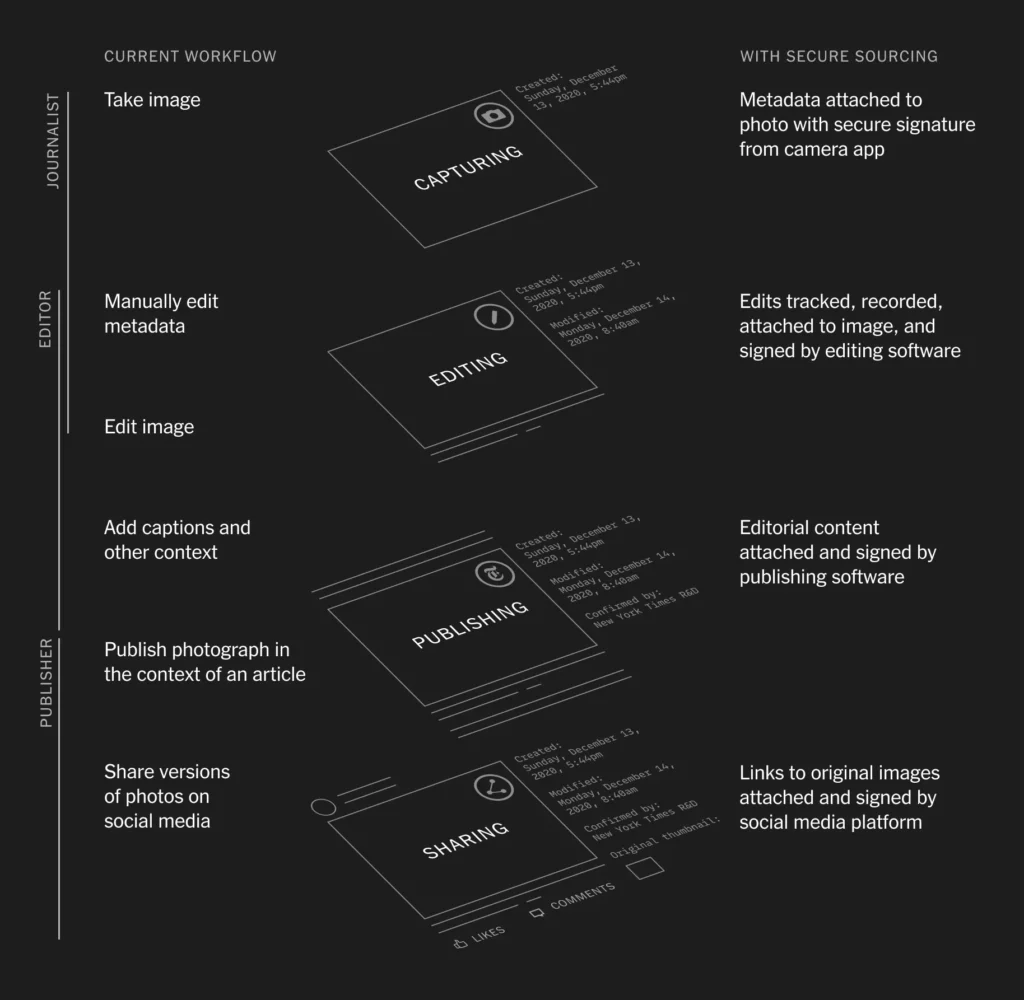

Si du côté du grand public le débat s’arrêtera peut-être à des logos indiquant que les photos de tel ou tel mode sont « améliorées », il existe cependant déjà un début de cadre technique pour encadrer la production d’images. Appelé CAI, pour Content Authenticity Initiative (initiative d’authenticité du contenu), cette suite de vérification matérielle (SoC, appareils photo) et logicielle permet de retracer le parcours d’une image de la prise de vue en passant par les recadrages et autres corrections de couleurs, courbes, etc.

Initié par Adobe et le New York Times, puis par Qualcomm qui développé la première puce compatible, la CAI est désormais prise en compte par les marques d’appareils photo – Leica, Nikon et Sony. Mais si ce cadre est utile pour la certification des images après la prise de vue, rien n’est pour l’heure prévu pour encadrer le moulinage logiciel pendant la prise de vue. Le tintamarre autour du Space Zoom de Samsung pourrait donc être un point de départ pour acter des améliorations « naturelles » et donc acceptables. Et de celle qui relèvent de la falsification. Un débat encore largement ouvert.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Apple Insider

J’ai bien fait de ne pas craquer tout de suite malgré le 8 Gen 2.

Pour le moment je garde mon S-22 Ultra.

Sur certaines photos comme la Lune ou avions de ligne, je me pose aussi des questions…..

Mon galaxy s20 faisait de tres bonnes photos de la lune le s23 fait mieux rien de bien étonnant pour un capteur ayant 200 milions de pixel et les nouveaux algorithmes qui donne une non linéarité des pixels intermediaires. En fait la photo finale est en 12 millions de pixels quand on est en position 3/4 . De plus quand on sait reelement comment sont prises les photos on comprends mieux . C’est un peu compliqué a expliquer sans schéma dans un commentaire .

16 photos sont prises au meme moment grace a la matrice de 16 pixels qui va permettre une sorte de mode hdr puis celon les explications on peut moyenner ces 16 photos avec en principe 22 autres qui sont prises les unes a la suite des autres si on est en mode nuit ce qui fait 16×22 photos . Cette methode de moyennage etait utilisée en astronomie pour supprimer le bruit de fond ou disparité que l’on constate sur les capteurs ou les pellicules photographiques .