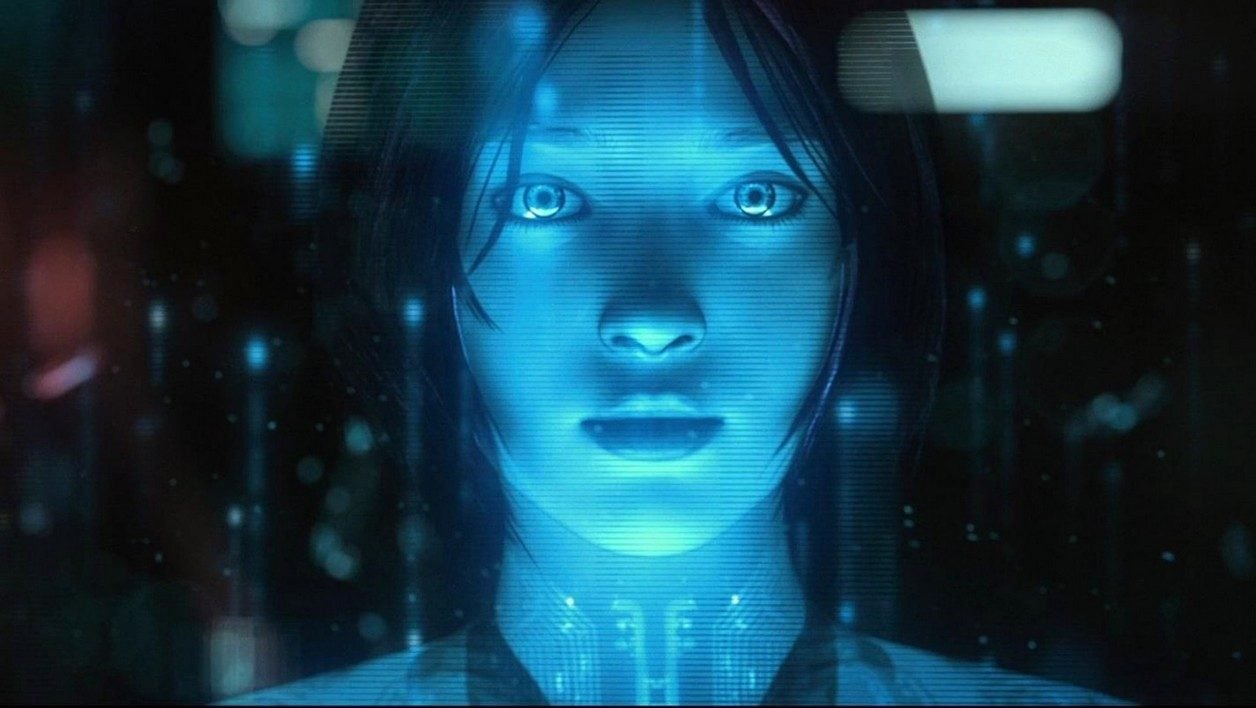

Faites l’expérience d’interroger Siri sur son sexe, l’assistant intelligent vous répondra qu’il n’en a pas, comme la plupart des assistants vocaux du marché. Pourtant son identité féminine ne fait pas de doute vu son prénom, et même s’il est disponible aussi en une voix masculine. Parmi les derniers-nés du marché, on compte Léa de Carrefour qui va bientôt aider les clients à gérer leurs listes de courses. Mais il existe aussi déjà Alexa (Amazon), Cortana (Microsoft), tandis que Google Assistant n’est accessible qu’avec une voix de femme pour le moment en France.

Cette situation s’explique-t-elle parce qu’il serait plus simple de développer une voix féminine ? Pas du tout. C’est même l’inverse. « Il est plus difficile de créer une voix de synthèse féminine qu’une voix masculine : la fréquence vocale est généralement plus élevée, plus aigüe, plus variable ; c’est plus complexe à gérer », nous explique Christophe Couvreur, vice-président de Nuance et en charge de la synthèse vocale dans cette société. Nuance est célèbre pour avoir fourni les bases de la voix de Siri, mais aussi des assistants vocaux de nombreuses banques, constructeurs automobiles, fabricants de smartphone ou encore opérateurs télécom.

Les demandes des clients de Nuance penchent pourtant majoritairement en faveur des voix de femmes, à l’exception de Domino’s Pizza, ou de certains secteurs particuliers. Cela dépend de la fonctionnalité visée et de l’effet que l’on veut obtenir sur l’utilisateur. Si votre assistant intelligent a une vocation globale de service et doit avoir l’air d’être toujours à votre écoute, il écopera d’une voix féminine, selon Nuance. S’il est attendu sur des conseils précis et des questions d’argent comme un prêt immobilier, on lui infusera davantage de testostérone. Vous commencez à vous dire qu’il s’agit là de stéréotypes misogynes ? Vous avez raison. Des clichés dont nous sommes tous esclaves inconsciemment car nous attendons d’abord d’être servis… par des femmes.

Nous attendons tous d’être servis par une voix féminine

Une étude fait référence sur le sujet chez les géants de la Tech. Celle de Clifford Nass, professeur de communication de l’Université Stanford aujourd’hui disparu, qui a prouvé en 1997 que nous réagissions différemment à une voix synthétique suivant son sexe. Lors de son expérience, les voix masculines étaient perçues comme inspirant davantage de respect et de compétence, tandis que les voix féminines étaient mal ressenties quand elles faisaient preuve d’autorité mais positivement quand elles se montraient compatissantes et sociables. Et cela vaut encore aujourd’hui.

Il est très difficile d’échapper à ces clichés. Tout simplement parce que nous vivons dans une société où les femmes sont majoritaires dans les métiers d’aide à la personne, où l’on donne plus souvent des ordres à des femmes qui occupent des positions professionnelles davantage subalternes ou encore parce qu’elles s’occupent davantage des soins et de l’éducation portés aux enfants. Avec tout l’imaginaire fantasmatique qui va avec de l’hôtesse de l’air à la soubrette, en passant par l’infirmière. Mais ce n’est pas la seule raison. « Les assistants vocaux sont développés par un groupe homogène de développeurs plutôt blancs et hétérosexuels qui ne voient pas de problème à choisir des voix féminines parce que c’est tout simplement cela qu’ils ont envie d’entendre », nous fait observer Isabelle Collet, informaticienne de formation et spécialiste des questions de genre dans l’éducation.

Les géants de la Tech renforcent les stéréotypes

Quand on interroge Microsoft sur les raisons qui l’ont poussé à se fixer sur Cortana, la réponse fuse. « Après des recherches approfondies, nous avons découvert qu’une voix de femme correspondait a priori mieux à ce qu’attendent nos utilisateurs. » Mais c’est le seul à assumer honnêtement son choix, Apple n’ayant pas daigné nous répondre et Google préférant nous avancer une excuse un peu légère. « La voix féminine était déjà disponible sur le moteur de recherche », nous a-t-on ainsi répondu. Voilà qui n’élude pas le problème, puisque la décision a bien été prise à un moment donné de se concentrer sur une voix féminine. Pas très étonnant, vu l’étude citée plus haut. Les entreprises tech ne sont pas philanthropes et vont au plus efficace pour que leur produit fonctionne auprès des utilisateurs. Pas question de les déstabiliser en allant contre leurs idées reçues.

Le problème, c’est qu’en allant dans le sens du public, les géants de la Silicon Valley aggravent le problème. « Donner des voix de femmes aux assistants vocaux, c’est comme une caricature. On sert la soupe aux stéréotypes qui existent déjà. Donc il y a forcément un risque de les renforcer », souligne Isabelle Collet. De quoi alarmer le Centre Hubertine Auclert, qui œuvre pour l’égalité femme-homme et qui a organisé l’année dernière un colloque intitulé « La Belle et le Bot. L’intelligence artificielle est-elle sexiste ? ».

Cet écueil ne vaut d’ailleurs pas que pour le genre. « La projection de stéréotypes sur les voix vaut aussi pour l’âge et la catégorie sociale. Les assistants personnels intelligents comme Siri ont 20 ans pour donner une impression de dynamisme, tandis que celles des banques auront plutôt 30 ans pour inspirer confiance », nous détaille Christophe Couvreur. Et bien entendu, pas question de les affubler d’un accent régional ou social autre que celui de la catégorie dominante de chaque pays.

Suivre le modèle des emojis

La solution se trouve-t-elle dans l’élaboration d’une voix neutre, aujourd’hui tout à fait possible ? C’est ce que Nuance a tenté, à la demande de la société Aldebaran quand elle a développé les robots Nao et Pepper. Il a suffi pour cela d’altérer une voix de femme avec une voix masculine. Mais ce n’est pas une solution pour Isabelle Collet. « Nao et Pepper sont des robots de compagnie. Cela ne peut pas fonctionner dans toutes les situations. Le neutre ne va pas dans le sens d’une logique commerciale. Et notre inconscient est rassuré lorsqu’il peut identifier un sexe féminin ou masculin lorsque l’on nous vend quelque chose ».

Pepper et sa voix neutre

Le modèle à suivre serait plutôt celui des emojis. Au début de leur popularisation vers 2011, il n’existait que des figures d’hommes blancs et hétérosexuels, censés être universels. Depuis trois ans, les catalogues d’emojis se sont singulièrement diversifiés, affichant des peaux de toutes les couleurs et de tous les âges, ainsi que des orientations sexuelles variées. L’idéal serait donc qu’aucune voix ne soit imposée par défaut lorsque l’on achète une enceinte vocale ou que l’on utilise pour la première fois un assistant intelligent. Et que l’on puisse choisir la voix qui nous convient. Ce sera le premier pas pour lutter contre les stéréotypes. A condition toutefois que la société évolue aussi dans le même temps. Car tant que la place des femmes n’évoluera pas dans la société, nous continuerons d’attendre que les assistants vocaux se conforment aux stéréotypes qui nous entourent.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.