Depuis des années, les chercheurs tentent de donner un sens à l’activité cérébrale, dans l’espoir – un jour – de lire directement dans les pensées. Ce qui serait particulièrement bénéfique pour ceux qui ont perdu la faculté de communiquer, car on pourrait leur créer des interfaces homme-machine nettement plus efficaces.

Malheureusement, les voies de recherche qui avancent le plus vite dans ce domaine sont celles qui utilisent les technologies les plus intrusives. On perce la boîte crânienne pour placer des électrodes directement sur le cortex et, ainsi, enregistrer l’activité cérébrale au plus près des neurones. C’est par exemple ce que fait Neuralink, la société d’Elon Musk. Mais les chercheurs de Meta pensent qu’une voie non intrusive est également possible, grâce à l’intelligence artificielle.

En utilisant des techniques de captation ultra-classiques comme l’électroencéphalographie (EEG) ou la magnétoencéphalographie (MEG), ils ont réussi à créer un modèle capable de reconnaître les paroles qu’un sujet vient d’entendre à partir de son activité cérébrale enregistrée. Plus précisément, ce système peut trouver le bon mot avec une probabilité pouvant aller jusqu’à 73 %, et cela même si ce mot ne faisait pas partie du lexique de la phase d’apprentissage. C’est ce que les chercheurs appellent le « zero-shot decoding ».

Quand c’est non intrusif, c’est peu précis

C’est impressionnant, car les EEG et MEG sont des techniques d’enregistrement particulièrement imprécises. Même si elles utilisent des centaines de capteurs et sont capables de prendre un millier de captures d’activité cérébrales par seconde, elles sont « notoirement bruyantes et peuvent varier considérablement selon les sessions d’enregistrement et les individus pour diverses raisons, y compris les différences dans le cerveau de chaque personne et l’emplacement des capteurs », souligne Meta dans une note de blog.

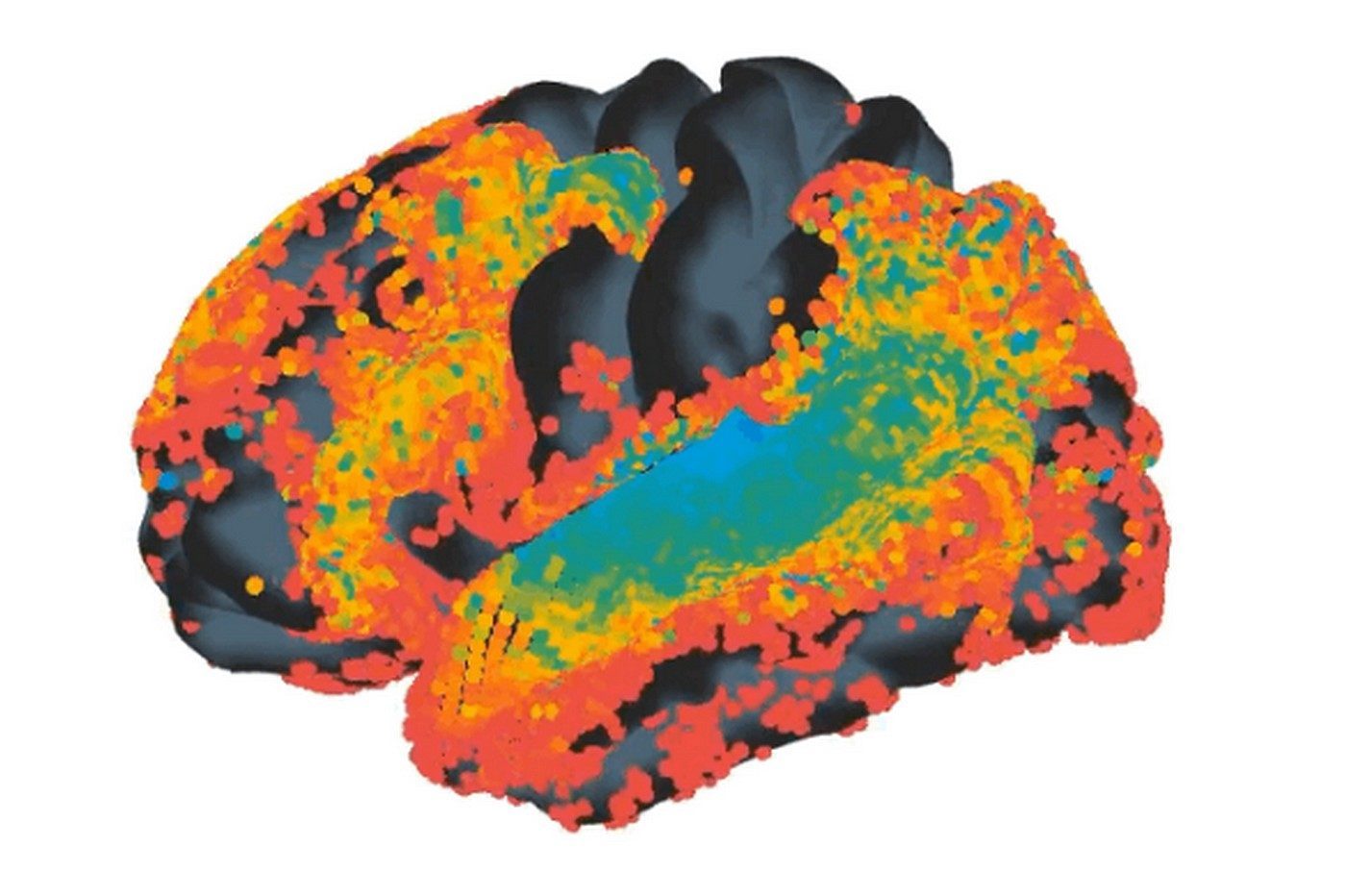

Pour réduire ce bruit, les chercheurs font en réalité travailler deux réseaux de neurones en parallèle. Le premier analyse les paroles (le « speech model ») et le second l’activité cérébrale (le « brain model »). Ces réseaux ont été nourris par un set de données constitué de 150 heures d’enregistrements EEG et MEG provenant de 179 volontaires à qui l’on a fait écouter des livres audio et des phrases isolées. Une phase d’apprentissage appelée « contrastive learning » a ensuite fait correspondre les signaux cérébraux aux bons instants vocaux. Il en résulte une représentation cérébrale de la parole qui, visiblement, est suffisamment efficace pour contrecarrer l’imprécision des techniques de captation.

Our approach:

We developed a contrastive-learning architecture that aligns brain signals to its corresponding speech sounds.

Our "speech module" relies on a self-supervised architecture pretrained on 56k hours of speech: wav2vec 2.0 pic.twitter.com/zgGuDGcux8

— Jean-Rémi King (@JeanRemiKing) August 31, 2022

Autre avantage : cette façon de faire permettrait de limiter le besoin en données pour chaque patient. « Il n’est pas pratique d’exiger des patients qu’ils passent des dizaines d’heures dans un scanner pour vérifier si le système [de décodage] fonctionne pour eux. Au lieu de cela, les algorithmes pourraient être préformés sur de grands ensembles de données comprenant de nombreux individus et conditions, puis prendre en charge le décodage de l’activité cérébrale pour un nouveau patient avec peu de données », soulignent les chercheurs.

Pour Meta, la prochaine étape sera de décoder non pas la parole entendue, mais celle qui se forme dans le cerveau. C’est en réalité le but ultime, car elle permettrait enfin de créer cette fameuse interface homme-machine tant rêvée.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Meta