Je me souviens des étagères remplies de disques vinyles, des caisses de cassettes VHS, des piles de DVD. Parfois, quand j’écoute Deezer, que je regarde Dailymotion, je me souviens de tous ces artefacts disparus, sans regrets. Un smartphone et des milliers de films et de musiques, dans la poche. Et tout ce plastique qu’il n’est plus nécessaire de fabriquer avec du pétrole, de transporter sur des camions. La dématérialisation, c’est bon.

Et puis, une lecture, Cloud Begins With Coal (le Nuage commence par le charbon), instille le doute. Une heure de vidéo par semaine sur mon ordiphone consommerait sur l’année autant que deux réfrigérateurs. Comment ça ? Les réseaux, émetteurs radio, boîtiers branchés tout le temps et les serveurs là-bas dans le Nuage. Sans eux, pas de musique, pas de vidéo.

Le Cloud consomme autant qu’un grand pays

Combien ? 250 à 300 Térawatts-heures (TWh) pour les serveurs du Cloud, environ 500 TWh pour les PC et les appareils numériques, à l’échelle du globe, plus que la consommation électrique des 1200 millions d’indiens. Et pour les réseaux, il faut ajouter 500 à 600 TWh. Un total de près de 1500 TWh. Mille cinq cent milliards de kilowatts-heures.

Cette électricité, il faut la produire à partir de sources d’énergie primaires. Le mixe de l’électricité mondiale est constitué principalement de combustibles fossiles (67% – 2008), de nucléaire (13%) et de moins de 20 % de renouvelables. Au total, quelques 850 millions de tonnes de CO2 injecté dans l’atmosphère pour faire fonctionner serveurs, appareils numériques et réseaux. Un gros nuage.

Depuis, certaines affirmations de cette étude, sponsorisée par l’industrie du charbon, ont été contestées. En particulier, la comparaison frigo / smartphone a été démontée par Jon Koomey, professeur associé à Standford, sommité reconnue dans les questions de consommation énergétique des TIC. L’auteur de Cloud Begins With Coal attribuait à des réseaux 3G des débits caractéristiques de réseaux 4G, qui nécessitent beaucoup moins de KWh par Go transféré. Mais d’autres chiffres (sus-cités) sont étayés par plusieurs sources, dont Jonathan Koomey lui-même.

Des serveurs plus efficaces mais beaucoup plus nombreux

Depuis dix ans, les data-centres sont entrés dans l’âge industriel et leur efficacité énergétique a beaucoup progressé. La conception des serveurs est rationalisée, certains centres sont implantés sur le cercle polaire pour économiser sur la clim’, d’autres revendent l’eau chaude aux bâtiments ou aux serres du voisinage. Sans ces gains, leur multiplication n’aurait pas été possible. La consommation globale des usines à données a quand même augmenté, mais moins vite (+100% entre 2000 et 2005, +56% entre 2005 et 2010, d’après Koomey). Certains acteurs du Cloud cherchent à s’approvisionner en énergies renouvelables, comme le souligne Greenpeace dans son dernier rapport sur la question.

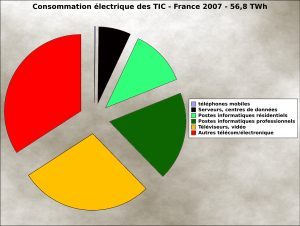

Mais du côté du consommateur, c’est bien pire. Écrans plats, décodeurs, consoles et PC des particuliers consomment 30 % de l’électricité spécifique (hors cuisson, eau chaude et chauffage), en France, contre 10% en 1995.

Depuis quelque temps, on dirait, mon téléphone pèse un peu plus lourd dans la poche.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.