Entraîner les IA prend de plus en plus de temps et coûte de plus en plus cher en temps machine et en empreinte énergétique. Pour s’attaquer à ce problème, les géants ARM, Intel et Nvidia se sont mis d’accord sur un standard de calcul sur 8 bits à virgule flottante FP8. Dans une publication commune, les trois sociétés ont même rendu leur standard FP8 gratuit. Loin d’être de la philanthropie pure, c’est assez logique : ils vendent (directement ou indirectement) des puces pour réaliser ces calculs.

De manière peut-être contrintuitive pour ceux qui mesuraient la puissance des consoles par leur nombre de bits (8 bits pour la NES, 16 pour la SuperNes, etc.) dans le calcul IA, ajouter des bits de précision n’est pas forcément la panacée. Selon les chercheurs des trois entreprises, le calcul FP8 est « le juste milieu » entre la qualité des résultats et la puissance de calcul requise. Un responsable de Nvidia explique que le FP8 propose « une précision comparable » au calcul sur 16 bits dans des tâches de vision informatisée ou de systèmes de génération d’image (comme Dall-E). Tout en permettant des accélérations « significatives » de ces calculs.

Loin de tomber de nulle part, privilégier le calcul FP8 sur les tâches liées à l’image notamment fait consensus dans l’industrie. Qualcomm, par exemple, privilégie déjà l’exécution du FP8 dans ses tests de mesures de performances. Arguant, lui aussi, que ce degré de précision est « suffisant ».

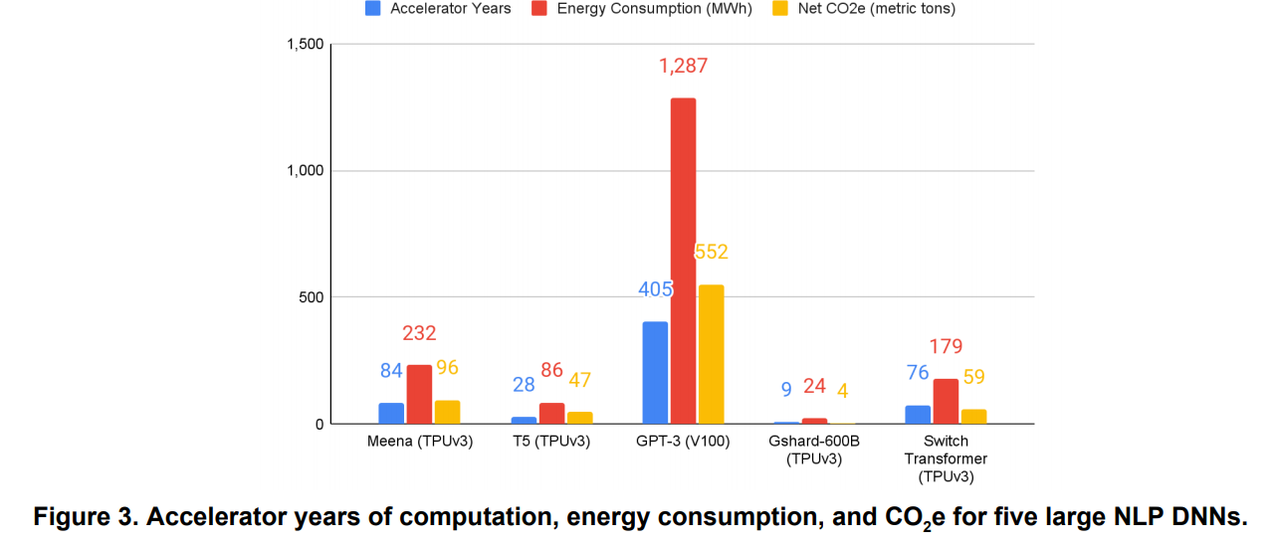

Sur le plan technique, réduire la précision d’un calcul, c’est accélérer l’exécution de la tâche. Une accélération qui offre, par rebond, un autre avantage : limiter le temps/la quantité d’usage des processeurs (CPU, GPU, IA). Or, l’amélioration et la complexification des modèles d’entraînement, comme GPT-3, a poussé à la hausse les factures financières et énergétiques. Les ingénieurs et chercheurs dépensent parfois des centaines de milliers, voire des millions d’euros ou de dollars pour entraîner des IA. Des entraînements dont nous profitons au quotidien : reconnaissance de scène ou de sujet de votre appareil photo, etc.

Si la standardisation du FP8 fonctionne, ne vous réjouissez pas complètement non plus. Cela va limiter les « dégâts » et permettre de gros progrès à la fois en logiciel et en matériel (puces de plus en plus optimisées et efficaces). Mais cela va aussi abaisser le ticket d’entrée et favoriser la généralisation de ce type de calcul dans plus d’industries.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Techcrunch.com