Les fonctions Apple Intelligence ne seront pas livrées au grand public avec les versions finales d’iOS 18 et de macOS Sequoia. Il faudra attendre la version 18.1 des systèmes d’exploitation de l’iPhone et de l’iPad, et macOS 15.1 pour les Mac. Hier, le constructeur a donné un avant goût de ce qui attendront les utilisateurs en la matière, du moins tous ceux qui n’habitent pas en Europe, qui en seront privés au moins jusqu’à la fin de l’année.

Les coulisses des modèles Apple Foundation Model

Apple ne s’est pas contenté de livrer des bêtas d’iOS 18.1 et de macOS 15.1. L’entreprise a aussi publié un nouveau rapport technique qui révèle plusieurs choses dignes d’intérêt. À commencer par le fait que les modèles de langage développés pour Apple Intelligence ont été regroupés sous le terme « Apple Foundation Model » (AFM).

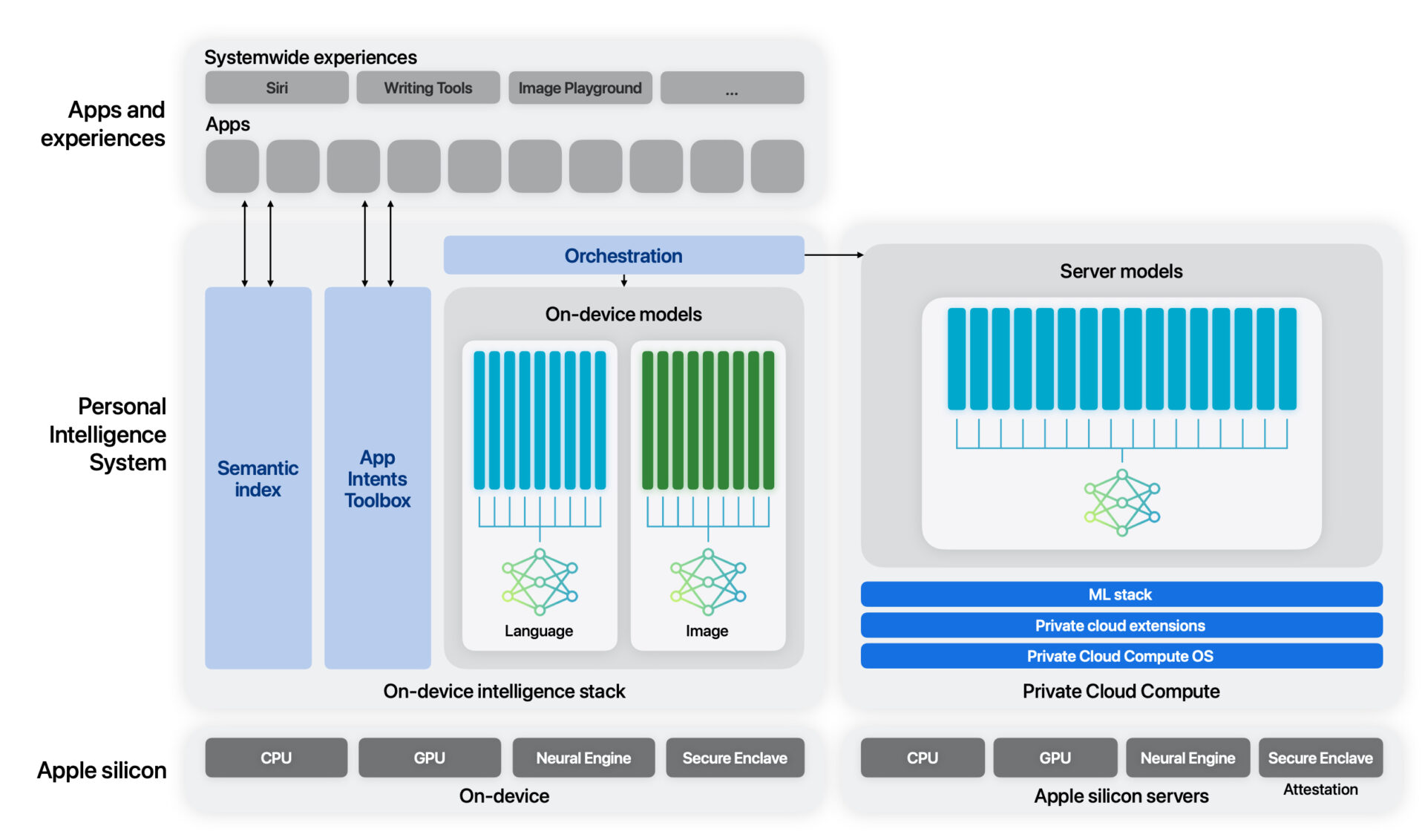

Deux modèles ont été développés : « AFM-on-device », conçu pour fonctionner en local sur les appareils et qui compte 3 milliards de paramètres. Ce qui correspond à peu de choses près à Gemini Nano-2 (3,25 milliards de paramètres) qui s’utilise également en local. Le deuxième modèle, « AFM-server », est comme son nom l’indique destiné à être utilisé sur des serveurs en respectant le cadre de confidentialité du Private Cloud Compute.

Lire Apple dévoile Private Cloud Compute, sa solution pour que l’IA respecte votre vie privée

Ces deux modèles ont bénéficié d’un pré-entraînement de base, autrement dit une formation initiale à partir d’un ensemble de données « de haute qualité » : données sous licence, code provenant de dépôts open-source sur GitHub, ensembles de données publiques accessibles avec des licences… ou encore le web ouvert. Au grand dam des petits éditeurs qui n’ont pas eu leur mot à dire dans ce grand pillage.

Apple explique que cet entraînement a été réalisé sur des clusters TPU (Tensor Processing Unit), donc sur des puces Google. C’est une surprise, sachant qu’une bonne partie de l’industrie — OpenAI, Microsoft, Anthropic — se repose sur des GPU de Nvidia. Google, Meta, ou encore Oracle s’en procurent pour développer leurs propres systèmes IA. Apple a fait le choix de Google, peut-être parce que Nvidia, très demandé, n’avait tout simplement pas de GPU à vendre à Apple !

AFM-on-device, le modèle local, a été entraîné sur une « tranche » de 2 048 puces TPU v5p, la version la plus récente lancée en décembre dernier. L’entraînement d’AFM-server s’est réalisé sur 8 192 puces TPU v4 (qui remontent à 2021), sans qu’on sache si Apple en avait le contrôle complet. Mais si Google produit ses propres puces IA, le moteur de recherche est aussi un gros client de Nvidia, ce qui n’a pas été le cas (pas encore, du moins) d’Apple pour les modèles de son IA générative.

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.