Facebook, Instagram, le New York Times, le Financial Times, USA Today, Condé Nast… Ces éditeurs de presse et ces réseaux sociaux empêchent le robot web d’Apple de puiser dans leurs contenus pour entraîner son IA, selon Wired. Depuis 2015, Applebot parcourt et indexe le contenu des sites web pour alimenter les résultats de recherche de Siri et de Spotlight.

Un robot qui n’est pas le bienvenu

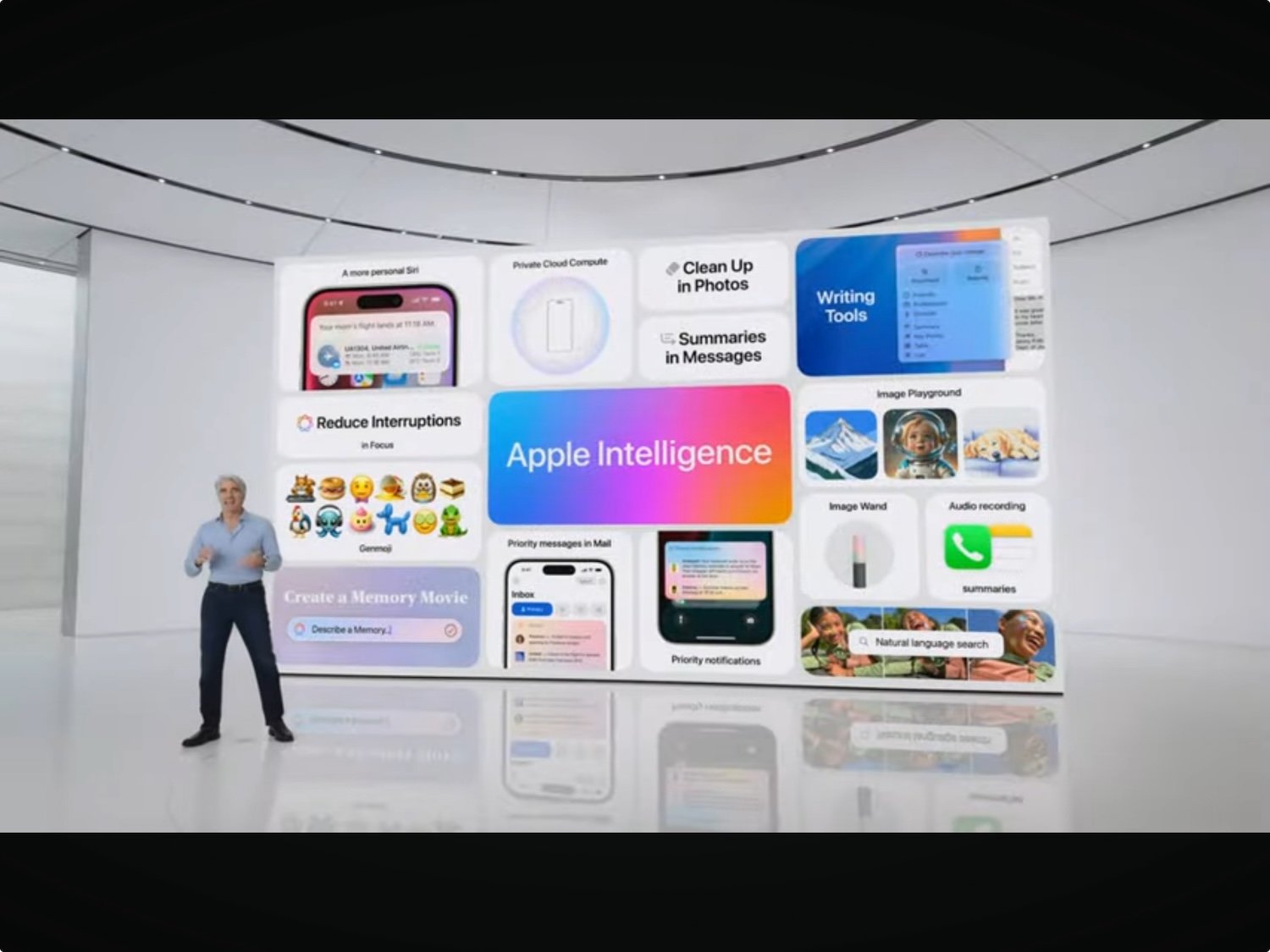

Mais depuis l’avènement de l’IA générative, ce robot — ainsi que ceux des autres entreprises IA — moissonne les contenus pour entraîner les grands modèles de langage (LLM) indispensables aux fonctions d’Apple Intelligence. En juin dernier, la firme à la pomme confirmait qu’Applebot était effectivement mis à contribution pour alimenter et améliorer son IA.

Lire Comme tous les géants de l’IA, Apple pille le web pour entraîner son intelligence artificielle

Mais tout ce qui est publié sur internet n’est pas nécessairement libre de droits. Les éditeurs de presse en particulier voient d’un mauvais œil ces entreprises, dont Apple, puiser dans leurs contenus sans demander aucune autorisation ni payer quoi que ce soit. Sur le principe, cela revient à travailler gratuitement pour l’entreprise la plus prospère et la plus riche du monde…

Les sites web ont cependant la possibilité de dire à Applebot de ne pas collecter leurs contenus. Cela passe par un protocole, Robots Exclusion, qui s’incarne dans un fichier « robots.txt » autorisant ou refusant aux bots l’accès à leurs sites web.

Applebot n’est pas un souci en soi : il est utile pour indexer les articles et les contenus qui apparaitront dans les résultats d’une recherche Siri ou Spotlight. C’est son cousin, Applebot-Extended, qui pose davantage de problème puisque c’est lui qui est chargé de moissonner les contenus pour l’entraînement de l’IA d’Apple.

Et les éditeurs sont nombreux à avoir saisi l’opportunité de claquer la porte à Applebot-Extended… mais pas tant que ça finalement. Une recherche du journaliste de données Ben Welsh montre qu’un quart des sites web faisant partie de son échantillon bloque le bot IA d’Apple, contre 43 % pour le bot de Google (Google-Extended), et plus de la moitié pour celui d’OpenAI. Les éditeurs restent donc encore nombreux à autoriser le bot d’Apple, peut-être parce qu’ils en ignorent l’existence tout simplement.

Le fichier robots.txt, auparavant l’apanage des webmasters, est désormais une arme commerciale entre les mains des gérants des sites web qui peuvent ainsi s’en servir pour négocier un accès à leurs contenus. OpenAI multiplie les accords, par exemple avec Le Monde, pour pouvoir entraîner ses IA. La rumeur court depuis quelques mois qu’Apple négocie également avec des éditeurs de presse. La porte à Applebot-Extended pourrait donc s’ouvrir un peu plus grande…

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.

Source : Wired

C’est toujours le problème du l’opt-in opt-out.

Si c’est pas explicitement interdit, c’est autorisé…

Ça devrait être l’inverse ! Si je ne dis rien c’est interdit.

Perplexity a largement démontré qu’on pouvait contourner les fichiers robots.txt sans aucun problème. Dans la course à la concurrence, il n’ y a pas de morale. Et si paradoxalement j’ apprécie Perplexity, c’ est justement parce que il me donne des sources que les autres n’ont pas…

C’ ‘est sans doute aux Etats de légiférer pour protéger leurs médias. Autrement ce sera la jungle.