On a tous utilisé ou essayé quelques-unes des fonctions d’accessibilité intégrées à iOS, que ce soit pour faire clignoter la lampe torche quand un appel est reçu ou le double ou triple-tape à l’arrière de l’iPhone pour afficher une application ou un réglage. Mais ce ne sont que la partie émergée d’un gigantesque iceberg, que composent les réglages d’accessibilité.

À quelques jours de la journée mondiale de la sensibilisation à l’accessibilité, qui aura lieu jeudi 19 mai, Apple vient d’annoncer une série de nouvelles fonctions pour les personnes souffrant de divers handicaps. Elles ne seront lancées qu’un peu plus tard dans l’année, mais le géant californien en a détaillé malgré tout quelques-unes dans un communiqué.

Prendre la (bonne) porte

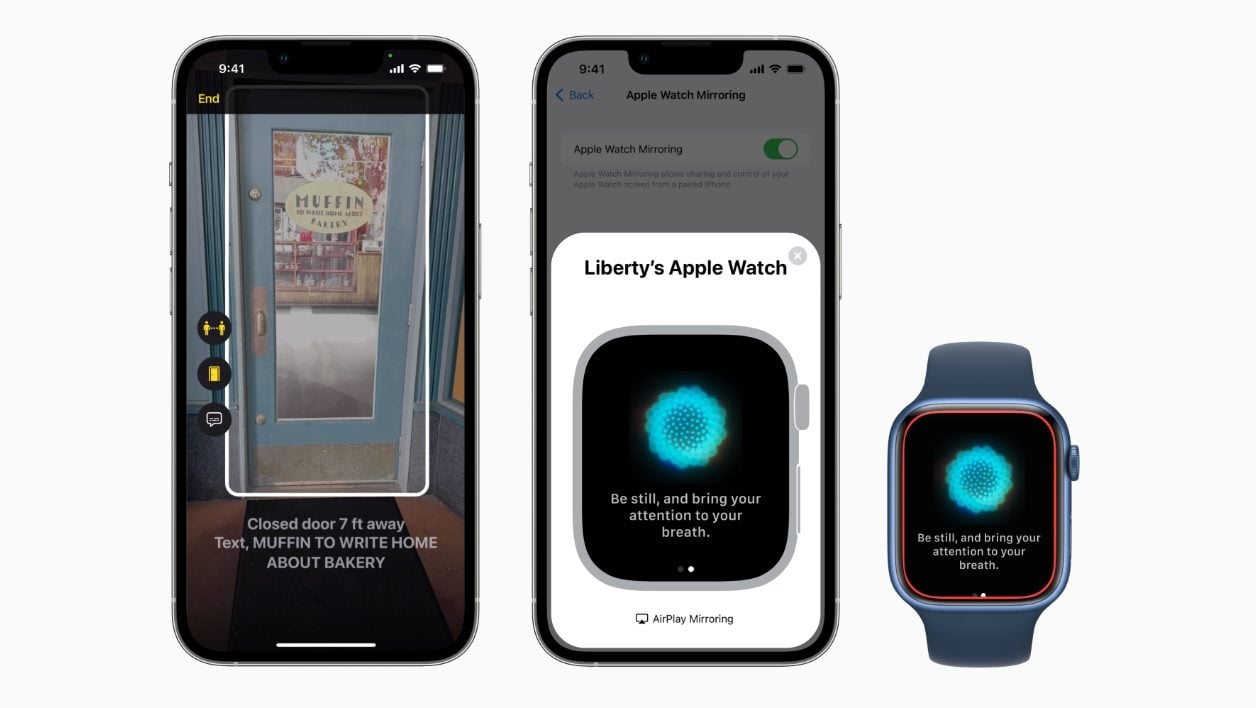

La première d’entre elle s’appelle Détection de porte, et est destinée aux personnes aveugles ou malvoyantes. Son objectif est de permettre à l’utilisateur de trouver la bonne porte quand il arrive dans un environnement qui lui est inconnu. Ainsi, l’iPhone sur lequel est activée la fonction indiquera à quelle distance l’utilisateur se trouve de la porte, il pourra même la lui décrire, en communiquant un numéro éventuel ou un symbole, au-delà de lui indiquer si elle est ouverte ou fermée. L’iPhone précisera aussi le type de poignée dont est équipée la porte, et signalera à son utilisateur s’il faudra la pousser ou la tirer pour l’ouvrir.

Pour fournir ces informations, l’iPhone (ou l’iPad) utilise le lidar et les modules caméras, les données sont ensuite traitées localement par un algorithme d’apprentissage machine.

Cette fonction s’activera dans le mode Détection, au sein de l’application Loupe. Elle s’ajoutera à la fonction Détection de personnes, déjà disponible, et Description d’images. Pour faciliter la navigation dans le monde extérieur des personnes malvoyantes, Apple Plans ajoutera également des rendus sonores et haptiques pour VoiceOver, afin d’indiquer notamment aux utilisateurs dans quelle direction partir à la sortie d’un métro, par exemple.

Des sous-titres à la volée sur iPhone, iPad, et Mac

L’autre grosse nouveauté annoncée par Apple, c’est Live Caption, une fonction qui permettra de sous-titrer n’importe quel contenu intégrant une piste audio. Ce pourra être ainsi un moyen de savoir ce que disent vos interlocuteurs lors d’un appel FaceTime, pendant une vidéoconférence, dans une application de média social ou lorsque que vous regardez une vidéo en streaming – même si la plupart des plates-formes proposent désormais leur propre solution. Sur Mac, lors d’un chat, il sera possible de taper une réponse au clavier et de la faire lire par la machine à « voix haute ».

Ces informations sont toujours gérées en local et ne transitent pas en ligne par les serveurs d’Apple ou d’un partenaire.

Seul petit regret, Live Caption ne sera disponible en bêta que plus tard cette année, et seulement en anglais dans un premier temps. Il faudra posséder un iPhone 11 ou plus récent, un iPad doté d’un SoC A12 Bionic ou suivant, ou d’un Mac Apple Silicon.

A découvrir aussi en vidéo :

Une Watch en miroir…

Par ailleurs, Apple a dévoilé une nouvelle fonction qui permet à un utilisateur ayant des problèmes moteurs d’afficher l’écran de sa Watch sur son iPhone. Il peut alors contrôler sa montre depuis le smartphone à la voix, notamment, ou au travers d’un outil de suivi des mouvements de la tête.

C’est un moyen, selon Apple, de permettre à ces personnes d’accéder aux fonctions de santé avancées de la montre, que sont le suivi du rythme cardiaque, ou le taux d’oxygène dans le sang.

Par ailleurs, les ingénieurs du géant de Cupertino introduiront de nouvelles actions rapides sur la montre. Il sera ainsi possible de réaliser un double pincement des doigts sur l’écran pour répondre à un appel ou raccrocher, pour fermer une notification, ou pour lire un morceau. Une fonction qui pourrait trouver des fans chez tous les utilisateurs.

Enfin, Apple a listé d’autres nouveautés de moindre importance, mais qui pourraient toutefois changer la vie des personnes en situation de handicap. Buddy Controller permettra ainsi à un joueur de demander de l’aide à un autre joueur, afin de combiner les instructions provenant de deux manettes différentes pour une partie à un seul joueur.

Il sera également possible de régler le délai d’attente de Siri une fois qu’on l’a sollicité, afin que l’assistant patiente plus ou moins longtemps. Enfin, Sound Recognition, qui avait déjà été présenté par le passé, aura pour but d’alerter un utilisateur si le carillon de la porte du domicile a sonné ou si une alarme incendie s’est déclenchée.

Il est fort possible que les équipes de Tim Cook reviennent sur ces annonces le 6 juin prochain lors de la conférence d’ouverture de la WWDC 2022, qui se tiendra principalement en ligne.

Source : Apple

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.