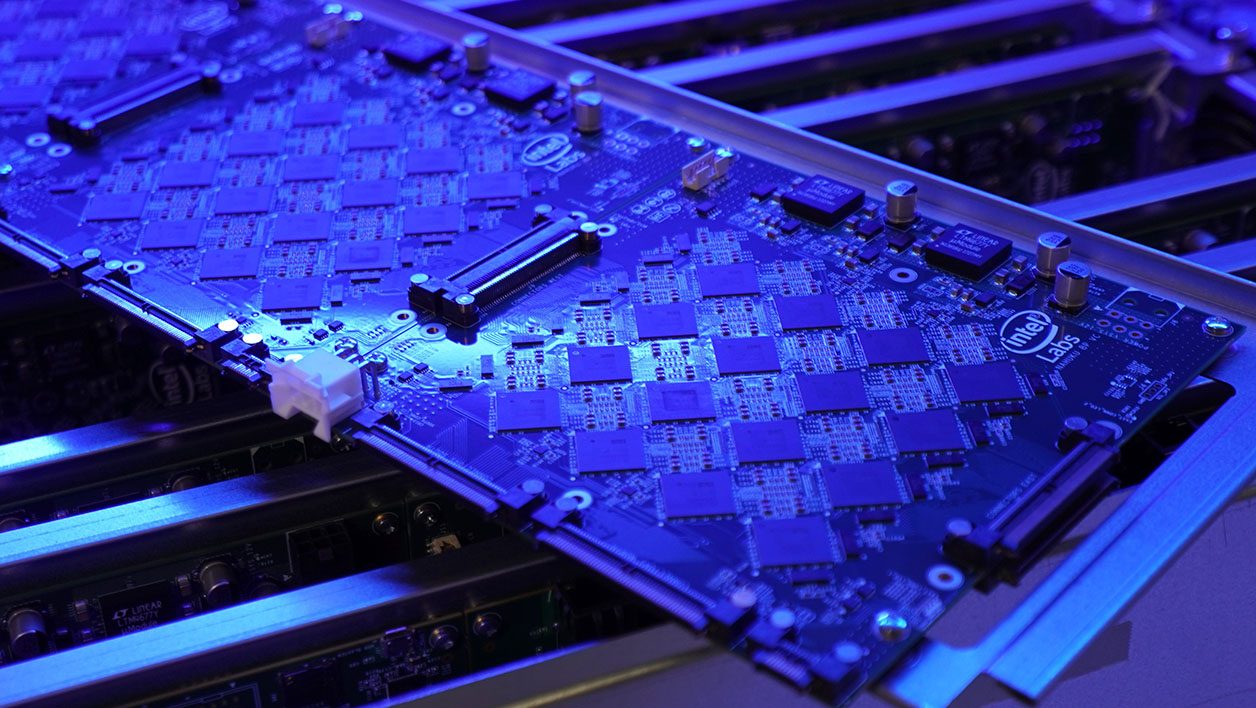

Après avoir dévoilé son ordinateur Pohoiki Beach et ses 64 processeurs neuromorphiques « Loihi » l’an dernier, Intel annonce la disponibilité prochaine de Pohiki Spring. Un gros rack pour serveur qui embarque cette fois pas moins de 768 processeurs Loihi pour offrir un total de 100 millions de neurones numériques à la plate-forme. Multipliant ainsi par x12,5 la puissance de son cerveau numérique.

« Auparavant le système s’approchait du cerveau d’un insecte, là nous sommes au niveau d’un rat-taupe (1) », explique Mike DAVIES, responsable du laboratoire de calcul neuromorphique d’Intel. Un laboratoire qui a fêté en début de semaine sa première victoire : un de ses chercheurs, Nabil IMAM, a mis au point des algorithmes mettant en lumière la supériorité des processeurs neuromorphiques sur les puces classiques. Le cas présenté était la constitution d’un « nez numérique » capable de reconnaître les odeurs bien plus rapidement et précisément qu’un système conventionnel.

Alors qu’un algorithme basé sur l’apprentissage profond (et des processeurs classiques) a besoin de 3000 caractérisations olfactives pour obtenir un taux de réussite de 92 %, la puce Loihi est tout aussi précise en n’ayant été confrontée à l’odeur qu’une seule fois. « On soumet les résultats de la captation d’un seul échantillon au système, comme du méthane, et il l’apprend. Dès qu’on le lui soumet à nouveau, il s’en souvient. Et contrairement à l’apprentissage profond, l’ajout de cette nouvelle information dans la mémoire du système ne modifie pas les informations déjà stockées. Le temps d’apprentissage est donc bien plus rapide », détaille Nabil IMAM.

(1) : à priori le rat-taupe d’Ansell selon cette classification.

768 processeurs pour seulement 500 watts

Loin d’être une course à la puissance pure, les processeurs neuromorphiques sont surtout là pour leur extrême sobriété énergétique. « La plate-forme Pohiki Spring que nous annonçons comprend 768 processeurs Loihi plus des puces FPGA et ne consomme que 500W », s’enthousiasme Mike DAVIES. « On utilise quelques millijoules pour réaliser une classification qui s’opère en quelques millisecondes », ajoute-t-il. Car si ces 500 W sont équivalents à la consommation d’un PC de bureau un peu puissant, les capacités de calcul sont toutes autres. « Contrairement aux processeurs classiques qui opèrent des multiplications à toute allure, nos processeurs neuromorphiques fonctionnent comme nos neurones, c’est-à-dire avec des pics d’activité. Et ils peuvent aller très, très vite ».

De plus, contrairement à un système classique qui traite les données par fournées, les calcule puis soumet les résultats à l’issue d’un travail qui a consommé beaucoup d’énergie, « les processeurs neuromorphiques traitent les données les unes après les autres avec très peu d’énergie. Et surtout les modèles apprennent et s’adaptent en temps réel ».

Les puces sont, comme nos neurones, plus fortes en groupe ce qui explique la constitution d’un tel système réunissant 768 processeurs. Des processeurs Loihi qui sont rigoureusement identiques à la puce lancée début 2018. Pourquoi diable Intel, géant des semi-conducteurs n’ajoute-t-il pas plus de « neurones » dans une puce, comme il le fait avec ses processeurs x86 classiques depuis 40 ans ?

« Pour des questions de coûts et de flexibilité », poursuit Mike DAVIES. « Un processeur plus gros et/ou dense serait cher à produire. Avec ses 128 “cœurs” de neurones dans une puce, Loihi représente le bon équilibre de taille/puissance. Il est suffisamment petit pour être placé dans un petit dispositif et on peut additionner les puces pour des besoins de calcul plus importants », justifie-t-il. Intel étant Intel, « dans le futur on pourrait voir arriver des puces spécialisées dans les centres de calcul d’un côté et de plus petites puces pour être intégrées à de petits objets. Mais nous n’en sommes toujours qu’à un stade de recherche ». Une recherche qui a moins besoin de silicium, que de programmes adaptés.

Des algorithmes et des usages à inventer

S’il s’est écoulé deux ans entre le lancement de la puce et ces premières annonces de résultats probants, c’est que la littérature, les programmes et autres algorithmes n’en sont qu’à leurs balbutiements. « Le défi actuel est purement logiciel : il faut trouver de nouveaux algorithmes et en produire un éventail assez large afin de résoudre beaucoup de problèmes que l’informatique conventionnelle n’arrive pas à traiter de manière efficace, notamment sur le plan énergétique, comme les problèmes NP (qui permettent, par exemple, de déterminer le chemin le plus court en plusieurs villes, ndr) », précise Mike DAVIES.

Car les puces neuromorphiques n’ont pas, pour l’heure, l’ambition de remplacer nos bons vieux CPU et GPU traditionnels, mais plutôt de les épauler dans les problèmes qu’ils gèrent difficilement. Leur mode de fonctionnement intrinsèque devrait ainsi leur permettre de trouver une place « dans tous les environnements où on a besoin de faible latence et d’une faible consommation énergétique comme l’assistance à la conduite (ADAS). Et de manière générale dans tous les domaines impliquant du calcul en temps réel et des déplacements dans le temps et l’espace ».

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.