C’est une scène qui pourrait rappeler quelques souvenirs aux fans de la série Black Mirror. Mais point de science-fiction ici. Il s’agit d’une vidéo conçue par Facebook pour vanter Ego4D, une nouvelle initiative en matière d’intelligence artificielle. S’il ne s’agit à l’heure actuelle que d’un concept, elle présente bel et bien les ambitions un peu dingues de la firme en matière d’IA.

On peut notamment y voir une femme vider les placards d’une chambre, à la recherche de la précieuse montre de grand-mère. Heureusement, l’IA de Facebook est là.

Grâce à un appareil wearable (qui n’est pas visible, on suppose qu’il s’agit de lentilles de réalité augmentée), elle va très vite savoir où le bijou se trouve. Elle demande ainsi à haute voix : « Mais où ai-je pu mettre cette montre ? ». Immédiatement, le placard dans lequel la montre est mis en évidence par l’appareil qu’elle porte. Et en quelques secondes, elle a retrouvé l’objet.

« Dans le futur, des systèmes de vision informatique pourront répondre à ce genre de questions, en comprenant toutes les vidéos préalablement enregistrées par la caméra wearable […], comme une mémoire parfaite de votre expérience visuelle » explique ainsi Kristen Grauman, chercheuse chez Facebook AI, dans la vidéo.

Un nouveau set de données pour les IA de demain

Ceci n’est qu’un des exemples mis en avant par Facebook pour expliquer le travail que l’entreprise vient d’entamer, avec le concours de 13 universités et labos, sur Ego4D.

Ce « nouveau projet de recherche ambitieux pour faire progresser la compréhension du monde par l’IA via une perspective égocentrique » (ouf) n’en n’est évidemment qu’à ses balbutiements. Il va consister à entraîner des modèles d’intelligence artificielle à partir de vidéos filmées à la première personne.

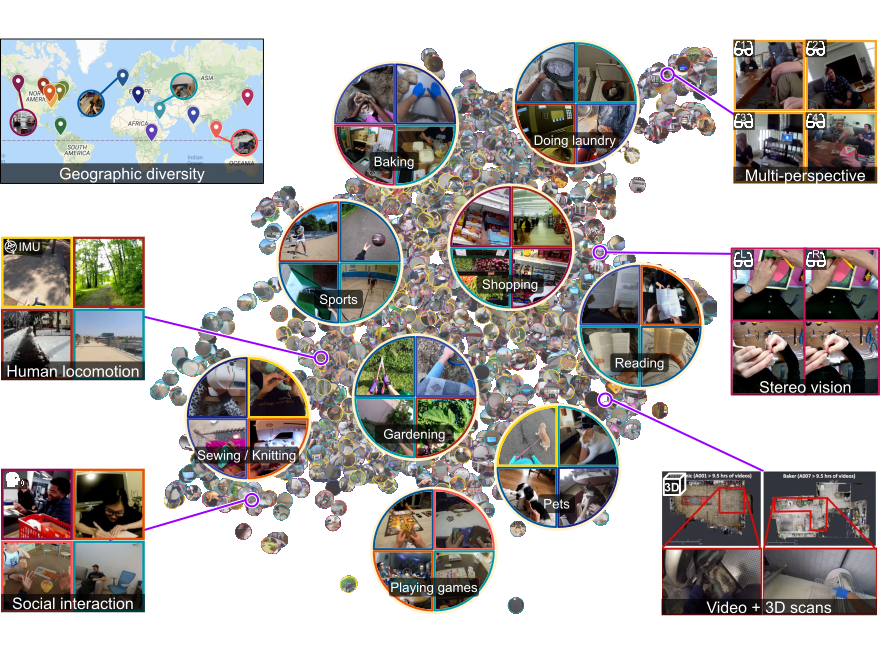

Facebook et ses partenaires ont réuni un corpus impressionnant de plus de 3 000 heures d’images, grâce à la participation de plus de 800 individus d’âge et de sexe divers dans neuf pays différents, qui ont partagé des instants variés de leur vie quotidienne (cuisine, shopping, travail manuel, jeu, bricolage, etc.) Une diversité loin d’être anodine, censée éloigner les risques de biais algorithmiques.

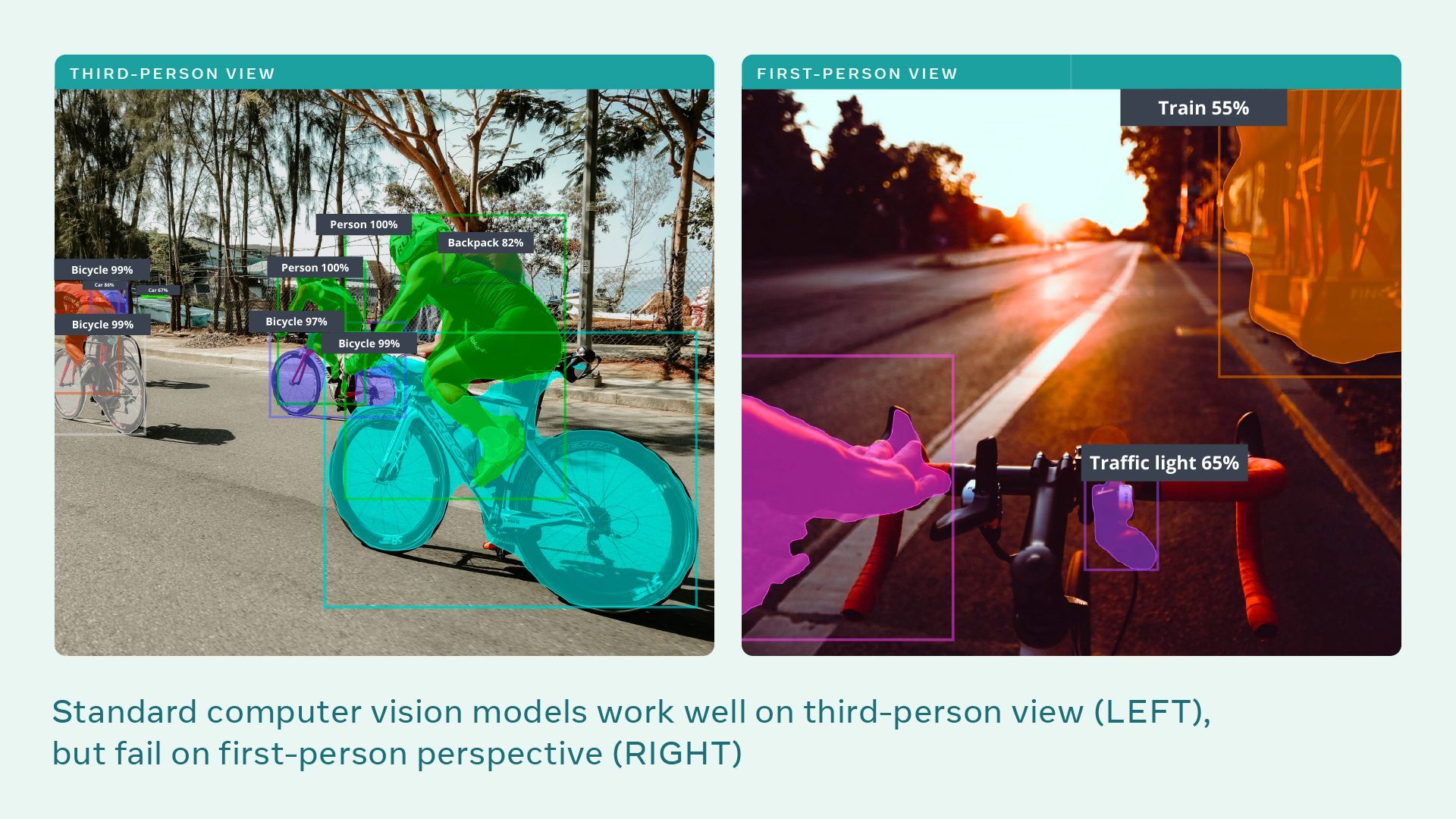

Ces vidéos, « à perspective égocentrique » donc, sont un champ nouveau pour les IA, traditionnellement entraînées avec des photos ou vidéos « à la troisième personne ».

Elles seront pourtant indispensables pour tenter de concevoir le « metaverse » que certains géants de la tech, dont Facebook, appellent de leurs vœux.

Comme l’écrit Kristen Grauman, « pour que les systèmes d’intelligence artificielle interagissent avec le monde, comme nous le faisons, la recherche en IA doit évoluer vers un tout nouveau paradigme de la perception à la première personne. Cela signifie apprendre aux IA à comprendre des activités quotidiennes à travers les yeux humains, dans un contexte de mouvement en temps réel, d’interaction, et d’observations multisensorielles ».

L’intégralité des données collectées sera librement accessible sur le site du projet dès le mois prochain.

Comme on peut le voir dans l’image ci-dessus, un modèle d’IA classique est parfaitement capable de détecter des vélos ou des individus à la troisième personne. Mais se plante complètement quand dans son analyse à la première personne. L’ambition d’Ego4D est notamment de corriger cela.

Des défis ambitieux pour des assistants plus intelligents

Reste encore à savoir comment travailler avec ce corpus. Pour cela, Facebook et les universités réunies dans le consortium Ego4D ont également mis au point une série de « challenges » à accomplir pour rendre ces données vraiment utiles dans le futur.

Autrement dit « des briques fondamentales qui pourraient constituer la base d’assistants IA plus intelligents ou de robots », selon Facebook.

Ils sont au nombre de cinq.

Le premier, baptisé « mémoire épisodique », est celui que nous décrivions au début de cet article. Dans ce scénario, une IA pourrait « étendre votre mémoire » en enregistrant, puis en retrouvant des « moments clés du passé » à partir d’une collection de vidéos à la première personne.

On pourrait par exemple demander à un futur assistant « ou ai-je mis mes clés ? ».

Il irait alors chercher dans les images enregistrées par notre appareil wearable le dernier moment où il a vu nos clés, puis nous guiderait vers elles en réalité augmentée.

« Prédiction » consiste à concevoir une IA capable d’anticiper notre prochaine action pour nous aider dans notre vie quotidienne. Un exemple ? Un assistant intégré à des lunettes pourrait nous guider pas à pas dans la réalisation d’une recette de cuisine, en prédisant nos prochains gestes. Il faut donc que l’IA puisse « deviner » la position future de nos mains.

« Interaction objet-main » est sans doute l’un des challenges les plus importants, puisqu’il s’agit d’apprendre aux machines comment les objets que nous utilisons tous les jours changent lorsque nous les manipulons.

Par exemple, lorsque vous cuisinez un oignon, sa forme évolue alors que vous l’émincez avec un couteau. Il faut donc des algorithmes suffisamment intelligents pour comprendre ces différents états, savoir que vous avez transféré l’oignon dans la poêle, et à quel moment, etc.

« Interaction sociale » est consacré aux relations entre individus. Il s’agit pour l’IA de comprendre qui vous parle, ou qui vous regarde, dans des situations de groupe.

Enfin « journalisation audio et vidéo » consiste, comme « mémoire épisodique » à étendre votre mémoire, cette fois en profitant du son, afin qu’une IA puisse répondre à des questions comme « qui a dit ça, et quand ? ».

Facebook évoque un exemple concret : « imaginez que vous suiviez un cours très important, mais que vous soyez à un moment distrait par des échanges de SMS avec votre baby-sitter. Vous pourriez plus tard demander à votre assistant : “quels était le sujet du cours d’aujourd’hui après que le professeur nous a rendu notre examen” ? ».

D’immenses questions pour notre vie privée

Évidemment, tous ces scénarios fascinants sont encore loin d’être une réalité. Le corpus d’Ego4D n’est qu’une première base de travail, et il faudra sans doute attendre de longues années avant qu’une IA atteigne un tel niveau de discernement. Sans compter le hardware : les lunettes à réalité augmentée n’en sont qu’à leurs balbutiements…

Mais Ego4D, et surtout les usages prévus par Facebook, pose toutefois immédiatement d’immenses questions de confidentialité. Car, pour que tout cela fonctionne, l’ensemble des vidéos « à la première personne » capturées par un futur appareil wearable, par nature très intimes, devront être enregistrées et analysées, y compris lorsque vous serez en interaction avec d’autres individus. Étant donné le bilan plutôt catastrophique de Facebook en matière de protection des données personnelles, on est presque surpris de le voir communiquer aussi béatement sur cette technologie disruptive.

Source : Facebook

🔴 Pour ne manquer aucune actualité de 01net, suivez-nous sur Google Actualités et WhatsApp.